Codecs müssen nicht schwer sein. Nein, das müssen sie wirklich nicht. Wichtig ist nur, dass Sie den richtigen Codec wählen.

Am Ende dieses Artikels werden Sie in der Lage sein, für jedes Projekt den besten Codec auszuwählen. Mein Ziel ist es, Ihnen alles zu vermitteln, was Sie brauchen, um Ihre eigenen fundierten Entscheidungen über Codecs zu treffen. So können Sie den richtigen Codec für sich selbst wählen, anstatt sich auf das zu verlassen, was bei jemand anderem funktioniert hat.

Ich werde Sie durch jeden Schritt bei der Erstellung eines Videos führen. Klicken Sie auf eine Überschrift, um zu diesem Abschnitt zu springen. I’ll cover:

- Der Codec, den Sie aufnehmen

- Der Codec, den Sie bearbeiten

- Der Codec, den Sie farbkorrigieren

- Der Codec, den Sie an VFX senden

- Der Codec, den Sie exportieren

- Der Codec, den Sie archivieren

In jeder Phase, erkläre ich, welche Faktoren Sie bei der Auswahl eines Codecs berücksichtigen sollten. Außerdem gebe ich Ihnen einige Beispiele für die am häufigsten verwendeten Codecs für die jeweilige Phase.

Auf dem Weg dorthin behandeln wir, warum Low-End-Codecs und High-End-Codecs Ihre Bearbeitung verlangsamen können, die Gründe für eine Proxy-/Offline-Bearbeitung, einen realen Projektdurchlauf, einige speichersparende Strategien und eine Erklärung, warum Transkodierung Ihre Bildqualität nicht verbessern kann.

Die Vorteile der Optimierung Ihrer Codecs können enorm sein. Wenn Sie den richtigen Codec wählen, bleiben Ihre Bilder in bester Qualität erhalten. Außerdem können Sie damit schneller arbeiten und Ihren Computer und Speicher optimal nutzen. Mit einem Laptop können Sie schneller arbeiten als mit einem High-End-Tower.

Was ein Codec bewirkt

Ein Codec ist eine Methode zur Verkleinerung von Videodateien, bei der in der Regel sorgfältig Daten weggeworfen werden, die wir wahrscheinlich nicht wirklich brauchen. Und sie sind ziemlich schlau darin, wie sie das tun. Vor einigen Jahren habe ich ein Video erstellt, in dem die wichtigsten Komprimierungsverfahren, die viele Codecs verwenden, vorgestellt werden. Man muss es nicht gesehen haben, um diesen Artikel zu verstehen, aber es schadet sicher nicht.

Wie Codecs funktionieren – Tutorial.

Wenn du das Video überspringst, hier einige sehr grundlegende Erklärungen:

- Chroma Subsampling: Wirft einige Farbdaten weg (4:4:4 ist kein Chroma-Sampling. 4:2:2 ist etwas Chroma Unterabtastung.4:2:0 ist viel Chroma Unterabtastung). Schlecht, wenn Sie eine Farbkorrektur vornehmen. Wirklich schlecht, wenn man Green Screen oder VFX-Arbeiten macht.

- Makro-Blocking: Findet Blöcke (unterschiedlicher Größe) von ähnlichen Farben und macht sie alle die gleiche Farbe. Schlecht für VFX und Farbkorrektur. Fast alle Codecs verwenden dies bis zu einem gewissen Grad, und die Menge hängt von der Bitrate ab.

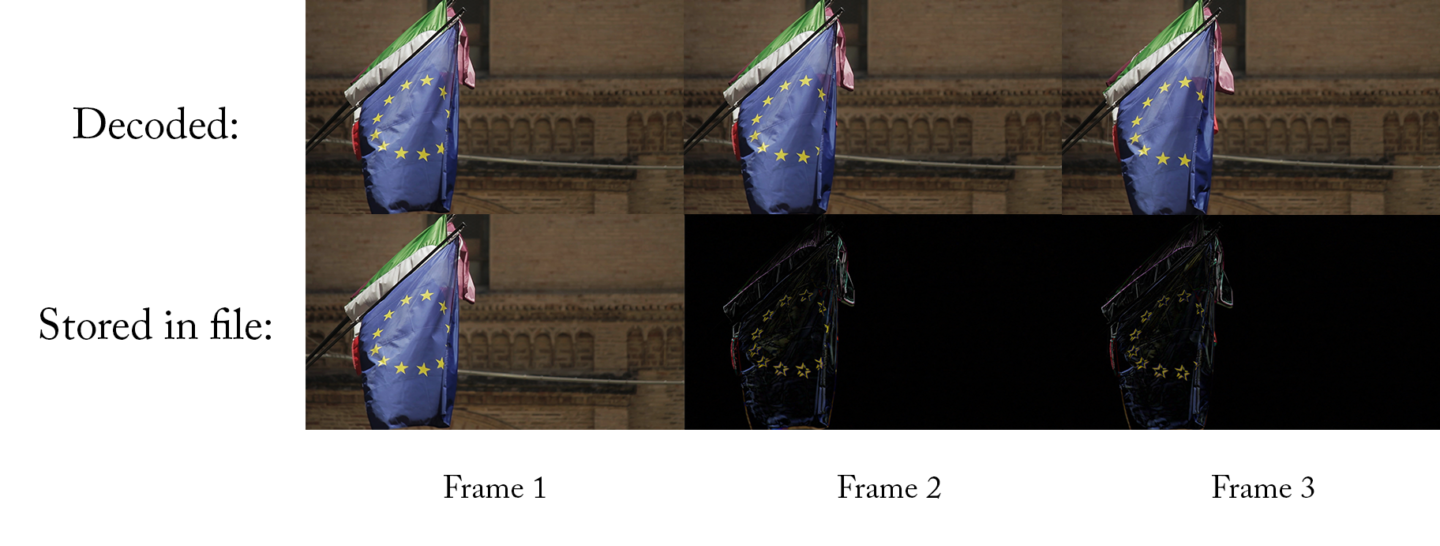

- Temporale Kompression: Verwendet frühere Bilder (und manchmal folgende Bilder), um das aktuelle Bild zu berechnen. Schlecht für die Bearbeitung.

- Bittiefe: Die Anzahl der möglichen Farben. Eine höhere Bittiefe (größere Zahlen) ist gut für Farbkorrekturen und VFX.

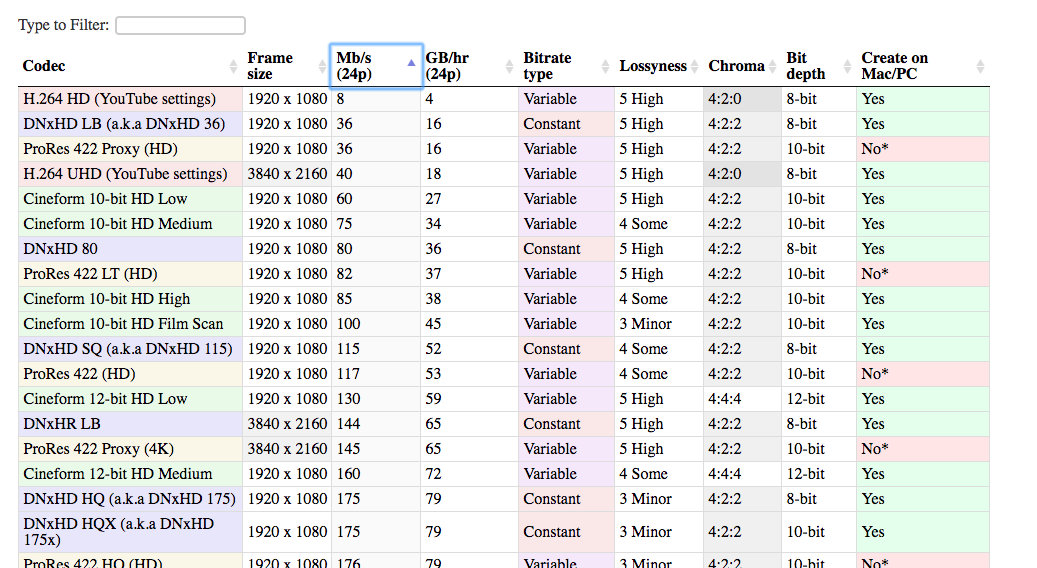

Codec-Vergleichstabelle

Ich habe auch eine Liste der gängigsten Codecs zusammengestellt, die in der Postproduktion verwendet werden. Diese Liste kann Ihnen helfen, verschiedene Codecs miteinander zu vergleichen und die beste Entscheidung für Ihr Projekt zu treffen.

Es gibt viele verschiedene Codecs, die im Bearbeitungsprozess verwendet werden können. Die von mir aufgeführten sind bei weitem die gängigsten. Die Verwendung gängiger Codecs hat einen großen Vorteil. Es ist wahrscheinlicher, dass sie auf Ihrem System, auf dem System Ihres Kunden, auf Ihrem System in fünf Jahren usw. funktionieren. Und es ist einfacher, Hilfe zu finden, wenn etwas schief geht.

Öffnen Sie die Tabelle in einer neuen Registerkarte. Auf diese Weise können Sie Codecs vergleichen, während Sie den Artikel lesen.

Sehen Sie sich die Tabelle an

Lossyness

Eine der Spalten in der Tabelle ist „Lossyness“, ein wichtiges Konzept bei Codecs. Wenn ich von „lossyness“ spreche, meine ich nicht unbedingt das, was Ihr Auge sieht. Ich meine damit die Datenmenge, die vom Codec zurückgehalten wird und von der Sie nur einen Teil sehen können. Die Frage ist: Wenn ich ein unkomprimiertes Bild hätte und es dann mit diesem Codec komprimieren würde, wie ähnlich wäre das neue Bild dann dem alten Bild? Wie viele Informationen gehen bei der Transkodierung verloren? Wenn die beiden Bilder sehr ähnlich sind, dann ist der Codec nicht sehr verlustreich. Wenn sie sehr unterschiedlich sind, ist er verlustbehaftet.

Die Verlustbehaftung ist eine Kombination aus den Techniken, die der jeweilige Codec verwendet, und seiner Bitrate. Ein verlustbehafteter Codec ist nicht unbedingt schlecht. In manchen Fällen (z. B. bei der Online-Ansicht) ist es wirklich nicht notwendig, 100 % des Originalbildes beizubehalten. Die Verwendung eines verlustbehafteten Codecs kann ein wirklich kluger Schachzug sein, weil er viel Platz spart.

Wenn das Bild für mein Auge genauso gut aussieht, warum sollte es mich dann interessieren, ob es technisch „verlustbehaftet“ ist?

Das sollte Sie interessieren, weil Sie das Bild vielleicht ändern wollen. Wenn Sie irgendeine Art von Farbkorrektur vornehmen, werden Sie das Bild verändern. Das Ergebnis könnte sein, dass Sie Elemente des Bildes sehen, die bei der Aufnahme nicht sichtbar (oder hervorgehoben) waren.

Hier ist zum Beispiel ein Bild, das im Rohzustand aufgenommen wurde.

Hier ist ein Screengrab davon, das mit H.264 komprimiert wurde, unter Verwendung der von YouTube empfohlenen Standardeinstellungen.

Und dann komprimiert mit DNxHD 350x:

Sie sehen alle ziemlich gleich aus, nicht wahr? Die visuelle Qualität ist in etwa die gleiche, und die H.264-Datei ist nur einen Bruchteil so groß wie die DNxHD-Datei. Aus diesem Grund ist dies die empfohlene Einstellung für YouTube. Sie sieht für das Auge genauso gut aus, und die Datei lässt sich viel einfacher ins Internet hochladen.

Das Problem mit der H.264-Version tritt jedoch auf, wenn Sie versuchen, Änderungen am Bild vorzunehmen. Was wäre, wenn man die Belichtung erhöhen wollte?

Jetzt können wir sehen, wo das hochkomprimierte Bild auseinanderfällt. Ihr Haar und ihr Hemd sehen im h.264-Bild schrecklich aus, und die Gebäude am Fluss sehen ganz matschig aus.

Deshalb sollten Sie bei der Aufnahme des Bildes wirklich einen hochwertigen Codec verwenden. Denn wahrscheinlich werden Sie später Änderungen vornehmen wollen, aber Sie wissen noch nicht, wie diese Änderungen aussehen könnten. Sie werden die Farbe und den Kontrast optimieren wollen, vielleicht die Geschwindigkeit, vielleicht einige VFX hinzufügen. Eine stark komprimierte Datei lässt diese Änderungen nicht zu, ohne dass sie zusammenbrechen.

Deshalb ist es eine gute Idee, Ihr Material in 10-Bit aufzunehmen, auch wenn Sie am Ende eine 8-Bit-Datei ausgeben werden. Sie wissen bei der Aufnahme nicht, welche Bits Sie brauchen werden.

Die Codec-Reise

Jetzt ist es an der Zeit, die verschiedenen Phasen zu durchlaufen, die Sie in jedem Projekt antreffen werden.

Jedes Projekt beginnt mit einem Codec, den Sie mit der Kamera aufnehmen. Und es endet mit einem Codec, den Sie exportieren (Auslieferungscodec) und Ihrem Kunden übergeben oder ins Internet hochladen. Im einfachsten Fall nehmen Sie alle Bearbeitungen und Farbkorrekturen direkt an den Kameradateien vor. Dann exportieren Sie in Ihren Auslieferungscodec, so dass Sie immer nur zwei Codecs verwenden.

Meistens wird es jedoch etwas komplizierter. Man transkodiert vielleicht in einen anderen Codec für die Bearbeitung, möglicherweise für die Farbkorrektur und definitiv für VFX. Aber alles beginnt mit…

dem Codec, mit dem Sie aufnehmen

(zurück zum Index)

Dies ist Ihr Aufnahmecodec (auch „kameranativer Codec“ oder „Aufnahmecodec“ genannt).

Generell sollten Sie den Codec mit der höchsten Qualität wählen, den Ihre Kamera (oder Ihr Budget) aufnehmen kann. Wenn ich „höchste Qualität“ sage, meine ich damit, dass Sie so viele Informationen wie möglich erfassen wollen. Daher sollten Sie sich für verlustärmere Codecs entscheiden: weniger Komprimierung, höhere Bit-Tiefe und weniger Chroma-Subsampling. Je mehr Informationen Sie bei der Aufnahme haben, desto mehr Flexibilität haben Sie später. Vor allem bei der Farbkorrektur und VFX (falls Sie das tun).

Natürlich müssen Sie bei dieser Entscheidung auch viele andere praktische Faktoren berücksichtigen. Sonst würden wir doch immer 8K-Rohdaten aufnehmen, oder?

Kosten

Der erste Gesichtspunkt sind natürlich die Kosten. Im Allgemeinen gilt: Je teurer die Kamera ist, desto hochwertigere Codecs sind für sie verfügbar. Ich sage „im Allgemeinen“, weil es einige „Sweet Spot“-Kameras gibt, die hervorragende Codecs zu einem vernünftigen Preis anbieten können. Die GH-Serie von Panasonic (vor allem in der Anfangszeit, als die GH2 gehackt wurde) war dafür bekannt, dass sie bessere Codecs bot als andere Kameras in ihrer Preisklasse.

Tipp: Bessere Codecs mit externen Recordern

Eine Möglichkeit, mit günstigeren Kameras qualitativ hochwertigere Codecs aufzunehmen, ist die Verwendung eines externen Recorders.

Diese Geräte (von denen viele auch als externe Monitore verwendet werden können) nehmen ein unkomprimiertes Signal von der Kamera über HDMI oder SDI auf und komprimieren es separat. So erhalten Sie zwei Kopien Ihrer Aufnahmen. Eine Kopie, die auf der Kamera stark komprimiert ist, und eine zweite Kopie, die auf dem externen Recorder leicht komprimiert ist. Entscheidend ist, dass die Kamera das Signal an den Rekorder sendet, bevor sie es komprimiert.

Ein wichtiger Hinweis ist, dass viele billigere Kameras nur 8-Bit ausgeben, und oft nicht in 4:4:4. Ein externer Rekorder kann vielleicht auf einen 12-Bit-Codec komprimieren. Aber wenn die Kamera nur 8 Bit ausgibt, kann der Rekorder auch nur 8 Bit aufzeichnen. Einige billigere Kameras geben möglicherweise auch kein „sauberes“ HDMI-Signal aus, das für die Aufnahme geeignet ist. Wir nennen ein Ausgangssignal „sauber“, wenn es nur das reine Bild ohne Überlagerungen der Kameraschnittstelle ist.

Speicherplatz

Der zweite zu berücksichtigende Faktor ist der Speicherplatz. Hochwertige Codecs haben in der Regel eine höhere Bitrate, was bedeutet, dass die Dateien größer sind. Sie müssen darauf vorbereitet sein, all diese Dateien während der Aufnahme zu speichern und zu sichern. Möglicherweise müssen Sie auch Ihre Speicherkarten aufrüsten, um die Daten mit hoher Bitrate aufzeichnen zu können. Wenn Sie alleine drehen, werden Sie sich vielleicht für einen Codec mit geringerer Qualität entscheiden, weil Sie dann die Speicherkarten seltener wechseln müssen.

Finishing

Ein weiterer Faktor, den Sie berücksichtigen müssen, ist, wie viel Farbkorrektur und VFX (zusammenfassend als Finishing bezeichnet) Sie vorhaben. Wenn Sie nur minimale Farbkorrekturen und keine VFX vornehmen wollen, können Sie wahrscheinlich mit einer geringeren Bittiefe, Chroma-Subsampling und Makro-Blocking auskommen, die bei Capture-Codecs geringerer Qualität auftreten.

Bearbeitungshardware

Der letzte Faktor, den Sie berücksichtigen müssen, ist Ihr Bearbeitungsrechner. Die meisten Capture-Codecs sind für die Bearbeitung ohne einen leistungsstarken Computer nicht gut geeignet. H.264 und einige Rohdateien erfordern eine leistungsstarke CPU/GPU, um reibungslos bearbeitet werden zu können. Und Codecs mit sehr hohen Bitraten erfordern unter Umständen Hochgeschwindigkeitsfestplatten oder Datenserver. Wenn Sie nicht mit einem bearbeitungsfreundlichen Codec aufnehmen, müssen Sie Ihre Dateien vor der Bearbeitung möglicherweise in einen anderen Codec umwandeln. Und das kann Zeit kosten. Für manche ist das Transkodieren des Materials kein großes Problem, da es über Nacht oder auf einem Ersatzcomputer erledigt werden kann. Wenn Sie jedoch unter Zeitdruck arbeiten, sollten Sie sich für einen Codec entscheiden, der es Ihnen ermöglicht, sofort nach dem Dreh mit der Bearbeitung zu beginnen, auch wenn dies mit höheren Kosten oder Abstrichen bei der Bildqualität verbunden ist. Im nächsten Abschnitt erkläre ich, welche Codecs sich am besten für die Bearbeitung eignen.

Der Codec, mit dem Sie bearbeiten

(zurück zum Index)

Also, Sie haben Ihren Film gedreht und alle Dateien auf Ihren Computer geladen. Jetzt müssen Sie entscheiden, ob Sie diese Dateien bearbeiten wollen. Oder ob Sie sie in ein anderes Format transkodieren wollen.

Warum sollte ich vor der Bearbeitung transkodieren? Kann ich nicht einfach die Dateien bearbeiten, die aus der Kamera kommen?

Nun, das kommt darauf an. So gut wie alle großen Softwarepakete können jetzt jeden Codec bearbeiten, den Ihre Kamera erzeugt. (Es sei denn, Sie sind ein echter Profi, der mit einer brandneuen Kamera mit brandneuer Technologie fotografiert). Aber obwohl es fast immer möglich ist, die Codecs zu bearbeiten, die Ihre Kamera aufgenommen hat, ist es nicht immer die beste Idee.

Wenn Sie das Glück haben, mit einem Codec aufzunehmen, der sich hervorragend für die Bearbeitung eignet, können Sie diesen Schritt überspringen.

Für viele von uns wird der Aufnahmecodec jedoch nicht für die Bearbeitung optimiert sein. Es gibt zwei Hauptfaktoren, die Sie bei der Wahl Ihres Bearbeitungscodecs berücksichtigen müssen: Kompressionstyp und Bitrate.

Hochkomprimierte Codecs können Ihre Bearbeitung verlangsamen

(zurück zum Index)

Die meisten Kameras der unteren bis mittleren Preisklasse zeichnen mit Codecs auf, die temporale Kompression verwenden, auch bekannt als Long-GOP-Kompression. Ich gebe Ihnen hier eine einfache Erklärung, aber wenn Sie sich für mehr Details interessieren, sehen Sie sich mein Codec-Video an, das bei 19:00 beginnt.

Die einfache Erklärung einer Long-GOP ist, dass der Codec für jedes Bild nur das erfasst, was sich zwischen diesem und dem vorherigen Bild geändert hat. Wenn das Video nicht viele Bewegungen enthält, kann die neue Datei sehr viel kleiner sein. Der Unterschied zwischen diesem Bild und dem letzten Bild beträgt nur ein paar Pixel. Sie brauchen also nur ein paar Pixel zu speichern. Das ist großartig!

Immer vorwärts

Das Problem ist jedoch, dass diese Codecs in der Regel nur bei der Vorwärtswiedergabe gut funktionieren. (Wenn Sie wissen wollen, warum, sehen Sie sich das Video an). Das ist toll für die Wiedergabe auf YouTube und Ihrem DVD-Player, aber nicht für die Bearbeitung. Bei der Bearbeitung springt man oft herum oder spielt einen Clip rückwärts ab. Und es braucht viel mehr Rechenleistung, um diese Dinge mit einem Long-GOP-Codec schnell zu erledigen. Ein High-End-Computer hat vielleicht keine Probleme, aber selbst ein Mittelklasse-Computer wird verzögert und stottert, wenn Sie das Material schnell überfliegen oder herumspringen.

Codecs, die nicht Long-GOP sind (auch bekannt als Intra-Frame-Codecs), können genauso leicht rückwärts wie vorwärts abgespielt werden. Selbst ein Mittelklasserechner kann also sehr flüssig umherhüpfen. Wenn Sie bisher nur Clips direkt von der Kamera aus bearbeitet haben, werden Sie vielleicht gar nicht merken, was Ihnen entgeht!

Eine andere Sache, die Probleme bei der Wiedergabe verursachen kann, ist Rohvideo. Rohes Video muss konvertiert werden, bevor es angezeigt werden kann (ähnlich wie ein Codec). Und manche Computer können die Rohdatei nicht schnell genug dekodieren, insbesondere wenn es sich um 4K handelt. Ironischerweise produzieren sowohl die Low-End-Kameras als auch die High-End-Kameras Dateien, die schwer zu bearbeiten sind!

High-Bitrate Codecs können Ihre Bearbeitung verlangsamen

(zurück zum Index)

Für niedrige bis mittlere Codecs müssen Sie sich überhaupt keine Gedanken über die Bitraten machen. Sobald Sie sich jedoch nach oben bewegen, können Codecs mit hohen Bitraten zu Problemen bei der Bearbeitung führen, besonders wenn Sie auf normalen Computern arbeiten.

Der Grund dafür ist, dass Ihr Computer in der Lage sein muss, die Daten von Ihrer Festplatte mit einer Bitrate zu lesen, die mindestens so hoch ist wie die Bitrate Ihres Codecs. Das macht Sinn – wenn Ihr Codec 50Mb/s (fünfzig Megabit pro Sekunde) ist, dann muss Ihr Computer in der Lage sein, diese Datei mit 50Mb/s von Ihrer Festplatte zu lesen, sonst gerät er ins Hintertreffen und stottert.

(beachten Sie, dass Mb/s für Megabit pro Sekunde steht, während MB/s für Megabyte pro Sekunde steht. Da ein Byte aus acht Bits besteht, muss man bei der Umrechnung von MB/s in Mb/s mit 8 multiplizieren.

Eine gute Nachricht

Die gute Nachricht ist, dass die Festplatten jeden Tag schneller werden. 50Mb/s werden also keine Probleme verursachen. Aber was ist, wenn Sie ProRes 422HQ bei 4K bearbeiten, was 734Mb/s entspricht? Die durchschnittliche externe Festplatte ist nur knapp schnell genug, um das wiederzugeben. Einige billigere Festplatten schaffen das gar nicht. Und was ist, wenn Sie eine Multikamera mit drei Kameras bearbeiten? Plötzlich brauchen Sie die dreifache Datenrate: 2.202 Mb/s! An diesem Punkt müssen Sie in einige Hochleistungsfestplatten oder RAIDs investieren.

Hier sind einige grobe Richtlinien für übliche Datenspeicherungsgeschwindigkeiten. (Es wird immer bestimmte Modelle geben, die unter- oder überdurchschnittlich schnell sind.)

- Standard-Spinning-Laufwerk: 100-120MB/s

- Professionelles Spinning-Laufwerk: 150-200MB/s

- Standard-SSD: 400-500 MB/s

- Low-End-RAID: 200-300 MB/s

- High-End-RAID: 1000-2000 MB/s

Die Aufnahme im Protokoll kann die Bearbeitung verlangsamen

Die Aufnahme im Protokoll ist eine Möglichkeit, einen möglichst großen Teil des Dynamikbereichs zu erhalten. So kann eine Szene mit hellen Lichtern und dunklen Schatten aufgenommen werden, ohne dass die Lichter überstrahlt werden oder die Schwarztöne unterdrückt werden. Überstrahlte Lichter sind ein besonders unangenehmer Nebeneffekt, wenn man auf Video statt auf Film aufnimmt. Die Aufnahme im Logbuch kann also dazu beitragen, dass Ihre Aufnahmen filmischer wirken. Jetzt, wo Log-Profile auch für die meisten Prosumer-Kameras verfügbar sind, ist diese Arbeitsweise sehr beliebt.

Der Nachteil

Der Nachteil ist, dass das Bild, das aus der Kamera kommt, nicht so toll aussieht. Sie müssen den Kontrast und die Sättigung erhöhen, um dem endgültigen Bild auch nur nahe zu kommen. Die gängigste Methode, dies zu tun, ist das Hinzufügen einer LUT zu Ihrem Filmmaterial. Dabei handelt es sich im Wesentlichen um eine einfache voreingestellte Farbkorrektur, die Ihrem Material ein „normales“ Aussehen verleiht.

Wenn Sie in einem Log-Farbraum aufnehmen, müssen Sie eine LUT auf Ihr Material anwenden, um es in der Vorschau mit normaler Farbe und normalem Kontrast anzuzeigen. Das bedeutet, dass Ihr Cutter bei der Bearbeitung die entsprechende LUT auf alle Clips anwenden muss. Das kann lästig sein und auch den Computer ein wenig verlangsamen. Das liegt daran, dass er jedes Bild erst dekodieren und dann die LUT anwenden muss, bevor er es anzeigt. Es ist zwar möglich, das Log-Filmmaterial ohne LUT zu bearbeiten, aber es ist nicht ideal. Die Farbe zweier Aufnahmen kann die Art und Weise beeinflussen, wie sie zusammengeschnitten werden.

Wenn Sie Ihre Dateien vor der Bearbeitung transkodieren, können Sie die LUT während des Transkodierungsprozesses anwenden. Auf diese Weise arbeitet der Cutter immer mit Material, das einen guten Kontrast und gute Farben aufweist, und muss sich nicht mit LUTs herumschlagen. Beachten Sie, dass Sie dies nur tun sollten, wenn Sie einen Proxy-Workflow und keinen Direct-Intermediate-Workflow (siehe unten) verwenden.

Berücksichtigen Sie den Zeitaufwand für die Codierung

Der größte Nachteil der Transcodierung Ihres Materials vor der Bearbeitung ist einfach die Zeit, die für die Transcodierung benötigt wird. Wenn Sie viel Filmmaterial zu bearbeiten haben und Ihr Computer nicht schnell ist, kann das sehr lange dauern. Wenn Sie es nicht so eilig haben, können Sie die Transkodierung über Nacht laufen lassen, möglicherweise auf mehreren Computern, wenn Sie Zugang zu ihnen haben, aber das ist nicht immer ideal.

Als ich bei der Khan Academy arbeitete, nahm unser Gründer regelmäßig kurze Videobotschaften auf, die er an Leute verschickte. Diese hatten oft einen sehr engen Zeitplan. Normalerweise nahm ich in 4K im Long-GOP-Log-Format auf und bearbeitete sie auf einem MacBook Pro. Wenn ich 4K-Long-GOP mit einer LUT (zur Korrektur des Log-Materials) auf einem Laptop bearbeitete, konnte ich das Video in Premiere Pro problemlos abspielen, aber ich konnte nicht so schnell in der Zeitleiste zoomen, wie ich wollte, ohne zu stottern.

Das hat mich aber nicht allzu sehr gestört, weil der Schnitt extrem einfach war. Nur ein paar Schnitte, vielleicht etwas Musik, ein Titel, und ich war fertig. Auch wenn meine Schnittgeschwindigkeit nicht ideal war, hätte ich mehr Zeit mit der Transkodierung verbracht, als ich an Schnittgeschwindigkeit gespart hätte, also habe ich einfach die Originaldateien verwendet.

Wenn ich jedoch ein längeres Stück mit demselben Aufbau bearbeiten würde, würde ich in DNxHD oder ProRes transkodieren. Im Allgemeinen würde ich die Transkodierung über Nacht durchführen, oft mit mehreren gleichzeitig laufenden Rechnern.

Proxy Edit

(zurück zum Index)

Wenn Sie die nativen Kameradateien vor der Bearbeitung transkodieren, verwenden Sie einen „Zwischencodec“. Er wird als Zwischencodec bezeichnet, weil er zwischen dem Aufnahmecodec und dem Exportcodec steht. Es gibt zwei gängige Möglichkeiten, mit Zwischencodecs zu arbeiten:

Die erste ist der „Proxy“-Workflow oder „Offline-Edit“. Das bedeutet, dass Sie Ihr aufgenommenes Material in ein Zwischenformat transkodieren, mit diesem Format bearbeiten und dann vor dem Exportieren wieder mit den ursprünglichen Kameradateien verknüpfen. Da Sie zum Exportieren die Kameradateien und nicht die Proxydateien verwenden, müssen Sie sich nicht so viele Gedanken über die Auswahl eines Proxy-Codecs mit hoher Bildqualität machen – verlustbehaftete Codecs sind in Ordnung. Sie können stattdessen die Bearbeitungsgeschwindigkeit und den Speicherplatz optimieren.

Der Proxy-Workflow ist so verbreitet, dass viele High-End-Kameras gleichzeitig eine High-End-Rohdatei *und* eine ProRes- oder DNxHD-Proxydatei aufzeichnen. Nach den Dreharbeiten werden die Rohdateien gesichert und gespeichert. Die Proxy-Dateien werden an die Editoren und den Regisseur/Produzenten für die Dailies geschickt.

Vermeiden Sie die temporale Kompression

Wenn Sie einen Proxy-Codec auswählen, sollten Sie sich für einen Codec entscheiden, der keine temporale Kompression (auch bekannt als Inter-Frame-Kompression oder Long-GOP-Kompression) verwendet, und Sie sollten einen Codec mit einer niedrigen Bitrate wählen. Die niedrige Bitrate bedeutet, dass die Dateien viel kleiner sind, so dass Sie weniger/kleinere/günstigere Festplatten verwenden können, was Ihren Arbeitsablauf vereinfacht.

Die Proxydateien eignen sich zwar hervorragend für die Bearbeitung, aber mehr als eine grundlegende Farbkorrektur sollten Sie mit Proxydateien nicht vornehmen. Wenn Sie die gesamte Farbkorrektur in Ihrer Bearbeitungssoftware vornehmen wollen, sollten Sie sich wieder mit den Kameradateien verbinden, da die Proxydateien eine geringere Farbqualität aufweisen können.

Die gute Nachricht ist, dass die meisten Bearbeitungssoftware heutzutage mit nur wenigen Klicks zwischen den Kameradateien und den Proxydateien wechseln können, so dass Sie bei Bedarf sogar hin und her wechseln können.

Wir haben detaillierte Anleitungen für Proxy-Workflows in allen wichtigen NLEs veröffentlicht:

- Final Cut Pro X Proxy-Workflows

- Premiere Pro Pro Proxy-Workflows

- Avid Media Composer Proxy-Workflows

Einige gute Entscheidungen für Proxy-Codecs

Die bei weitem häufigsten Proxy-Codecs sind DNxHD/DNxHR und ProRes. Beide sind schon seit Jahren auf dem Markt und werden daher sehr gut unterstützt. Jeder weiß, wie man mit ihnen umgeht. Beide eignen sich sehr gut für einen Proxy-Workflow (ProRes hat sogar eine Voreinstellung namens „Proxy“) und sind nahezu austauschbar, wenn sie für Proxys verwendet werden.

DNxHD wird von Avid hergestellt, und ProRes von Apple. Es macht also Sinn, dass DNxHD besser auf Media Composer und ProRes besser auf Final Cut Pro X funktioniert. Das war früher sicherlich so, aber heutzutage funktionieren beide Codecs auf allen modernen Editoren (einschließlich Premiere Pro) sehr reibungslos. Es kann einen leichten Geschwindigkeitszuwachs geben, wenn man den Codec verwendet, der für das System entwickelt wurde, aber das ist nur sehr geringfügig.

Der einzige signifikante Unterschied zwischen den beiden für einen Proxy-Workflow ist die Tatsache, dass Sie möglicherweise Schwierigkeiten haben, ProRes auf einem PC zu erstellen, während DNxHD sehr einfach plattformübergreifend zu erstellen ist. Die einzige offiziell unterstützte Methode zur Erstellung von ProRes auf einem PC ist Assimilate Scratch. Es gibt einige andere, nicht unterstützte Methoden zur Erstellung von ProRes-Dateien auf einem PC, die jedoch nicht immer zuverlässig sind. PCs können ProRes-Dateien problemlos abspielen und bearbeiten, aber Sie können neue ProRes-Dateien auf einem PC nicht so einfach kodieren wie DNxHD. Aus diesem Grund bevorzugen einige Cutter einen DNxHD-Workflow.

Wählen Sie eine Spur

Unabhängig davon, für welchen der beiden Codecs Sie sich entscheiden, müssen Sie auch die gewünschte Geschmacksrichtung wählen. Dies hängt vor allem von Ihren Speicherplatzbeschränkungen ab – es ist ein Kompromiss zwischen Bildqualität und Dateigröße. Die gute Nachricht ist, dass Sie bei der Bearbeitung keine optimale Bildqualität benötigen, so dass Sie einen Codec mit niedriger Bitrate wählen können.

Beginnen Sie mit dem kleinsten ProRes- oder DNx-Codec in der gleichen Auflösung wie Ihr Aufnahmecodec. Schauen Sie sich die GB/hr-Spalte an und multiplizieren Sie sie mit der Anzahl der Stunden an Filmmaterial, die Sie haben. Wenn Sie genügend Speicherplatz haben, können Sie diesen Codec verwenden. Wenn Sie viel zusätzlichen Speicherplatz haben, sollten Sie die nächstgrößere Variante verwenden.

Wenn Sie jedoch nicht genügend Speicherplatz haben oder einen Computer mit geringerer Leistung verwenden, sollten Sie die Auflösung ein wenig reduzieren. Viele Hollywood-Filme mit großem Budget wurden noch vor ein paar Jahren in 480p bearbeitet, also keine Panik, wenn Sie die Auflösung von 4K auf 720P reduzieren müssen.

Direktes Intermediate

Die andere Art von Intermediate-Workflow ist etwas, das ich Direct Intermediate nenne. Das bedeutet, dass Sie Ihre Kameradateien in einen Codec umwandeln, der sowohl für die Bearbeitung geeignet ist als auch eine sehr hohe Qualität aufweist (nicht sehr verlustbehaftet). Da der Codec sehr hochwertig ist, bleiben fast alle Originalinformationen aus den Kameradateien erhalten, so dass eine Rückverlinkung zu den Kameradateien nicht erforderlich ist – Sie können einfach direkt aus den Zwischendateien exportieren. Beim Transkodieren gehen zwar theoretisch einige Informationen verloren, aber wenn Sie einen ausreichend guten Zwischencodec wählen, ist der Verlust so gering, dass Sie sich darüber keine Gedanken machen müssen.

(Anmerkung: Ich nenne diesen Prozess „Direct Intermediate“, weil es keine allgemeine Bezeichnung für diesen Workflow gibt. Gewöhnlich nennt man ihn einfach „Intermediate“, aber das kann verwirrend sein, weil Proxy-Workflows auch eine Art von Intermediate-Workflow sind. Manche Leute bezeichnen dies auch als „Online“-Workflow, aber das ist auch verwirrend, weil dieser Begriff geschaffen wurde, um einen Workflow zu beschreiben, der eine Offline- und eine Online-Bearbeitung umfasst, und nicht einen Workflow, der von Anfang bis Ende online ist.)

Erhaltung ist der Schlüssel

Der Schlüssel zur Auswahl eines guten Direct-Intermediate-Codecs ist es, sicherzustellen, dass Sie alle Informationen von Ihrem Aufnahme-Codec erhalten. Ein Zwischencodec macht Ihre Bilder nicht besser (genauere Erklärung weiter unten), aber er kann sie definitiv schlechter machen, wenn Sie den falschen Codec wählen. Wichtig ist, dass Sie die Details Ihres Originalmaterials verstehen und sicherstellen, dass Ihr Zwischencodec in jedem Bereich mindestens so gut ist wie Ihr Aufnahmecodec. Wenn Sie Ihr Material mit einer DSLR wie einer Sony A7Sii in 4K aufnehmen, dann werden Sie in einem 4:2:0, 8-Bit, Long-GOP-Codec mit 100 Mbps aufnehmen. Sie benötigen einen Zwischencodec, der mindestens 4:2:0 und 8-Bit ist. Eine Überschreitung dieser Werte (z. B. 4:4:4 und 12-Bit) schadet nicht, hilft aber auch nicht weiter. Daher lohnt sich der zusätzliche Speicherplatz wahrscheinlich nicht.

Angenommen, wir möchten einen ProRes-Codec verwenden. Wir haben 4 Optionen zur Auswahl, die 4:2:2 und 10-Bit sind.

- 145Mb/s ProRes 422 Proxy

- 328Mb/s ProRes 422 LT

- 471Mb/s ProRes 422

- 707Mb/s ProRes 422 HQ

Über und darüber

Man könnte meinen, dass Sie nur die Bitrate der Kamera (100Mbps) erreichen müssen, aber in Wirklichkeit müssen Sie die Kamerabitrate weit übertreffen. Das liegt daran, dass h.264 ein viel effizienterer Codec als ProRes ist. Da h.264 die Long-GOP-Komprimierung verwendet, kann es viel mehr Informationen in diese 100 Megabits packen als ProRes. Damit ProRes mit der Bildqualität von h.264 mithalten kann, benötigen Sie eine viel höhere Bitrate. Ich würde empfehlen, nur ProRes 422 oder ProRes 422 HQ zu verwenden, wenn Sie mit einem h.264-Codec mit 100 MBit/s beginnen. ProRes 422 wird wahrscheinlich ausreichen, aber wenn Sie viel Speicherplatz haben, ist ProRes 422 HQ leicht im Vorteil.

Es ist zwar in Ordnung, die Bittiefe und Farbabtastung bei der Auswahl eines Zwischenprodukts einfach anzupassen, aber Sie sollten die Bitrate immer zumindest ein wenig erhöhen. Wenn Sie von einem Long-GOP-Codec zu einem Non-Long-GOP-Codec wechseln, sollten Sie die Bitrate deutlich erhöhen.

Nebenbei: Wenn Sie DNxHD anstelle von ProRes verwenden möchten, haben Sie ähnliche Möglichkeiten, außer dass DNxHD auch eine 8-Bit-Version für die Low-End-Codecs bietet. Da unser Filmmaterial von vornherein 8-Bit ist, wird uns das nicht schaden.

Der Proxy-Workflow hörte sich ziemlich gut an. Warum Direct Intermediate?

Der Direct Intermediate-Workflow ist unter anderem deshalb so verbreitet, weil es früher viel schwieriger war, einen Proxy-Workflow zu verwenden. Einige der großen Software-Anbieter machten es nicht gerade einfach, auf die Original-Kameradateien zurückzugreifen, und so entschied man sich für einen direkten Intermediate-Workflow. Heutzutage ist dies jedoch in jedem Bearbeitungspaket recht einfach möglich. Die wichtigste Ausnahme ist, wenn Sie viel gemischtes Filmmaterial haben. Wenn Sie mehrere Frameraten und Framegrößen in einem Projekt haben, kann das Hin- und Herwechseln zwischen den Proxys und den Capture-Codecs Kopfzerbrechen bereiten.

Wenn Sie einige Tools von Drittanbietern verwenden, um Ihr Material vor dem Schnitt vorzubereiten und zu organisieren, können diese den Prozess der Neuverknüpfung ebenfalls erschweren. Ein gängiges Beispiel ist Software, die automatisch Audiospuren oder Multicam-Aufnahmen synchronisiert.

Kein Austausch erforderlich

Ein weiterer Grund, warum Sie einen Direct-Intermediate-Workflow verwenden sollten, ist, dass Sie direkt zur Farbkorrektur und zum VFX-Prozess („Finishing“) übergehen können, ohne Dateien austauschen zu müssen. Lesen Sie weiter, dann erkläre ich Ihnen in den Abschnitten Farbkorrektur und VFX, warum das praktisch ist.

Ein Nachteil ist jedoch, dass Sie die LUTs für Ihren Editor nicht „einbacken“ können – Sie müssen eine LUT über einen Farbkorrektureffekt in Ihrer Schnittsoftware anwenden. Wenn Sie die LUT in Ihren Transkodierungs-Workflow für Direct Intermediate einbeziehen würden, würden Sie alle Vorteile der Aufzeichnung im Protokoll verlieren.

Der andere offensichtliche Nachteil ist, dass Sie alle diese (viel größeren) Dateien speichern müssen.

Ein dazwischengeschalteter Codec wird Ihre Bilder niemals besser machen

(zurück zum Index)

Dies ist sehr wichtig, weil es sehr häufig missverstanden wird und es eine Menge Fehlinformationen im Internet gibt. Die Transkodierung von Filmmaterial vor der Bearbeitung wird die Qualität der Ausgabe nicht verbessern. Es gibt einige zusätzliche Operationen, die Sie im Transkodierungsprozess durchführen können (z. B. die Verwendung ausgeklügelter Up-Res-Tools), die die Bildqualität in einigen Fällen verbessern können, aber ein neuer Codec allein wird die Qualität Ihres Bildes niemals verbessern.

Wenn Sie den richtigen Codec wählen, können Sie vermeiden, dass Ihr Bild Schaden nimmt, aber Sie können es niemals verbessern.

Das gilt auch für den Wechsel von h.264 zu DNxHD oder ProRes. Dazu gehört auch der Wechsel von 8-Bit zu 10-Bit. Und der Wechsel von 4:2:0 zu 4:4:4.

Hier ist eine Illustration, die Ihnen helfen kann, dieses Konzept zu verstehen:

Dies ist ein Foto einer Rose, die sich in einem Wassertropfen spiegelt. Es hat 4 Megapixel und sieht auf meinem 27-Zoll-Monitor ziemlich gut aus.

Nun, was ist, wenn ich meinen Monitor mit einer Red Helium 8k-Kamera fotografiere. Das ist ein Biest von einer Kamera. Das Foto der Rose habe ich vor ein paar Jahren mit einer billigen Canon Rebel DSLR aufgenommen, die heute etwa 250 Dollar wert ist. Die Red Helium kostet etwa 50.000 Dollar, hat 35 Megapixel, ist unbearbeitet und hat einen der besten Kamerasensoren, die je hergestellt wurden.

Welches Bild ist besser – das 4-Megapixel-Foto oder das 35-Megapixel-Foto?

Eine Aufnahme einer Aufnahme

Die Red-Kamera hat mehr Megapixel, oder? Sie ist roh und hat die ganze digitale Magie von Red, richtig? Aber da ich meine hochauflösende Kamera verwende, um ein Foto des Fotos zu machen und nicht ein Foto der Rose, wird mein neues Bild niemals besser sein als das erste. Ich habe eine Datei, die technisch gesehen eine höhere Auflösung hat, aber sie fängt nicht mehr von meinem Motiv (der Rose) ein als das erste Bild.

Das ist es, was Sie tun, wenn Sie transkodieren. Du machst eine Kopie einer Kopie, ein Foto von einem Foto. Wenn Sie eine hochauflösende Kamera verwenden, um ein Foto von einem Foto zu machen, können Sie so ziemlich alle Informationen des Originalbildes erhalten, aber Sie können nichts mehr hinzufügen.

Die große Einschränkung ist, dass Sie, wenn Sie das Bild bearbeiten oder umwandeln (z. B. eine LUT hinzufügen), auf jeden Fall in einen höherwertigen Codec transkodieren sollten, der neue Informationen beibehält. Aber wenn Sie das Bild nicht verändern, wird Ihr Bild durch die Transkodierung nicht irgendwie „besser“.

Ein Beispiel aus der Praxis

(zurück zum Index)

Angenommen, Sie bearbeiten einen Dokumentarfilm, der mit einer Sony A7sii-Kamera in 4K aufgenommen wurde, die in der Long-GOP-Version von XAVC-S aufzeichnet. Nicht ideal für den Schnitt. Wenn 40 Stunden Filmmaterial für Ihren abendfüllenden Dokumentarfilm aufgenommen wurden, haben Sie am Ende etwa 2,7 TB an Kameradateien, die problemlos auf eine Festplatte passen (auch wenn Sie natürlich andere, separate Sicherungen gemacht haben!).

Diese Dateien könnten Sie in einen hochwertigen, verlustarmen Codec für einen Direct Intermediate-Workflow konvertieren, vielleicht ProRes 422 HQ in 4K.

Der Nachteil ist, dass Sie etwa 12,7 TB benötigen würden, um all diese ProRes-Dateien zu speichern. Sie müssten ein teures RAID-Setup verwenden, um einfachen Zugriff auf das gesamte Filmmaterial in einem Projekt zu haben, mindestens 1.000 $. Peanuts für ein großes Unternehmen, aber eine beträchtliche Investition für einen einzelnen Cutter.

Proxy wählen

So könnten Sie sich stattdessen für einen Proxy-Workflow entscheiden und Ihre Dateien in das ProRes 422 Proxy 4K-Format transkodieren. Dann würde Ihr Filmmaterial nur 2,8 TB beanspruchen, also kaum mehr als das aufgenommene Filmmaterial. Sie können dann problemlos von einer einzigen Festplatte aus bearbeiten, und Ihr Workflow wird wesentlich einfacher. (Eine Anleitung zur Berechnung von Bitraten und Dateigrößen finden Sie in diesem Artikel: Die einfache Formel zur Berechnung von Videobitraten).

Angenommen, Sie arbeiten mit einem anderen Cutter zusammen, der sich auf der anderen Seite des Landes befindet. Sie könnten beschließen, das Material noch weiter in ProRes 422 Proxy HD zu transkodieren, wodurch Ihr Material auf nur 640 GB schrumpfen würde, was sich bei einer schnellen Verbindung besser über das Internet versenden lässt. (18 Stunden Downloadzeit bei einer 80-Mbps-Verbindung)

Nach der Bearbeitung verknüpfen Sie Ihr Projekt einfach wieder mit den ursprünglichen Kameradateien und exportieren es. Auch wenn Sie und Ihr Remote-Editor mit einem ziemlich verlustbehafteten Codec gearbeitet haben, wird dieser beim endgültigen Export umgangen, so dass Sie keine Qualitätseinbußen erleiden.

Der Codec, mit dem Sie die Farbkorrektur durchführen

(zurück zum Index)

Ok, jetzt haben Sie Ihr Video bearbeitet, und es ist Zeit für die Farbkorrektur. Alles, was wir hier besprechen, gilt unabhängig davon, ob Sie die Farbkorrektur in Ihrer Bearbeitungsanwendung vornehmen oder ob Sie Ihr bearbeitetes Video an eine spezielle Farbkorrektursoftware senden.

Die wichtigste Frage an dieser Stelle ist, ob Sie die Farbkorrektur direkt an den Original-Kameradateien vornehmen oder ob Sie eine Transkodierung vornehmen wollen. Wenn Sie eine Proxy-/Offline-Bearbeitung durchgeführt haben, sollten Sie die Proxy-Dateien auf keinen Fall farbkorrigieren, da sie eine geringere Bildqualität aufweisen. Um gute Farbentscheidungen treffen zu können, brauchen Sie die beste Bildqualität, die Ihnen zur Verfügung steht, denn Sie müssen genau sehen können, womit Sie arbeiten müssen.

Wir müssen also mit qualitativ hochwertigen Bildern arbeiten, und wir haben einige verschiedene Möglichkeiten:

A. Die Kameradateien bewerten

Dies ist sicherlich eine einfache Möglichkeit. Wenn Sie eine Proxy-Bearbeitung durchgeführt haben, können Sie für die Nachbearbeitung auf die Kameradateien zurückgreifen und sich austoben. Dadurch erhalten Sie eine maximale Bildqualität, aber erinnern Sie sich daran, dass die Kameradateien bei der Bearbeitung langsam sein können? Die Kameradateien können den Prozess ein wenig verlangsamen, aber je nach der von Ihnen verwendeten Software und dem Umfang der Arbeit, die Sie erledigen müssen, könnten Sie entscheiden, dass die Einfachheit eine kleine mögliche Verlangsamung wert ist. Wenn Sie einen kurzen Schnitt ohne viel Komplexität haben, kann dies ein großartiger und einfacher Arbeitsablauf sein.

Angenommen, die Verlangsamung der Farbkorrektur stört Sie, so dass Sie einen Codec benötigen, der einfacher zu handhaben ist. Sie könnten Ihr gesamtes Filmmaterial in einen Codec mit hoher Bildqualität transkodieren, eine Verbindung zu diesen Dateien herstellen und dann mit der Farbkorrektur beginnen. Aber… das macht den Zweck eines Proxy-Workflows zunichte, nicht wahr? Wir haben Proxys verwendet, weil wir uns nicht mit den großen Dateien herumschlagen wollten, die dabei entstehen würden. Zum Glück gibt es noch eine andere Möglichkeit.

B. Konsolidieren und transkodieren

(zurück zum Index)

Wenn Sie einen Proxy/Offline-Workflow für den Schnitt verwendet haben, aber die Kameradateien nicht farbkorrigieren möchten, besteht eine gute Möglichkeit darin, die Kameradateien erneut zu verknüpfen, Ihr Projekt zu konsolidieren und dann in einen High-End-Codec zu transkodieren.

Wenn Sie ein Projekt konsolidieren, erstellt Ihre Bearbeitungssoftware eine Kopie Ihres Projekts zusammen mit einer Kopie der Medien, aber nur die Dateien, die Sie in Ihrer Sequenz verwendet haben. Wenn Sie also 7 Takes aufgenommen haben, aber nur einen davon für die Bearbeitung verwenden, wird nur dieser eine Take kopiert. Das spart eine Menge Speicherplatz, was in diesem Stadium sehr praktisch ist. Sie können auch noch weiter konsolidieren, so dass Sie nur die Teile der einzelnen Takes behalten, die Sie tatsächlich im Schnitt verwendet haben, und den Rest verwerfen. In diesem Fall fügt die Software in der Regel einige Sekunden vor und nach jedem Take hinzu (so genannte „Handles“), falls Sie eine Überblendung oder eine Bewegungsverfolgung hinzufügen möchten.

Beginnen Sie mit dem Grading

Nun können Sie dieses neue konsolidierte Projekt (nach der erneuten Verknüpfung mit den Originalen) nehmen und alle diese Dateien in einen sehr hochwertigen Codec mit hoher Bitrate transkodieren und die Farbkorrektur vornehmen. Der Unterschied zum Direct Intermediate-Workflow besteht darin, dass nicht das gesamte Material transkodiert wird, sondern nur das Material, das es in den endgültigen Schnitt geschafft hat und das vielleicht nur ein Zwanzigstel oder ein Fünfzigstel der Länge des ursprünglich aufgenommenen Materials hat. Jetzt klingt es gar nicht mehr so schlecht, in einen Codec mit hoher Bitrate zu transkodieren, weil man nicht so viel davon speichern muss. Selbst bei ProRes 4444 4K ist ein Spielfilm in voller Länge nur etwa 2 TB groß – ziemlich überschaubar.

Jetzt können Sie Ihren Film mit hochwertigen Bildern und schneller Verarbeitung auf einer Festplatte fertigstellen, die in Ihre Tasche passt. Hurra!

C. Direct Intermediate

Die dritte Möglichkeit ist die Bearbeitung mit Direct Intermediate, dann sind Sie startklar. Sie haben alle Ihre Dateien bereits in einen hochwertigen Codec umgewandelt, bevor Sie mit der Bearbeitung begonnen haben, so dass Sie diese Dateien für die Farbkorrektur einfach weiter verwenden können. Das ist auch praktisch, denn diese Dateien eignen sich sowohl für den Schnitt als auch für die Farbkorrektur und VFX (siehe unten).

Wenn Sie das Projekt an einen externen Koloristen oder VFX-Spezialisten übergeben, können Sie ihm entweder Ihr gesamtes hochwertiges Filmmaterial übergeben (was aufgrund des Umfangs möglicherweise lästig ist), oder Sie können denselben Konsolidierungstipp anwenden, den wir oben verwendet haben. Wenn Sie das konsolidierte Projekt weitergeben, können Sie schneller vorankommen und auch die Zeit Ihres Koloristen einsparen.

Ein weiterer Vorteil

Zusätzlich zur Einfachheit des Direct-Intermediate-Workflows (Sie verwenden nur einen Satz Dateien) haben Sie einen weiteren Vorteil: Das Hin- und Herwechseln zwischen Bearbeitung und Farbkorrektur ist einfacher.

Stellen Sie sich vor, Sie haben Ihre Proxy-Bearbeitung abgeschlossen – Sie konsolidieren und transkodieren, senden sie an Ihren Coloristen und entscheiden dann, dass Sie einige Änderungen an der Bearbeitung vornehmen müssen. Nun müssen Sie zu den Proxys zurückkehren, um die Änderungen vorzunehmen, und dann das Material erneut konsolidieren und versenden. Das kann ziemlich unübersichtlich werden. In einem High-End-Postproduktions-Workflow gibt es in der Regel eine „Sperre“ für den Schnitt, damit die Nachbearbeitung beginnen kann. Das bedeutet, dass Sie (sofern nichts Schlimmes passiert) versuchen werden, nicht zurückzugehen und Änderungen am Schnitt vorzunehmen. Aber hey, schlimme Dinge passieren, also ist es am besten, darauf vorbereitet zu sein.

Und nun finden wir einen weiteren guten Grund für einen direkten Zwischenschnitt. Wenn Sie einen Teil Ihrer Farb- und Schnittarbeiten gleichzeitig durchführen oder zumindest ein paar Mal hin- und hergehen, kann es einfacher sein, einen Codec für beide zu verwenden. Dies ist besonders praktisch, wenn Sie die Bearbeitung und das Finishing in demselben Softwarepaket (oder einer Reihe von Paketen, z. B. Creative Cloud) durchführen.

Der Codec, den Sie an VFX senden

(zurück zum Index)

Wenn Sie VFX-Arbeiten durchführen, müssen Sie wahrscheinlich Dateien an ein anderes Programm senden (möglicherweise an einen anderen Rechner, für einen anderen Künstler). Wenn Sie alle Ihre VFX-Arbeiten in Ihrem Editor erledigen (was bei einfachen Aufträgen immer häufiger der Fall ist), dann können Sie diesen Abschnitt überspringen. Verwenden Sie einfach denselben Codec, den Sie für die Farbkorrektur verwendet haben.

Die meisten von uns müssen jedoch einen „Round-Trip“-Prozess einrichten, der Clips vom Editor zur VFX-Software und wieder zurück schickt, wenn sie fertig sind. Dies geschieht auf Shot-by-Shot-Basis, d. h. Sie senden nicht die gesamte Sequenz an die VFX-Software, wie es wahrscheinlich bei der Farbkorrektur der Fall war. Die Frage, wann Sie Ihre Aufnahmen an VFX senden, hängt stark vom jeweiligen Arbeitsablauf ab.

Einige Leute senden an VFX, nachdem der Schnitt abgeschlossen und die Farbkorrektur beendet ist, aber Zeitdruck kann Sie dazu zwingen, die Aufnahmen schon vorher zu senden.

Wenn Sie in Premiere Pro schneiden und leichte VFX in After Effects mit Dynamic Link durchführen, können Sie diesen Abschnitt auch überspringen. Dynamic Link erledigt das Roundtripping automatisch für Sie. Wenn Sie viel mit VFX arbeiten, sollten Sie dennoch die Techniken in diesem Abschnitt anwenden, da Dynamic Link bei zu vielen Projekten etwas heikel sein kann. Adobe arbeitet jedoch ständig an diesen Fehlern, und so ist es zum Teil eine Frage des persönlichen Geschmacks.

Ganz oder gar nicht

Im VFX-Prozess neigt man aus zwei Hauptgründen dazu, sehr hochwertige Codecs (mit hoher Bitrate) zu verwenden. Der erste Grund ist einfach, dass VFX-Künstler alle Informationen benötigen, die man ihnen geben kann, um ihre Arbeit gut zu machen. VFX-Künstler gehören zu den wählerischsten Leuten, wenn es um Codecs geht, und das aus gutem Grund. Jeder möchte qualitativ hochwertige Bilder, aber Bildprobleme können für VFX oft ein größeres Problem darstellen als für die Bearbeitung, die Farbkorrektur und den endgültigen Export.

Viele Aufgaben in der VFX-Arbeit erfordern eine sehr detaillierte Analyse des Bildes auf Pixel-Ebene, was die meisten Editoren nie tun müssen. Wenn Sie zum Beispiel eine Greenscreen-Extraktion durchführen, möchten Sie, dass die Kante zwischen Ihrer Figur und dem Greenscreen so sauber wie möglich ist. Wir alle haben schon schreckliche Greenscreen-Aufnahmen gesehen, bei denen die Kanten der Figur abgehackt oder unscharf sind. Diese Probleme entstehen oft aufgrund von Bildkomprimierungsartefakten, die für das bloße Auge unsichtbar sind. 4:2:2- oder 4:2:0-Farbunterabtastung hat zum Beispiel fast keine sichtbaren Auswirkungen auf das Bild. Das menschliche Auge achtet hauptsächlich auf den Kontrast und bemerkt nur selten eine niedrige Farbauflösung, aber der Greenscreen-Extraktionsprozess stützt sich hauptsächlich auf Farbwerte. Wenn der Codec einen großen Teil der Farbwerte durch die Verwendung von 4:2:0-Chroma-Subsampling weggeworfen hat, kann ein guter Farbschlüssel unmöglich sein.

Generationsverlust

Der zweite Grund, warum Sie High-End-Codecs verwenden sollten, ist der Generationsverlust. Im VFX-Prozess müssen Sie Ihre Datei wahrscheinlich mehrmals komprimieren. Sie werden die Datei einmal komprimieren, wenn Sie sie an das Unternehmen senden. Wenn die Datei dann an mehrere Spezialisten weitergegeben werden muss, wird sie möglicherweise zwei- oder dreimal komprimiert, bevor sie zurückgeschickt wird. Wenn eine Datei mehrfach komprimiert wird, spricht man von einem Mehrfach-Generationen-Verlust.

Wenn Sie einen Low-End-Codec verwenden, wird das Bild bei jeder erneuten Komprimierung immer schlechter. Einer der großen Vorteile der wirklich hochwertigen Codecs ist, dass man sie ein paar Mal komprimieren kann, ohne viel Qualität zu verlieren. Es ist zwar immer besser, die mehrfache Komprimierung eines Videos zu vermeiden, aber wenn Sie sehr hochwertige Codecs verwenden, ist das in der Regel kein Problem.

Einige hochwertige VFX-Workflows verwenden aus diesem Grund nur verlustfreie Komprimierung. Die gute Nachricht ist, dass Ihre VFX-Aufnahmen in der Regel nur ein paar Sekunden pro Clip dauern, was bedeutet, dass Ihre Dateigrößen selbst mit High-End-Codecs klein sind. Also machen Sie es groß! Wenn Sie 4:4:4 mit der Kamera aufgenommen haben, dann senden Sie auf jeden Fall 4:4:4 an VFX. Andernfalls würde ich einen 4:2:2-Codec der Spitzenklasse wählen (ProRes 422 HQ oder DNxHQX).

Und natürlich sollten Sie sich vorher immer mit VFX darüber verständigen, welchen Codec Sie senden wollen. Wenn Sie der Meinung sind, dass sie eine schlechte Wahl treffen, schicken Sie ihnen diesen Artikel 🙂

Der Codec, den Sie exportieren

(zurück zum Index)

Nachdem Sie den Schnitt, die Farbe und die VFX fertiggestellt haben, sind Sie bereit für den Export. Normalerweise werden Sie den endgültigen Export aus der Software durchführen, die Sie für die Farbkorrektur verwendet haben, und dabei den Codec benutzen, den Sie bei der Farbkorrektur benutzt haben.

Wenn Ihr Kunde in der Medienbranche tätig ist, sollte er wissen, welchen Codec er will, so dass Sie den Rest dieses Abschnitts überspringen können!

Wenn Ihr Kunde kein Videoexperte ist, weiß er vielleicht nicht, was er will, also müssen Sie einige Entscheidungen für ihn treffen. In den meisten Fällen möchte Ihr Kunde ein Video, das er auf YouTube und/oder andere Websites für soziale Medien hochladen kann. Sie könnten versucht sein, einen Codec zu wählen, der für das Streaming im Internet geeignet ist. Aber das wäre falsch!

Der Grund dafür: Diese Websites streamen nicht dieselbe Datei, die Sie hochladen, an Ihre Zuschauer – sie komprimieren die Datei *noch einmal*, bevor sie gestreamt wird, und Sie haben absolut keine Kontrolle über die Einstellungen, die sie verwenden. Das heißt, wenn Sie einen Codec mit schlechter Qualität hochladen, haben wir das Szenario, dass wir ein Foto mit schlechter Qualität von einem Foto mit schlechter Qualität aufnehmen, über das wir gesprochen haben. Schlecht! Vermeiden!

Bestmögliche Qualität anstreben

Als allgemeine Regel gilt: Wenn Sie die beste Qualität wollen, sollten Sie die beste Quelle hochladen. Sie werden sowieso wieder komprimiert, also kann es nicht schaden, ihnen mehr Daten zur Verfügung zu stellen, oder? Wenn Sie eine ausreichend schnelle Verbindung haben, können Sie eine ProRes 422-Datei hochladen. Einige Leute haben von etwas (nur etwas) besseren Ergebnissen berichtet, wenn sie ProRes anstelle des empfohlenen h.264 hochgeladen haben.

Wenn Sie eine Datei an einen Kunden liefern, damit er sie auf Youtube hochlädt, würde ich ihm kein ProRes geben, da Sie nicht wissen, welche Bandbreite er zur Verfügung hat. Glücklicherweise veröffentlichen diese Websites in der Regel empfohlene Upload-Spezifikationen (googeln Sie einfach danach). Ich persönlich nehme die empfohlene Bitrate und multipliziere sie mit dem 1,5- bis 2-fachen Wert.

Ihr Kunde möchte vielleicht auch eine Datei, die er direkt in seine Website einbetten kann (obwohl ich ihm davon abraten würde, wenn Sie das können). Im Allgemeinen möchten Sie eine sehr stark komprimierte h.264-Datei. Falls Sie sich fragen, was eine gute Bitrate ist: Wenn jemand weiß, was die beste Bitrate ist, dann ist es YouTube. Ich lade regelmäßig ein Video von YouTube herunter und überprüfe die Bitrate.

Kleiner werden

Wenn das Video nicht öffentlich ist, möchten sie vielleicht auch eine kleine Datei, die sie per E-Mail versenden oder direkt mit ihren eigenen Clients verlinken können, damit diese sie herunterladen können. In diesen Fällen kann es sinnvoll sein, mehr als zwei separate Dateien zu liefern, insbesondere wenn es sich um ein langes Video handelt. Die Datei, die auf YouTube hochgeladen werden soll, wird zu groß sein, um sie bequem per E-Mail zu versenden. In diesem Fall verkleinere ich die Datei in der Regel und komprimiere sie sehr stark. Sie müssen auch realistisch sein und entscheiden, ob Sie glauben, dass Ihr Kunde den Unterschied zwischen den beiden Dateien tatsächlich verstehen wird.

Wenn ich mehr als eine Datei liefern muss, nenne ich eine davon normalerweise „HD“ im Dateinamen und die andere „klein“ oder „nicht HD“ im Dateinamen. Wenn Sie versuchen, ihnen die verschiedenen Codecs zu erklären, kann ich fast garantieren, dass sie den Unterschied bis nächste Woche vergessen haben, aber sie werden sich wahrscheinlich daran erinnern, was HD und „nicht HD“ bedeutet.

Der Codec, den Sie archivieren

(zurück zum Index)

Sie haben die Datei(en) an Ihren Kunden geliefert, jetzt können Sie sich zurücklehnen und entspannen… fast.

Wie jeder, der in dieser Branche arbeitet, weiß, ist der Tag, an dem Sie das fertige Produkt an Ihren Kunden liefern, oft nicht das letzte Mal, dass Sie ein Projekt anfassen. Manchmal möchte ein Kunde Wochen später noch etwas ändern, oder er möchte einen höherwertigen Codec, oder vielleicht möchten Sie es zu Ihrer persönlichen Filmrolle hinzufügen. In all diesen Fällen sind Sie vielleicht auf einen anderen Rechner oder eine andere Software umgestiegen, so dass es Ihnen Kopfzerbrechen bereitet, das ursprüngliche Projekt zu öffnen und erneut zu exportieren.

Das ist praktisch

Hier ist es praktisch, ein großes Archiv des fertigen Projekts in einem extrem hochwertigen Codec zu haben. Wenn Ihr Kunde einen sehr hochwertigen Codec für die Auslieferung verlangt hat, dann sind Sie in der Regel gut gerüstet. Bewahren Sie einfach eine Kopie dieser Datei auf, und das war’s. Wenn der Kunde jedoch einen Codec für die Auslieferung benötigt, der nicht so hochwertig ist, sollten Sie Ihren eigenen Export mit einem verlustfreien Codec oder einem Codec, der dem verlustfreien Codec so nahe kommt, wie Sie es sich angesichts des Platzbedarfs leisten können, durchführen. Ich exportiere in der Regel in einen 4:4:4-Codec mit sehr hoher Bitrate – entweder DNxHD/HR oder ProRes.

Sind noch Fragen offen? Comment away.

Ich lese wirklich jeden Kommentar. Dieser Artikel ist in Arbeit, und ich werde ihn mit weiteren Erklärungen und Beispielen basierend auf Ihrem Feedback aktualisieren. Wenn Sie ein privates Feedback oder Fragen haben, schicken Sie mir eine E-Mail: david at frame dot io.

Wollen Sie für den Frame.io Blog schreiben? Schicken Sie mir eine E-Mail: blog at frame dot io.

Vielen Dank an Larry Jordan, Shane Ross und Philip Hodgetts für ihren Beitrag zu diesem Artikel!