Kodek nie musi być trudny. Nie, naprawdę, nie muszą. Wszystko, co się liczy, to wybór właściwego kodeka.

Pod koniec tego artykułu, będziesz w stanie wybrać najlepszy kodek dla Ciebie w każdym projekcie. Moim celem jest dać ci to, czego potrzebujesz, aby podjąć własne świadome decyzje dotyczące kodeków. Więc można wybrać odpowiedni kodek dla siebie, zamiast polegać na tym, co pracował dla kogoś innego.

Przejdę cię przez każdy krok w procesie tworzenia wideo. Kliknij na nagłówek, aby przejść do tej sekcji. I’ll cover:

- Kodek, którym kręcisz

- Kodek, którym edytujesz

- Kodek, którym korygujesz kolor

- Kodek, którym wysyłasz do VFX

- Kodek, którym eksportujesz

- Kodek, którym archiwizujesz

Na każdym etapie, Wyjaśnię, jakie czynniki powinieneś brać pod uwagę przy wyborze kodeka. Podam również kilka przykładów najczęściej używanych kodeków dla danego etapu.

Po drodze omówimy dlaczego kodeki low-end i high-end mogą spowolnić twoją edycję, powody dla proxy/offline edit, real-world project walkthrough, kilka strategii oszczędzania pamięci i wyjaśnienie dlaczego transkodowanie nie może poprawić jakości obrazu.

Korzyści z optymalizacji kodeków mogą być ogromne. Wybierz odpowiedni kodek, a zachowasz swoje obrazy w najwyższej jakości. Może to również sprawić, że Twoja praca będzie szybsza i pozwoli Ci jak najlepiej wykorzystać możliwości Twojego komputera i pamięci masowej. Będziesz w stanie pracować szybciej na laptopie niż na wysokiej klasy wieży.

Co robi kodek

Kodek to metoda zmniejszania plików wideo, zwykle przez ostrożne wyrzucanie danych, których prawdopodobnie tak naprawdę nie potrzebujemy. I są one całkiem sprytne w tym, jak to robią. Kilka lat temu stworzyłem film, który omawia główne techniki kompresji, których używa wiele kodeków. Nie jest to wymagane do zrozumienia tego artykułu, ale na pewno nie zaszkodzi.

How Codecs Work – Tutorial.

Jeśli pominiesz film, oto kilka bardzo podstawowych wyjaśnień:

- Podpróbkowanie chromatyczne: Wyrzuca niektóre dane kolorów (4:4:4 to brak próbkowania chroma. 4:2:2 jest trochę podpróbkowania chroma.4:2:0 jest dużo podpróbkowania chroma). Źle, jeśli robisz korekcję kolorów. Naprawdę źle, jeśli robisz green screen lub pracę VFX.

- Macro-Blocking: Znajduje bloki (różnej wielkości) o podobnych kolorach i sprawia, że wszystkie są w tym samym kolorze. Złe dla VFX i korekcji kolorów. Prawie wszystkie kodeki używają tego w pewnym stopniu, a ilość zmienia się w zależności od bitrate.

- Kompresja czasowa: Wykorzystuje poprzednie klatki (i czasami następne) do obliczenia bieżącej klatki. Złe dla edycji.

- Głębia bitowa: Liczba możliwych kolorów. Większa głębia bitowa (większe liczby) jest dobra dla korekcji kolorów i VFX.

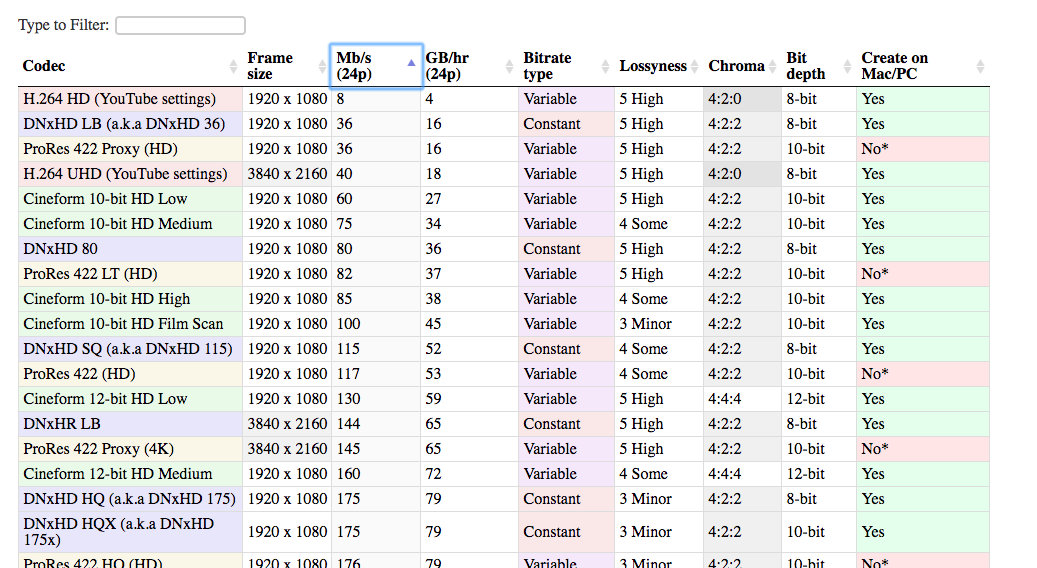

Tabela porównawcza kodeków

Zebrałem także razem listę wszystkich najbardziej powszechnych kodeków używanych w świecie postprodukcji. Ta lista może pomóc Ci porównać różne kodeki ze sobą i podjąć najlepszą decyzję dla Twojego projektu.

Istnieje wiele różnych kodeków, które mogą być używane w procesie edycji. Te, które uwzględniłem są zdecydowanie najbardziej powszechne. Jest znacząca zaleta używania popularnych kodeków. Są one bardziej prawdopodobne, że będą działać na Twoim systemie, systemie Twojego klienta, Twoim systemie za pięć lat, itd. I łatwiej jest znaleźć pomoc, jeśli coś pójdzie nie tak.

Otwórz tabelę w nowej karcie. W ten sposób możesz porównywać kodeki w trakcie czytania artykułu.

Sprawdź tabelę

Stratność

Jedną z kolumn w tabeli jest „stratność”, która jest ważnym pojęciem w przypadku kodeków. Kiedy mówię o stratności, niekoniecznie mam na myśli to, co widzi twoje oko. Mam na myśli ilość danych, które są zachowywane przez kodek, z których tylko część można zobaczyć. Pytanie brzmi: Jeśli miałbym nieskompresowany obraz, a następnie skompresowałbym go za pomocą tego kodeka, jak podobny byłby nowy obraz do starego? Jak dużo informacji jest traconych w transkodowaniu? Jeśli te dwa obrazy są bardzo podobne, to kodek nie jest bardzo stratny. A jeśli są całkiem różne, to jest bardziej stratny.

Stratność jest kombinacją technik, których używa dany kodek i jego bitrate. Bardziej stratny kodek nie jest koniecznie zły. W niektórych przypadkach (podczas oglądania online, na przykład), to naprawdę nie jest konieczne, aby zachować 100% oryginalnego obrazu. Używanie bardziej stratnego kodeka może być naprawdę sprytnym posunięciem z powodu ilości miejsca, które oszczędza.

Jeśli obraz wygląda tak samo dobrze dla mojego oka, to dlaczego powinienem się przejmować tym, że jest technicznie 'stratny’?

Powinieneś się przejmować, ponieważ możesz chcieć zmienić obraz. Jeśli robisz jakąkolwiek korekcję kolorów, to będziesz zmieniał obraz. W rezultacie mogą być widoczne elementy obrazu, które nie były widoczne (lub wyraźne) podczas jego przechwytywania.

Na przykład tutaj znajduje się obraz, który został przechwycony w stanie surowym.

Tutaj znajduje się jego zrzut ekranu skompresowany za pomocą H.264, przy użyciu standardowych ustawień zalecanych przez YouTube.

A następnie skompresowany z DNxHD 350x:

Wszystkie wyglądają bardzo podobnie, prawda? Jakość wizualna jest mniej więcej taka sama, a plik H.264 jest tylko ułamkiem rozmiaru pliku DNxHD. To dlatego jest to zalecane ustawienie dla YouTube. Wygląda to tak samo dobrze dla oka, a plik jest znacznie łatwiejszy do przesłania do Internetu.

Problem z wersją H.264, jednak przychodzi, gdy próbujesz dokonać zmian w obrazie. Co by się stało, gdybyś chciał zwiększyć ekspozycję?

Teraz widzimy, gdzie wysoce skompresowany obraz się rozpada. Jej włosy i koszula wyglądają okropnie na obrazie w formacie h.264, a budynki nad rzeką wyglądają jak muliste.

Właśnie dlatego podczas przechwytywania obrazu naprawdę potrzebny jest wysokiej jakości kodek. Ponieważ prawdopodobnie będziesz chciał później wprowadzić zmiany, ale jeszcze nie wiesz, jakie to mogą być zmiany. Będziesz chciał podrasować kolor i kontrast, może podrasować prędkość, może dodać jakieś VFX. Wysoko skompresowany plik nie pozwala na te zmiany bez uszkodzenia.

Dlatego dobrym pomysłem jest przechwytywanie materiału filmowego w 10-bitach, nawet jeśli w efekcie końcowym będzie to plik 8-bitowy. Nie wiesz, kiedy kręcisz, które bity będą potrzebne.

Podróż po kodekach

Teraz nadszedł czas, aby przejść przez różne etapy, które napotkasz w każdym projekcie.

Każdy projekt zaczyna się od kodeka, który przechwytujesz w aparacie. A kończy się kodekiem, który eksportujesz (kodek dostarczania) i przekazujesz klientowi lub umieszczasz w sieci. W najprostszym przypadku dokonuje się całej edycji i korekcji kolorów bezpośrednio na plikach z kamery. Następnie eksportujesz do swojego kodeka dostarczającego, więc używasz tylko dwóch kodeków.

Ale w większości przypadków jest to trochę bardziej skomplikowane. Możesz transkodować do innego kodeka dla edycji, i potencjalnie dla korekcji kolorów, a na pewno dla VFX. Ale wszystko zaczyna się od…

Kodek, którym kręcisz

(powrót do indeksu)

To jest twój kodek przechwytywania, (zwany także „kodek natywny kamery” lub „kodek akwizycji”).

Ogólnie rzecz biorąc, powinieneś dążyć do najwyższej jakości kodeka, który twoja kamera (lub twój budżet) może przechwycić. Kiedy mówię „najwyższa jakość”, mam na myśli, że chcesz uchwycić jak najwięcej informacji, jak to możliwe. Dlatego chcesz mniej stratnych kodeków: mniejsza kompresja, większa głębia bitowa i mniejsze podpróbkowanie chroma. Im więcej informacji masz w momencie przechwytywania, tym większą elastyczność będziesz miał później. Zwłaszcza w korekcji kolorów i VFX (jeśli się tym zajmujesz).

Oczywiście, musisz też wziąć pod uwagę wiele innych, praktycznych czynników w tej decyzji. W przeciwnym razie zawsze kręcilibyśmy 8K raw, prawda?

Koszt

Pierwszym czynnikiem jest oczywiście koszt. Ogólnie rzecz biorąc, im droższy aparat, tym wyższej jakości kodeki są na nim dostępne. Mówię ogólnie, ponieważ istnieje kilka aparatów „sweet spot”, które mogą zaoferować doskonałe kodeki za rozsądną cenę. Seria GH firmy Panasonic (zwłaszcza we wczesnych dniach, gdy GH2 został zhakowany) była znana z oferowania lepszych kodeków niż inne aparaty w jej przedziale cenowym.

Porada: Lepsze kodeki z zewnętrznymi rejestratorami

Jednym ze sposobów przechwytywania wyższej jakości kodeków na tańszych aparatach jest użycie zewnętrznego rejestratora.

Urządzenia te (wiele z nich może podwoić się jako zewnętrzne monitory) biorą nieskompresowany sygnał z aparatu, przez HDMI lub SDI, i kompresują go osobno. Więc kończysz z dwiema kopiami swojego materiału filmowego. Jedna kopia mocno skompresowana w kamerze, a druga lekko skompresowana w zewnętrznym rejestratorze. Kluczową rzeczą jest to, że aparat wysyła sygnał do rejestratora przed skompresowaniem go.

Jedną ważną uwagą jest to, że wiele tańszych aparatów tylko 8-bitowe wyjście, a często nie w 4:4:4. Zewnętrzny rejestrator może być w stanie skompresować do 12-bitowego kodeka. Ale jeśli kamera wysyła tylko 8 bitów, rejestrator może nagrywać tylko 8 bitów. Niektóre tańsze kamery mogą również nie wysyłać „czystego” sygnału HDMI, który nadaje się do nagrywania. Sygnał wyjściowy nazywamy „czystym”, gdy jest to tylko czysty obraz bez żadnych nakładek interfejsu kamery.

Przechowywanie

Drugim czynnikiem, który należy rozważyć, jest przestrzeń dyskowa. Kodeki wysokiej jakości mają zazwyczaj wyższą prędkość bitową, co oznacza, że pliki są większe. Musisz być przygotowany na przechowywanie i tworzenie kopii zapasowych wszystkich tych plików w trakcie filmowania. Konieczne może być także unowocześnienie kart pamięci, aby można było zapisywać dane o wysokiej przepływności. Jeśli kręcisz solo, możesz w końcu wybrać kodek niższej jakości, ponieważ pozwala on na rzadszą wymianę kart pamięci.

Wykończenie

Kolejnym czynnikiem do rozważenia jest ilość korekcji kolorów i VFX (określanych zbiorczo jako wykończenie), które planujesz wykonać. Jeśli zamierzasz robić bardzo minimalną korekcję kolorów i żadnych VFX, to prawdopodobnie możesz sobie poradzić z niższą głębią bitową, podpróbkowaniem chroma i blokowaniem makr, które pochodzą z niższej jakości kodeków do przechwytywania.

Sprzęt do edycji

Ostatnim czynnikiem do rozważenia jest twoja maszyna do edycji. Większość kodeków przechwytywania nie nadaje się dobrze do edycji bez komputera o wysokiej wydajności. H.264 i niektóre pliki raw wymagają mocnego CPU/GPU do płynnej edycji. Z kolei kodeki o bardzo wysokiej przepływności mogą wymagać szybkich dysków twardych lub serwerów danych. Jeśli nie nagrywasz w kodeku przyjaznym do edycji, być może przed edycją będziesz musiał transkodować swoje pliki do innego kodeka. A to może być czasochłonne. Dla niektórych transkodowanie materiału filmowego nie jest wielkim problemem, ponieważ można to zrobić w nocy lub na wolnym komputerze. Jeśli jednak pracujesz w bardzo krótkim czasie, możesz wybrać kodek, który pozwoli Ci na rozpoczęcie edycji natychmiast po zakończeniu zdjęć, nawet jeśli oznacza to wyższe koszty lub utratę jakości obrazu. Wyjaśniam, które kodeki są najlepsze do edycji w następnej sekcji.

Kodek, którym edytujesz

(powrót do indeksu)

Dobrze, nakręciłeś swój film, i masz wszystkie pliki na swoim komputerze. Teraz musisz zdecydować, czy zamierzasz edytować te pliki. Albo czy chcesz transkodować do innego formatu.

Dlaczego powinienem transkodować przed edycją? Czy nie mogę po prostu edytować plików, które wyszły z aparatu?

Cóż, to zależy. Prawie wszystkie główne pakiety oprogramowania mogą teraz edytować każdy kodek, który tworzy twój aparat. (Chyba, że jesteś badassem strzelającym na zupełnie nowym aparacie z zupełnie nową technologią). Ale podczas gdy prawie zawsze jest możliwe edytowanie kodeków, które twój aparat nakręcił, nie zawsze jest to najlepszy pomysł.

Jeśli masz wystarczająco dużo szczęścia, aby kręcić na kodeku, który jest świetny do edycji, możesz pominąć ten krok.

Dla wielu z nas, jednak, kodek przechwytywania nie będzie zoptymalizowany do edycji. Istnieją dwa główne czynniki, które musisz rozważyć przy wyborze kodeka do edycji: typ kompresji i szybkość bitowa.

Wysoko-kompresyjne kodeki mogą spowolnić twoją edycję

(powrót do indeksu)

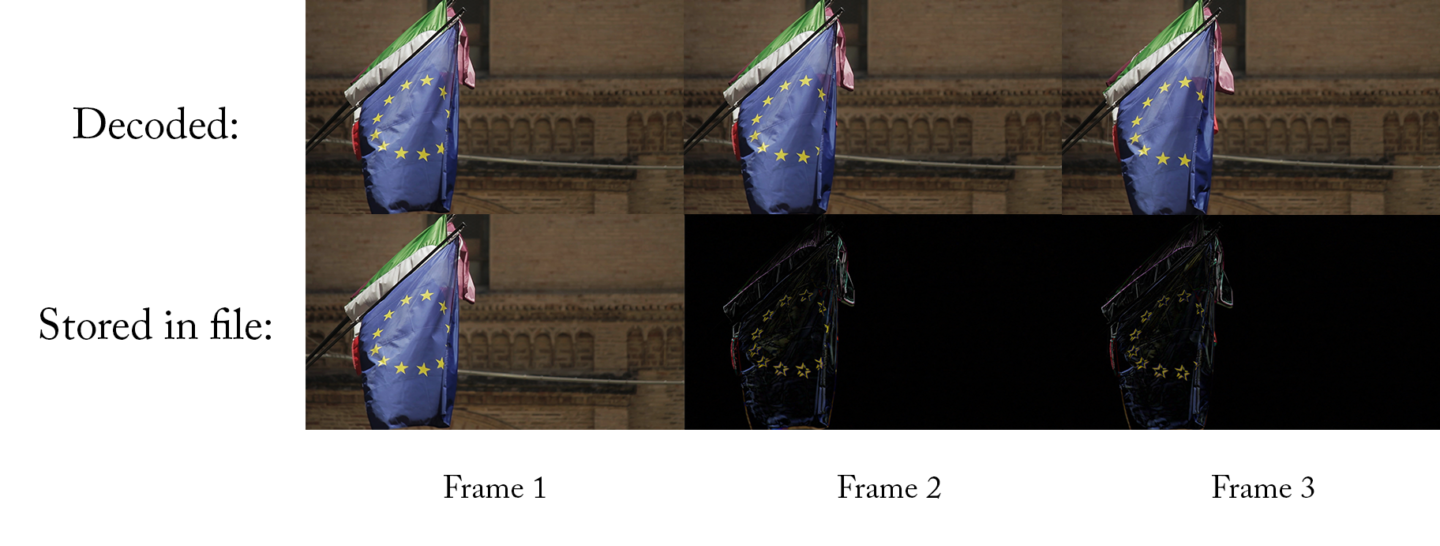

Większość kamer niższej i średniej klasy nagrywa z kodekami, które używają kompresji czasowej, znanej również jako kompresja Long-GOP. Dam ci proste wyjaśnienie tutaj, ale jeśli jesteś zainteresowany nauką w szczegółach, sprawdź moje wideo o kodekach, zaczynając od 19:00.

Proste wyjaśnienie long-GOP jest takie, że dla każdej klatki, kodek przechwytuje tylko to, co zmieniło się między tą klatką a poprzednią. Jeśli wideo nie zawiera dużo ruchu, wtedy nowy plik może być o wiele mniejszy. Różnica między tą a ostatnią klatką to zaledwie kilka pikseli. Więc wszystko, co musisz przechowywać, to kilka pikseli. To świetnie!

Zawsze do przodu

Problemem jest jednak to, że te kodeki mają tendencję do działania dobrze tylko wtedy, gdy są odtwarzane do przodu. (Jeśli jesteś ciekawy dlaczego, spójrz na wideo). To jest świetne do oglądania na YouTube i w odtwarzaczu DVD, ale nie jest świetne do edycji. Podczas edycji często skaczesz dookoła, lub odtwarzasz klip do tyłu. I potrzeba o wiele więcej mocy obliczeniowej by zrobić te rzeczy szybko z kodekiem long-GOP. Komputer high-end może nie mieć problemów, ale nawet komputer średniej klasy będzie lagował i zacinał się, gdy szybko przeskakujesz przez materiał filmowy lub skaczesz dookoła.

Kodeki, które nie są long-GOP (a.k.a. intra-frame codecs), mogą odtwarzać do tyłu tak samo łatwo jak do przodu. Więc nawet średniej klasy komputer może przeskakiwać bardzo płynnie. Jeśli do tej pory edytowałeś tylko klipy prosto z kamery, nie możesz zdawać sobie sprawy z tego, co tracisz!

Inną rzeczą, która może powodować problemy z odtwarzaniem, jest surowe wideo. Surowe wideo musi zostać przekonwertowane przed wyświetleniem (podobnie jak kodeki). A niektóre komputery nie są w stanie zdekodować surowego pliku wystarczająco szybko, zwłaszcza jeśli jest to 4K. Jak na ironię, zarówno aparaty z najniższej półki, jak i te z najwyższej, produkują pliki trudne do edycji!

Kodeki o wysokim bitrate mogą spowolnić twoją edycję

(powrót do indeksu)

Dla kodeków z niskiej i średniej półki, nie musisz się w ogóle martwić o bitrate. Gdy zaczniesz poruszać się w górę drabiny, jednak, kodeki o wysokim bitrate mogą powodować problemy z edycją, zwłaszcza jeśli pracujesz na codziennych komputerach.

Powodem jest to, że twój komputer musi być w stanie odczytać dane z dysku twardego przy bitrate, który jest co najmniej tak wysoki jak bitrate twojego kodeka. To ma sens – jeśli twój kodek ma szybkość 50Mb/s (pięćdziesiąt megabitów na sekundę), to twój komputer musi być w stanie odczytać ten plik z dysku twardego z szybkością 50Mb/s, w przeciwnym razie będzie się zacinał i zostawał w tyle.

(zauważ, że Mb/s oznacza megabity na sekundę, a MB/s oznacza megabajty na sekundę. W bajcie jest osiem bitów, więc trzeba pomnożyć przez 8 przy konwersji z MB/s na Mb/s)

Kilka dobrych wiadomości

Dobrą wiadomością jest to, że dyski twarde są coraz szybsze każdego dnia. Więc 50Mb/s nigdy nie będzie powodować żadnych problemów. Ale co jeśli edytujesz ProRes 422HQ w 4K, co jest 734Mb/s? Przeciętny zewnętrzny dysk twardy jest ledwie wystarczająco szybki, aby odtworzyć taki materiał. Niektóre tańsze dyski twarde w ogóle sobie z tym nie poradzą. A co, jeśli edytujesz multicam z trzema kamerami? Nagle potrzebujesz 3x takiej prędkości przesyłu danych: 2,202Mb/s! W tym momencie będziesz musiał zainwestować w dyski twarde o wysokiej wydajności lub macierze RAID.

Tutaj znajdują się przybliżone wytyczne dotyczące typowych prędkości przechowywania danych. (Zawsze będą pewne modele, które osiągają gorsze lub lepsze wyniki.)

- Standardowy dysk wirujący: 100-120MB/s

- Profesjonalny dysk wirujący: 150-200MB/s

- Standardowy dysk SSD: 400-500 MB/s

- Low-end RAID: 200-300 MB/s

- High-end RAID: 1000-2000 MB/s

Fotografowanie w dzienniku może spowolnić Twoją edycję

Fotografowanie w dzienniku to sposób na zachowanie jak największej części zakresu dynamicznego. Pozwala to na uzyskanie sceny o jasnych przejaśnieniach i ciemnych cieniach bez rozdmuchiwania przejaśnień lub miażdżenia czerni. Rozdmuchane światła są szczególnie nieprzyjemnym efektem ubocznym fotografowania na wideo zamiast na filmie. Dlatego też kręcenie w logu może sprawić, że materiał będzie bardziej filmowy. Teraz, gdy profile log są dostępne nawet w większości kamer prosumer, jest to niezwykle popularny sposób pracy.

Wady

Wadą jest to, że obraz, który wychodzi z kamery nie wygląda tak dobrze. Będziesz musiał dodać kontrast i nasycenie, aby uzyskać nawet blisko do ostatecznego obrazu. Najczęstszym sposobem, aby to zrobić jest dodanie LUT do materiału filmowego. Jest to w zasadzie prosty preset korekcji kolorów, który przywraca materiał do „normalnego” wyglądu.

Jeśli kręcisz w przestrzeni kolorów log, to musisz zastosować LUT do swojego materiału, aby wyświetlić go z normalnym kolorem i kontrastem. Oznacza to, że Twój edytor będzie musiał zastosować odpowiedni LUT do wszystkich klipów podczas edycji. To może być irytujące, a także może spowolnić komputer. Dzieje się tak dlatego, że musi on najpierw zdekodować każdą klatkę, a następnie zastosować LUT przed jej wyświetleniem. Oczywiście możliwa jest edycja materiału filmowego bez LUT, ale nie jest to idealne rozwiązanie. Kolor dwóch ujęć może mieć wpływ na to, jak je przecinasz.

Jeśli zamierzasz transkodować swoje pliki przed ich edycją, możesz zastosować LUT podczas procesu transkodowania. W ten sposób, edytor zawsze pracuje z materiałem, który ma dobry kontrast i kolor i nie musi się przejmować LUTami. Zauważ, że powinieneś to robić tylko jeśli używasz przepływu Proxy, a nie przepływu Direct Intermediate (opisanego poniżej).

Rozważ czas spędzony na kodowaniu

Głównym minusem transkodowania materiału przed edycją jest po prostu czas potrzebny na wykonanie transkodowania. Jeśli masz dużo materiału do przejrzenia, a twój komputer nie jest szybki, może to zająć dużo czasu. Jeśli nie jesteś w wielkim pośpiechu, możesz pozwolić transkodowi działać przez noc, potencjalnie na wielu komputerach, jeśli masz do nich dostęp, ale to nie zawsze jest idealne.

Gdy pracowałem w Khan Academy, nasz założyciel regularnie nagrywał krótkie wiadomości wideo, aby wysłać je do ludzi. Którzy często byli na bardzo napiętych harmonogramach. Zwykle kręciłem w 4K w formacie log long-GOP i edytowałem je na MacBooku Pro. Edycja 4K long-GOP z LUT (do korekcji materiału filmowego) na laptopie oznaczałaby, że mógłbym odtworzyć wideo w Premiere Pro, ale nie mógłbym powiększać na osi czasu tak szybko, jakbym chciał, bez zacinania się.

Ale nie przeszkadzało mi to zbytnio, ponieważ edycja była niezwykle prosta. Tylko kilka cięć, może trochę muzyki, tytuł, i byłem gotowy. Nawet jeśli moja prędkość edycji nie była idealna, spędziłbym więcej czasu na transkodowaniu niż zaoszczędziłbym na prędkości edycji, więc po prostu użyłem oryginalnych plików.

Jeżeli edytowałbym dłuższy kawałek z tym samym ustawieniem, jednak, transkodowałbym do DNxHD lub ProRes. Generalnie, większość transkodowania robiłem w nocy, często na wielu maszynach działających w tym samym czasie.

Proxy Edit

(powrót do indeksu)

Jeśli zamierzasz transkodować natywne pliki z kamery przed ich edycją, wtedy użyjesz „pośredniego” kodeka. Jest on nazywany pośrednim, ponieważ znajduje się pomiędzy kodekiem przechwytującym a kodekiem eksportującym. Istnieją dwa popularne sposoby pracy z pośrednimi kodekami:

Pierwszym z nich jest przepływ pracy „proxy” lub „edycja offline”. Oznacza to, że transkodujesz przechwycony materiał do formatu pośredniego, edytujesz w tym formacie, a następnie ponownie łączysz się z oryginalnymi plikami z kamery przed wyeksportowaniem. Ponieważ do eksportu będziesz używał plików z kamery, a nie plików proxy, nie musisz się tak bardzo martwić o wybór kodeka proxy o świetnej jakości obrazu – kodeki stratne są w porządku. Zamiast tego możesz zoptymalizować szybkość edycji i wygodę przechowywania.

Praca z proxy jest tak powszechna, że wiele wysokiej klasy kamer nagrywa wysokiej klasy surowy plik *i* plik ProRes lub DNxHD proxy w tym samym czasie. Po zakończeniu zdjęć, surowe pliki są archiwizowane i umieszczane w magazynie. Pliki proxy są wysyłane do redaktorów oraz do reżysera/producenta w celu wykonania dailies.

Unikaj kompresji czasowej

Wybierając kodek proxy, chcesz wybrać taki, który nie używa kompresji czasowej (aka inter-frame compression lub long-GOP compression) i chcesz wybrać taki, który ma niższy bitrate. Niski bitrate oznacza, że pliki są dużo mniejsze, więc możesz użyć mniejszej ilości/mniejszych/tańszych dysków twardych, upraszczając swój przepływ pracy. Woot!

Ponieważ pliki proxy są świetne do edycji, nie powinieneś robić więcej niż podstawowa korekcja kolorów z plikami proxy. Jeśli masz zamiar zrobić wszystkie swoje korekty kolorów wewnątrz swojego oprogramowania do edycji, to najlepiej jest ponownie połączyć się z plikami aparatu, ponieważ pliki proxy mogą mieć niższą jakość kolorów.

Dobrą wiadomością jest to, że większość oprogramowania do edycji dzisiaj może przełączać się między plikami aparatu i plikami proxy w zaledwie kilka kliknięć, więc można nawet iść tam i z powrotem, jeśli trzeba.

Opublikowaliśmy szczegółowe przewodniki dotyczące przepływów pracy z plikami proxy w każdym z głównych programów NLE:

- Final Cut Pro X Proxy Workflows

- Premiere Pro Proxy Workflows

- Avid Media Composer Proxy Workflows

Kilka dobrych wyborów dla kodeków proxy

Zdecydowanie najczęściej stosowanymi kodekami proxy są DNxHD/DNxHR i ProRes. Oba są dostępne od lat, więc są bardzo szeroko obsługiwane. Każdy wie jak je obsługiwać. Oba są bardzo dobrze dopasowane do przepływu pracy proxy (ProRes ma nawet preset o nazwie „proxy”), i są prawie wymienne, gdy są używane do proxy.

DNxHD jest tworzony przez Avid, a ProRes przez Apple. Więc to ma sens, że DNxHD będzie działać lepiej na Media Composer i ProRes będzie działać lepiej na Final Cut Pro X. To kiedyś z pewnością było prawdą, ale obecnie oba kodeki działają bardzo płynnie na wszystkich nowoczesnych edytorach (w tym Premiere Pro). Może być niewielki wzrost prędkości przy użyciu kodeka, który został zaprojektowany dla systemu, ale jest bardzo niewielki.

Jedyną znaczącą różnicą między nimi dla przepływu pracy proxy jest fakt, że możesz mieć problemy z tworzeniem ProRes na PC, podczas gdy DNxHD jest bardzo łatwy do tworzenia międzyplatformowego. Jedynym oficjalnie wspieranym sposobem tworzenia ProRes na PC jest Assimilate Scratch. Istnieje kilka innych, niewspieranych metod tworzenia plików ProRes na PC, ale nie zawsze są one niezawodne. Komputery PC mogą łatwo odtwarzać i edytować pliki ProRes, ale nie można kodować nowych plików ProRes na PC tak łatwo jak DNxHD, więc niektórzy edytorzy wolą DNxHD workflow z tego powodu.

Wybierz pas

Bez względu na to, który z dwóch kodeków wybierzesz, musisz również wybrać, który smak chcesz. To naprawdę będzie zależeć od ograniczeń pamięci masowej – jest to kompromis między jakością obrazu a rozmiarem pliku. Dobra wiadomość jest taka, że nie potrzebujesz tip-top jakości obrazu podczas edycji, więc możesz wybrać kodek o niskim bitrate.

Zacznij od najmniejszego kodeka ProRes lub DNx w tej samej rozdzielczości co twój kodek przechwytywania. Spójrz na kolumnę GB/godzinę i pomnóż ją przez liczbę godzin materiału filmowego, który posiadasz. Jeśli masz wystarczająco dużo miejsca na dysku, to dobrze – użyj tego kodeka. Jeśli masz dużo dodatkowej przestrzeni dyskowej, pomyśl o użyciu następnego największego smaku.

Ale jeśli nie masz wystarczająco dużo miejsca na dysku, lub jeśli jesteś na słabo zasilanej maszynie, to zmniejsz rozdzielczość. Wiele wysokobudżetowych filmów hollywoodzkich zostało zmontowanych w 480p zaledwie kilka lat temu, więc nie przejmuj się, jeśli musisz obniżyć rozdzielczość z 4K do 720P dla edycji.

Direct Intermediate

Innym rodzajem pośredniego przepływu pracy jest coś, co nazywam Direct Intermediate. Oznacza to, że transkodujesz pliki z kamery do kodeka, który jest zarówno dobry do edycji, jak i bardzo wysokiej jakości (niezbyt stratny). Ponieważ kodek jest bardzo wysokiej jakości, prawie wszystkie oryginalne informacje z plików z kamery zostały zachowane, więc nie ma potrzeby ponownego łączenia się z plikami z kamery – można po prostu eksportować bezpośrednio z plików pośrednich. Będzie pewna teoretyczna utrata informacji podczas transkodowania, ale jeśli wybierzesz wystarczająco dobry kodek pośredni, będzie to na tyle małe, że nie musisz się o to martwić.

(Uwaga: Nazywam ten proces „Direct Intermediate”, ponieważ nie ma wspólnej nazwy dla tego przepływu pracy. Ludzie zwykle nazywają to po prostu „pośrednim”, ale to może być mylące, ponieważ przepływy proxy są również rodzajem pośredniego przepływu pracy. Niektórzy ludzie nazywają to także przepływem „online”, ale to także jest mylące, ponieważ ten termin został stworzony do opisania przepływu pracy, który zawiera edycję offline i online, a nie przepływu pracy, który jest online od początku do końca.)

Zachowanie jest kluczem

Kluczem do wybrania dobrego kodeka Direct Intermediate jest upewnienie się, że zachowujesz wszystkie informacje z twojego kodeka przechwytującego. Kodek pośredni nigdy nie sprawi, że twoje obrazy będą lepsze (bardziej szczegółowe wyjaśnienie poniżej), ale zdecydowanie może je pogorszyć, jeśli wybierzesz zły kodek. Ważną rzeczą jest zrozumienie szczegółów oryginalnego materiału filmowego i upewnienie się, że Twój pośredni kodek jest co najmniej tak dobry jak kodek przechwytujący w każdym obszarze. Jeśli nagrywasz materiał lustrzanką cyfrową, taką jak Sony A7Sii, w rozdzielczości 4K, będziesz nagrywał w kodeku 4:2:0, 8-bitowym, Long-GOP z prędkością 100 Mbps. Potrzebujesz pośredniego kodeka, który jest co najmniej 4:2:0 i 8-bitowy. Wyjście poza te wartości (np. do 4:4:4 i 12 bitów) nie zaszkodzi, ale też nie pomoże. Więc prawdopodobnie nie jest to warte dodatkowej przestrzeni dyskowej.

Powiedzmy, na przykład, że chcemy wybrać kodek ProRes. Mamy 4 opcje do wyboru, które są 4:2:2 i 10-bitowe.

- 145Mb/s ProRes 422 Proxy

- 328Mb/s ProRes 422 LT

- 471Mb/s ProRes 422

- 707Mb/s ProRes 422 HQ

Over and above

Można by pomyśleć, że wszystko, czego potrzebujesz, to dopasować bitrate kamery (100Mb/s), ale w rzeczywistości należy znacznie przekroczyć bitrate kamery. Dzieje się tak dlatego, że h.264 jest znacznie wydajniejszym kodekiem niż ProRes. Ponieważ h.264 wykorzystuje kompresję long-GOP, może upakować o wiele więcej informacji w tych 100 megabitach niż ProRes. Aby ProRes mógł dorównać jakością obrazu h.264, potrzebny jest znacznie wyższy bitrate. Zalecałbym używanie tylko ProRes 422 lub ProRes 422 HQ, jeśli zaczynasz pracę z kodekiem h.264 o przepływności 100 Mb/s. ProRes 422 prawdopodobnie wystarczy, ale jeśli masz dużo miejsca na dysku, to przejście do ProRes 422 HQ będzie miało niewielką przewagę.

Choć dobrze jest po prostu dopasować głębię bitową i próbkowanie kolorów przy wyborze pośredniego, zawsze powinieneś zwiększyć bitrate przynajmniej trochę. Jeśli przechodzisz z kodeka long-GOP do kodeka non-long GOP, powinieneś zwiększyć bitrate znacznie.

Uwaga dodatkowa: Jeśli chciałeś iść z DNxHD zamiast ProRes, masz podobne opcje, z wyjątkiem tego, że DNxHD oferuje również 8-bitową wersję dla kodeków niższej klasy. Ponieważ nasz materiał filmowy jest 8-bitowy na początek, nie zaszkodzi nam to wcale.

Proxy workflow brzmi całkiem nieźle. Po co robić Direct Intermediate?

Częścią powodu, dla którego Direct Intermediate jest powszechne, jest to, że kiedyś było o wiele trudniej używać proxy. Niektórzy z głównych dostawców oprogramowania nie ułatwiali szczególnie ponownego łączenia się z oryginalnymi plikami aparatu, więc ludzie wybierali bezpośredni przepływ pośredni. Obecnie jednak jest to dość łatwe do zrobienia w każdym pakiecie do edycji. Wyjątkiem jest sytuacja, gdy mamy wiele mieszanych typów materiału filmowego. Jeśli masz wiele częstotliwości klatek i rozmiarów klatek w tym samym projekcie, przełączanie się z proxy do kodeków przechwytywania może być bólem głowy.

Jeśli używasz narzędzi innych firm, aby pomóc przygotować i zorganizować swój materiał przed rozpoczęciem cięcia, mogą one również sprawić, że proces łączenia będzie bardziej skomplikowany. Jednym z powszechnych przykładów może być oprogramowanie, które automatycznie synchronizuje ścieżki audio lub ujęcia multicam.

Bez konieczności zamiany

Kolejnym powodem, dla którego możesz chcieć użyć przepływu Direct Intermediate jest to, że możesz przejść od razu do korekcji kolorów i procesu VFX („wykańczania”) bez zamiany jakichkolwiek plików. Czytaj dalej, a ja wyjaśnię więcej dlaczego jest to wygodne w sekcjach Color-Correction i VFX.

Jednym minusem, jednakże, jest to, że nie możesz „zapiekać” LUTów dla swojego edytora – będziesz musiał zastosować LUT poprzez efekt korekcji kolorów w swoim programie do edycji. Jeśli miałbyś włączyć LUT do swojego przepływu pracy transkodowania dla Direct Intermediate, straciłbyś wszystkie korzyści z nagrywania w logu w pierwszej kolejności.

Innym oczywistym minusem jest to, że musisz przechowywać wszystkie te (znacznie większe) pliki.

Pośredni kodek nigdy nie sprawi, że twoje obrazy będą lepsze

(powrót do indeksu)

To jest bardzo ważne, ponieważ jest to bardzo powszechnie źle rozumiane, a w sieci jest wiele błędnych informacji. Transkodowanie materiału filmowego przed edycją nigdy nie zwiększy jakości wyjściowej. Istnieją pewne dodatkowe operacje, które można wykonać w procesie transkodowania (takie jak użycie wyrafinowanych narzędzi up-res), które mogą zwiększyć jakość obrazu w niektórych przypadkach, ale nowy kodek sam w sobie nigdy nie zwiększy jakości obrazu.

Jeśli wybierzesz odpowiedni kodek, można uniknąć uszkodzenia obrazu, ale nigdy nie można go poprawić.

To obejmuje przejście z h.264 do DNxHD lub ProRes. Obejmuje to również przejście z 8-bitów na 10-bitów. I przejście z 4:2:0 do 4:4:4.

Oto ilustracja, która może pomóc w zrozumieniu tej koncepcji:

To jest zdjęcie róży odbijającej się w kropli wody. Ma 4 megapiksele i wygląda całkiem ładnie na moim 27-calowym monitorze.

A co by było, gdybym zrobił zdjęcie mojego monitora aparatem Red Helium 8k. To jest bestia wśród aparatów. Zdjęcie róży zrobiłem kilka lat temu tanią lustrzanką Canon Rebel DSLR, wartą dziś około 250 dolarów. Konfiguracja Red Helium kosztuje około $50,000, ma 35 megapikseli, jest surowa, ma jeden z najlepszych czujników aparatu, jaki kiedykolwiek wyprodukowano.

Który obraz będzie lepszy – zdjęcie 4 megapikseli, czy zdjęcie 35 megapikseli?

Przechwycenie przechwycenia

Kamera Red ma więcej megapikseli, prawda? Jest surowy, i ma całą cyfrową magię Red, prawda? Ale ponieważ używam mojego aparatu o wysokiej rozdzielczości do zrobienia zdjęcia zdjęcia, a nie zdjęcia róży, mój fantazyjny nowy obraz nigdy nie będzie lepszy od pierwszego. Mam plik, który jest technicznie wyższej rozdzielczości, ale nie przechwytuje więcej mojego przedmiotu (róży) niż pierwszy zrobił.

To jest to, co robisz podczas transkodowania. Robisz kopię kopii kopii, robiąc zdjęcie zdjęcia zdjęcia. Jeśli używasz wymyślnego aparatu o wysokiej rozdzielczości do zrobienia zdjęcia zdjęcia, będziesz w stanie zachować całkiem sporo informacji w oryginalnym obrazie, ale nie będziesz w stanie dodać nic więcej.

Dużym zastrzeżeniem jest to, że jeśli robisz jakiekolwiek przetwarzanie, jakiekolwiek przekształcanie obrazu (dodawanie LUT, na przykład), wtedy zdecydowanie chcesz transkodować do kodeka o wyższej jakości, który zachowa nowe informacje. Ale jeśli nie zmieniasz obrazu, to transkodowanie nie sprawi, że twój obraz będzie w jakiś sposób „lepszy.”

Przykład z prawdziwego świata

(powrót do indeksu)

Powiedzmy, że edytujesz film dokumentalny, który uchwycił materiał 4K przy użyciu kamery Sony A7sii, nagrywając w wersji XAVC-S z długim GOP. Nie jest to idealne rozwiązanie do edycji. Jeśli nakręcono 40 godzin materiału na Twój pełnometrażowy film dokumentalny, skończyłbyś z około 2,7 TB plików z kamery, które z łatwością zmieszczą się na jednym dysku twardym (oczywiście po wykonaniu innych, oddzielnych kopii zapasowych!).

Mógłbyś przekonwertować to do wysokiej jakości, nie bardzo stratnego kodeka dla przepływu Direct Intermediate, może ProRes 422 HQ w 4K.

Wadą jest to, że potrzebowałbyś około 12,7TB, aby przechowywać wszystkie te pliki ProRes. Musiałbyś użyć drogiej konfiguracji RAID, aby mieć łatwy dostęp do całego tego materiału filmowego w jednym projekcie, co najmniej 1,000$. Orzeszki ziemne dla dużego zakładu, ale znacząca inwestycja dla samodzielnego montażysty.

Wybór proxy

Więc możesz zdecydować się na użycie przepływu Proxy zamiast tego i transkodować swoje pliki do formatu ProRes 422 Proxy 4K. Wtedy Twój materiał filmowy zajmie tylko 2,8 TB, czyli niewiele więcej niż zarejestrowany materiał. Możesz wtedy łatwo edytować z jednego dysku twardego, a Twój przepływ pracy staje się o wiele prostszy. (Instrukcje, jak obliczać bitrate i rozmiary plików, znajdziesz w tym artykule: The Simple Formula to Calculate Video Bitrates).

Powiedzmy, że pracujesz z innym edytorem, który jest na drugim końcu kraju. Możesz zdecydować się na transkodowanie materiału jeszcze bardziej w dół do ProRes 422 Proxy HD, co zmniejszyłoby objętość materiału do zaledwie 640GB, co jest bardziej wykonalne do wysłania przez Internet, jeśli masz szybkie łącze. (18 godzin pobierania przy połączeniu 80Mbps)

Gdy edycja jest zakończona, wystarczy ponownie połączyć projekt z oryginalnymi plikami z kamery i wyeksportować. Nawet jeśli ty i twój zdalny edytor pracowaliście w dość stratnym kodeku, ostateczny eksport omija go, więc nie tracisz żadnej jakości.

Kodek, którym korygujesz kolor

(powrót do indeksu)

Ok, teraz masz już zmontowane wideo i nadszedł czas na korekcję kolorów. Wszystko, o czym tu mówimy, będzie miało zastosowanie niezależnie od tego, czy dokonujesz korekcji barwnej w swojej aplikacji do edycji, czy też wysyłasz swoją edycję do dedykowanego oprogramowania do korekcji barwnej.

Ważnym pytaniem w tym momencie jest, czy chcesz dokonać korekcji barwnej bezpośrednio na oryginalnych plikach z kamery, czy też chcesz dokonać transkodowania. Jeśli zrobiłeś proxy / offline edycji, to na pewno nie chcesz kolor korekty plików proxy, ponieważ mają one niższą jakość obrazu. W celu podjęcia dobrych decyzji o kolorze, trzeba najwyższej jakości obrazu, że masz dostępne, bo trzeba być w stanie zobaczyć dokładnie to, co masz do pracy.

Więc musimy pracować z wysokiej jakości obrazów, i mamy kilka różnych opcji:

A. Gradacja plików z kamery

Jest to z pewnością prosta opcja. Jeśli zrobiłeś edycję proxy, możesz ponownie połączyć się z plikami kamery dla procesu wykańczania i iść do miasta. To da ci maksymalną jakość obrazu, ale pamiętaj, jak pliki kamery mogą być powolne do pracy z? Pliki z kamery mogą nieco spowolnić proces, ale w zależności od oprogramowania, którego używasz i ilości pracy, którą musisz wykonać, możesz zdecydować, że prostota jest warta odrobiny potencjalnego spowolnienia. Jeśli masz krótką edycję bez dużej złożoności, to może to być świetny i łatwy workflow.

Załóżmy, że spowolnienie korekcji kolorów przeszkadza ci, więc potrzebujesz kodeka, który jest łatwiejszy do pracy. Mógłbyś transkodować cały swój materiał filmowy do kodeka wysokiej jakości, połączyć się z tymi plikami, a następnie zacząć wykonywać korekcję barwną. Ale… to w pewnym sensie mija się z celem pracy z proxy, nieprawdaż? Używaliśmy proxy, ponieważ nie chcieliśmy mieć do czynienia z dużymi plikami, które by powstały. Na szczęście istnieje inna opcja.

B. Consolidate and Transcode

(powrót do indeksu)

Jeśli użyłeś proxy/offline workflow do edycji, ale nie chcesz korygować kolorów plików z kamery, jedną z dobrych opcji jest ponowne połączenie z plikami z kamery, skonsolidowanie projektu, a następnie transkodowanie do wysokiej klasy kodeka.

Gdy skonsolidować projekt, oprogramowanie do edycji będzie kopię projektu wraz z kopią mediów, ale tylko poszczególnych plików, które skończyły się przy użyciu w swojej sekwencji. Jeśli więc nakręciłeś 7 ujęć, ale w edycji użyłeś tylko jednego z nich, skopiuje ono tylko to jedno ujęcie. To znacznie zmniejsza ilość miejsca na dysku, co przydaje się na tym etapie. Możesz również skonsolidować je jeszcze bardziej, tak aby zachować tylko te fragmenty każdego ujęcia, które rzeczywiście zostały wykorzystane w edycji, odrzucając resztę. W tym przypadku, oprogramowanie będzie zazwyczaj zawierać kilka sekund przed i po każdym ujęciu (tzw. „uchwyty”), w przypadku, gdy chcesz dodać fade lub motion tracking.

Start your grade

Teraz można wziąć ten nowy skonsolidowany projekt (po powiązaniu z oryginałami) i transkodować wszystkie te pliki do bardzo wysokiej jakości, wysokiej bitrate kodek, i rozpocząć korekcję kolorów. Różni się to od przepływu pracy Direct Intermediate, ponieważ nie transkodujesz całego materiału filmowego – tylko ten, który trafił do ostatecznej edycji, a który może być o 1/20 lub 1/50 krótszy niż materiał, który pierwotnie nakręciłeś. Teraz transkodowanie do kodeka o wysokim bitrate nie brzmi już tak źle, bo nie trzeba przechowywać tak dużo materiału. Nawet przy ProRes 4444 4K, pełnometrażowy film fabularny będzie miał tylko około 2TB – całkiem do opanowania.

Teraz możesz skończyć swój film z najwyższej jakości obrazami i szybkim przetwarzaniem, na dysku twardym, który mieści się w kieszeni. Woot!

C. Carry on the Direct Intermediate

Trzecią opcją jest przejście z Direct Intermediate edycji przepływu pracy, w którym to przypadku jesteś dobry, aby przejść. Już transkodowane wszystkie swoje pliki do wysokiej jakości kodeka przed rozpoczęciem edycji, więc można po prostu kontynuować z tych samych plików do korekcji kolorów. To jest również wygodne, ponieważ te pliki są dobre zarówno do edycji i korekcji kolorów i VFX (patrz poniżej).

Jeśli jesteś przekazywanie projektu do zewnętrznego kolorysta lub VFX osoby, a następnie można albo dać im wszystkie swoje wysokiej jakości materiału filmowego (potencjalnie irytujące ze względu na rozmiar), lub można użyć tej samej końcówki konsolidacji, że użyliśmy powyżej. Przekazanie skonsolidowanego projektu może pomóc Ci poruszać się szybciej i zaoszczędzić czas kolorysty, jak również.

Inna zaleta

Oprócz prostoty przepływu pracy Direct Intermediate (używasz tylko jednego zestawu plików), masz jeszcze jedną zaletę: przechodzenie tam i z powrotem między edycją a korekcją barwną jest prostsze.

Wyobraź sobie, że skończyłeś swoją edycję proxy – konsolidujesz i transkodujesz, wysyłasz do kolorysty, a potem decydujesz, że musisz dokonać pewnych zmian w edycji. Teraz musisz wrócić do plików proxy, aby dokonać edycji, a następnie ponownie skonsolidować i wysłać materiał. Mechanika tego procesu może być dość chaotyczna. W wysokiej klasy postprodukcji, zazwyczaj istnieje „blokada” na edycję, dzięki której można rozpocząć proces wykańczania. Oznacza to, że (o ile nie dzieją się złe rzeczy) będziesz się bardzo starał nie wracać i nie wprowadzać zmian do montażu. Ale hej, złe rzeczy się zdarzają, więc najlepiej być przygotowanym.

A teraz znajdujemy kolejny dobry powód dla Bezpośredniej edycji pośredniej. Jeśli zamierzasz wykonywać niektóre z twoich prac kolorystycznych i edycyjnych jednocześnie, lub przynajmniej masz zamiar wracać i wracać kilka razy, wtedy może być prościej użyć jednego kodeka dla obu. Jest to szczególnie wygodne, jeśli wykonujesz swoją edycję i wykończenie w tym samym pakiecie oprogramowania (lub zestawie pakietów, np. Creative Cloud).

Kodek, który wysyłasz do VFX

(powrót do indeksu)

Jeśli wykonujesz jakąkolwiek pracę VFX, to prawdopodobnie będziesz potrzebował wysłać pliki do innego programu (potencjalnie innej maszyny, dla innego artysty). Jeśli wykonujesz całą swoją pracę VFX w edytorze (co staje się coraz bardziej opłacalne w przypadku prostych zadań), możesz pominąć tę sekcję. Po prostu użyj tego samego kodeka, którego użyłeś do korekcji kolorów.

Dla większości z nas, jednakże, musimy skonfigurować proces „round-trip”, który wysyła klipy z edytora do oprogramowania VFX, a następnie z powrotem, gdy są gotowe. Dzieje się to na zasadzie ujęcia po ujęciu, więc nie wysyłasz całej sekwencji do VFX, jak to zapewne miało miejsce przy korekcji barwnej. Kwestia tego, kiedy wysyłasz ujęcia do VFX, zależy w dużej mierze od konkretnego przepływu pracy.

Niektórzy wysyłają ujęcia do VFX po zamknięciu edycji i zakończeniu korekcji barwnej, ale presja czasu może zmusić Cię do rozpoczęcia wysyłania ujęć wcześniej.

Jeśli edytujesz w Premiere Pro i robisz łagodne VFX w After Effects z Dynamic Link, możesz pominąć tę sekcję. Dynamic Link automatycznie wykona za Ciebie round-tripping. Jeśli wykonujesz dużo pracy VFX, możesz nadal chcieć skorzystać z technik zawartych w tej sekcji, ponieważ Dynamic Link może być nieco wybredny przy zbyt dużej liczbie projektów. Adobe jednak zawsze pracuje nad tymi błędami, więc jest to częściowo zależne od osobistego gustu.

Go big or go home

W procesie VFX, masz tendencję do używania bardzo high-endowych (high bitrate) kodeków z dwóch głównych powodów. Pierwszym z nich jest po prostu to, że artyści VFX potrzebują wszystkich informacji, jakie można im przekazać, aby dobrze wykonywać swoją pracę. Artyści VFX są jednymi z najbardziej wybrednych ludzi jeśli chodzi o kodeki, i nie bez powodu. Każdy chce wysokiej jakości obrazów, ale problemy z obrazem mogą często stanowić większy problem dla VFX niż dla edycji, korekcji kolorów i ostatecznego eksportu.

Wiele zadań w pracy VFX wymaga bardzo szczegółowej analizy obrazu na poziomie piksel po pikselu, czego większość edytorów nigdy nie musi robić. Na przykład, jeśli robisz ekstrakcję na green-screen, chcesz, by krawędź między postacią a green-screenem była tak czysta, jak to tylko możliwe. Wszyscy widzieliśmy okropne ujęcia greenscreen, w których krawędzie postaci są poszarpane lub rozmyte. Problemy te często wynikają z artefaktów kompresji obrazu, które są niewidoczne gołym okiem. Na przykład podpróbkowanie kolorów 4:2:2 lub 4:2:0 nie ma prawie żadnego widocznego wpływu na obraz. Ludzkie oko zwraca uwagę głównie na kontrast i rzadko zauważa niską rozdzielczość kolorów, ale proces ekstrakcji greenscreen opiera się głównie na wartościach kolorów. Jeśli kodek wyrzucił dużą część wartości kolorów przez użycie podpróbkowania chroma 4:2:0, dobry klucz kolorów może być niemożliwy.

Strata generacji

Drugim powodem, dla którego chcesz używać wysokiej klasy kodeków, jest strata generacji. W procesie VFX, prawdopodobnie będziesz musiał skompresować swój plik wiele razy. Skompresujesz plik raz, kiedy wyślesz go do nich. A potem, jeśli będą musieli przekazać plik między wieloma specjalistami, mogą go skompresować dwa lub trzy razy, zanim go odeślą. Gdy plik jest kompresowany wielokrotnie, nazywamy to wielokrotną utratą generacji.

Jeśli używasz kodeka niskiej klasy, obraz będzie się stopniowo pogarszał za każdym razem, gdy będziesz go ponownie kompresować. Jedną z wielkich rzeczy w naprawdę wysokiej jakości kodekach jest to, że można je skompresować kilka razy bez utraty jakości. Chociaż zawsze lepiej jest unikać wielokrotnej kompresji wideo, jeśli używasz bardzo wysokiej jakości kodeków, zazwyczaj wszystko jest w porządku.

Niektóre wysokiej klasy przepływy pracy VFX będą używać tylko kompresji bezstratnej z tego powodu. Dobra wiadomość jest taka, że ujęcia VFX trwają zwykle tylko kilka sekund na klip, co oznacza, że rozmiary plików będą niewielkie nawet przy użyciu wysokiej klasy kodeków. Więc zrób coś dużego! Jeśli uchwyciłeś 4:4:4 w kamerze, to zdecydowanie wyślij 4:4:4 do VFX. W przeciwnym razie wybrałbym najwyższej klasy kodek 4:2:2 (ProRes 422 HQ lub DNxHQX).

I oczywiście zawsze powinieneś wcześniej porozumieć się z VFX co do tego, jaki kodek wysłać. Jeśli uważasz, że dokonują złego wyboru, wyślij im ten artykuł 🙂

Kodek, który eksportujesz

(powrót do indeksu)

Jak już skończyłeś edycję, kolor i VFX – jesteś gotowy do eksportu. Zazwyczaj ostateczny eksport wykonujesz z oprogramowania, którego użyłeś do korekcji kolorów, używając kodeka, którego użyłeś w procesie korekcji kolorów.

Jeśli twój klient zajmuje się mediami, powinien wiedzieć, jakiego kodeka chce, więc możesz pominąć resztę tej sekcji!

Jeśli twój klient nie jest ekspertem wideo, mogą nie wiedzieć, czego chcą, więc trzeba podjąć pewne decyzje dla nich. Przez większość czasu, klient będzie chciał wideo do przesłania na YouTube i/lub inne strony mediów społecznościowych. Możesz być kuszony, aby wybrać kodek, który jest dobry do strumieniowania w Internecie. Ale byłbyś w błędzie!

Powód: te strony nie przesyłają strumieniowo tego samego pliku, który przesyłasz do swoich widzów – kompresują plik *ponownie* przed jego przesłaniem, a Ty nie masz absolutnie żadnej kontroli nad ustawieniami, których używają. Oznacza to, że jeśli załadujesz niskiej jakości kodek, to mamy scenariusz, w którym robimy zdjęcie niskiej jakości ze zdjęcia niskiej jakości, o którym mówiliśmy. Źle! Unikaj!

Dąż do najlepszej jakości

Jako ogólna zasada, jeśli chcesz uzyskać wynik najlepszej jakości, powinieneś załadować źródło o najlepszej jakości. Oni i tak będą kompresować ponownie, więc danie im więcej danych do pracy nie zaszkodzi, prawda? Jeśli masz wystarczająco szybkie łącze, możesz przesłać ProRes 422. Niektórzy ludzie zgłosili nieco (tylko nieco) lepsze wyniki podczas przesyłania ProRes zamiast zalecanego h.264.

Jeśli dostarczasz plik do klienta, aby przesłać go do Youtube, wtedy nie dałbym im ProRes, ponieważ nie wiesz, jaki rodzaj przepustowości będą mieli. Na szczęście, te strony mają tendencję do publikowania zalecanych specyfikacji wysyłania (wystarczy wygooglować). Ja osobiście wezmę jakikolwiek bitrate, który zalecają i pomnożę przez około 1.5x do 2x.

Twój klient może również chcieć plik, który może osadzić bezpośrednio na swojej stronie internetowej (choć odradzam, jeśli możesz). Ogólnie rzecz biorąc, chcesz mieć bardzo mocno skompresowany h.264. Jeśli jesteś ciekawy, jaki jest dobry bitrate, moje rozumowanie jest takie, że jeśli ktokolwiek wie, jaki jest bitrate sweet-spot, to jest to YouTube. Okresowo pobieram wideo z YouTube i sprawdzam jego bitrate, i używam tego jako wzorca.

Going small

Jeśli wideo nie jest publiczne, mogą również chcieć mały plik, który mogą wysłać e-mailem lub połączyć bezpośrednio z własnymi klientami, aby mogli go pobrać. W takich przypadkach, może być właściwe dostarczenie więcej niż dwóch oddzielnych plików, zwłaszcza jeśli jest to długi film. Plik, który powinni przesłać na YouTube będzie zbyt duży, aby wygodnie wysłać go pocztą elektroniczną. W takim przypadku zazwyczaj zmniejszam rozmiar pliku i bardzo mocno go kompresuję. Musisz również być realistą i zdecydować, czy myślisz, że twój klient rzeczywiście zrozumie różnicę między tymi dwoma plikami.

Jeśli muszę dostarczyć więcej niż jeden plik, zwykle nazywam jeden z nich „HD” w nazwie pliku, a drugi „mały” lub „nie HD” w nazwie pliku. Jeśli spróbujesz opisać im różne kodeki, mogę prawie zagwarantować, że zapomną różnicę do następnego tygodnia, ale prawdopodobnie będą pamiętać, co oznacza HD i „nie HD”.

Kodek, który archiwizujesz

(powrót do indeksu)

Dostarczyłeś plik(i) swojemu klientowi, więc teraz możesz usiąść i zrelaksować się… prawie.

Jak każdy pracujący profesjonalista w tej branży wie, dzień, w którym dostarczasz gotowy produkt swojemu klientowi, często nie jest ostatnim, w którym dotykasz projektu. Czasami klient chce wrócić i zmienić coś kilka tygodni później, lub chce wyższej jakości kodek, lub może chcesz dodać go do swojego osobistego kołowrotka. W każdym z tych przypadków mogłeś przenieść się na inną maszynę lub inne oprogramowanie, co sprawia, że otwieranie oryginalnego projektu i ponowny eksport to ból głowy.

That’s handy

This is where it comes in handy to have a great archive of the finished project in an extremely high-quality codec. Jeśli twój klient zażądał bardzo wysokiej jakości kodeka do dostarczenia, to generalnie jesteś przygotowany. Po prostu zachowaj kopię tego pliku i wszystko gra. Jeśli jednak klient zażąda kodeka, który nie jest najwyższej jakości, zawsze dobrze jest wykonać własny eksport przy użyciu kodeka bezstratnego lub tak bliskiego bezstratnemu, jak tylko możesz sobie na to pozwolić, biorąc pod uwagę ilość miejsca, jaką zajmie. Ja zazwyczaj eksportuję do kodeka o bardzo wysokiej przepływności 4:4:4 – albo DNxHD/HR albo ProRes.

Masz pytania? Komentuj dalej.

Właściwie czytam każdy komentarz. Ten artykuł jest w toku i będę go aktualizował, dodając więcej wyjaśnień i przykładów w oparciu o Wasze opinie. Jeśli masz jakieś prywatne uwagi lub pytania, wyślij mi e-mail: david at frame dot io.

Chcesz pisać na blogu Frame.io? Wyślij do mnie e-mail: blog at frame dot io.

Wielkie podziękowania dla Larry’ego Jordana, Shane’a Rossa i Philipa Hodgettsa za ich wkład w ten artykuł!