Codecs behöver inte vara svåra. Nej, det behöver de verkligen inte. Det enda som spelar roll är att du väljer rätt codec.

I slutet av den här artikeln kommer du att kunna välja den bästa codec för dig i varje projekt. Mitt mål är att ge dig det du behöver för att fatta dina egna välgrundade beslut om codecs. Så att du kan välja rätt codec för dig själv, istället för att förlita dig på vad som fungerade för någon annan.

Jag kommer att gå igenom varje steg i processen att göra en video. Klicka på en rubrik för att hoppa till det avsnittet. Jag kommer att ta upp följande:

- Den codec du filmar

- Den codec du redigerar

- Den codec du färgkorrigerar

- Den codec du skickar till VFX

- Den codec du exporterar

- Den codec du arkiverar

I varje steg, förklarar jag vilka faktorer du bör ta hänsyn till när du väljer codec. Jag kommer också att ge dig några exempel på de mest använda codecs för det steget.

Längs vägen kommer vi att ta upp varför både low-end codecs och high-end codecs kan sakta ner din redigering, orsakerna till en proxy/offline-redigering, en genomgång av ett verkligt projekt, några strategier för att spara lagringsutrymme och en förklaring till varför omkodning inte kan förbättra din bildkvalitet.

Fördelarna med att optimera dina codecs kan vara enorma. Välj rätt codec så bevarar du dina bilder i högsta kvalitet. Det kan också göra ditt arbete snabbare och låter dig utnyttja din dator och ditt lagringsutrymme på bästa sätt. Du kommer att kunna arbeta snabbare på en bärbar dator än vad många kan göra på ett högklassigt torn.

Vad en codec gör

En codec är en metod för att göra videofiler mindre, vanligen genom att försiktigt kasta bort data som vi förmodligen inte riktigt behöver. Och de är ganska smarta när det gäller hur de gör det. För några år sedan skapade jag en video som täcker de viktigaste komprimeringsteknikerna som många codecs använder. Det är inget krav för att förstå den här artikeln, men det skadar inte.

Hur codecs fungerar – Tutorial.

Om du hoppar över videon, kommer här några mycket grundläggande förklaringar:

- Chroma subsampling: Slänger bort en del färgdata (4:4:4:4 är ingen chroma-sampling. 4:2:2 är viss kromasampling. 4:2:0 är mycket kromasampling). Dåligt om du gör färgkorrigering. Riktigt dåligt om du arbetar med green screen eller VFX.

- Makroblockering: Hittar block (av varierande storlek) med liknande färger och gör dem alla till samma färg. Dåligt för VFX och färgkorrigering. Nästan alla codecs använder detta i någon grad, och mängden tenderar att variera med bitraten.

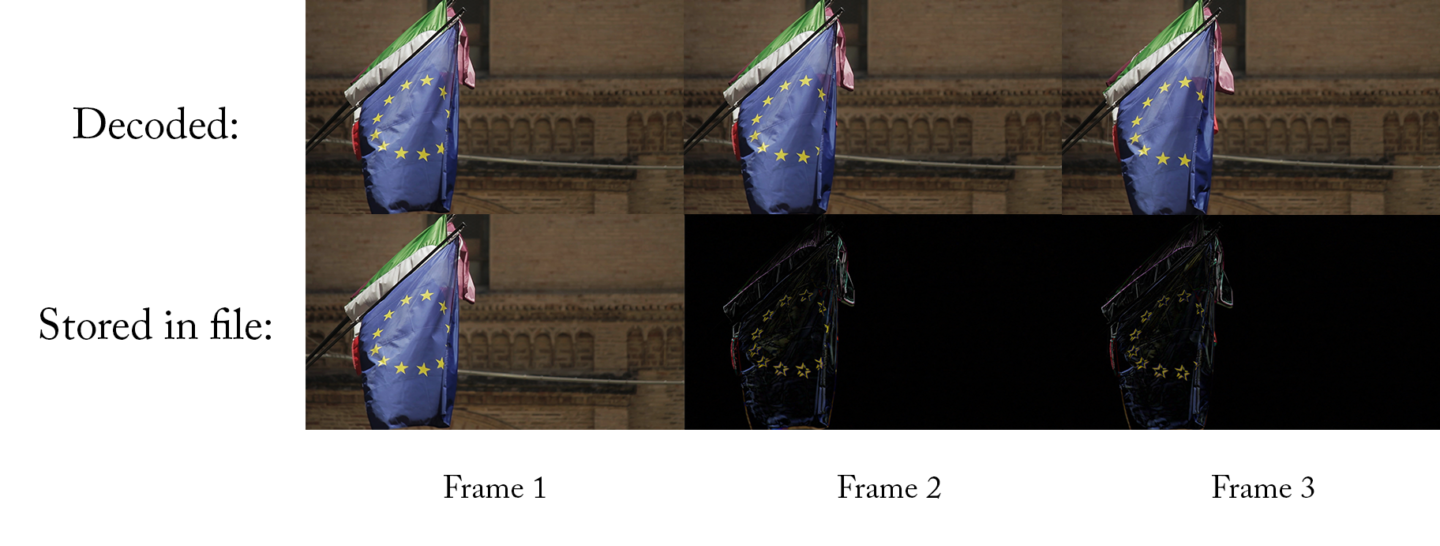

- Temporell komprimering: Använder tidigare ramar (och ibland följande ramar) för att beräkna den aktuella ramen. Dåligt för redigering.

- Bitdjup: Antalet möjliga färger. Djupare bitdjup (större antal) är bra för färgkorrigering och VFX.

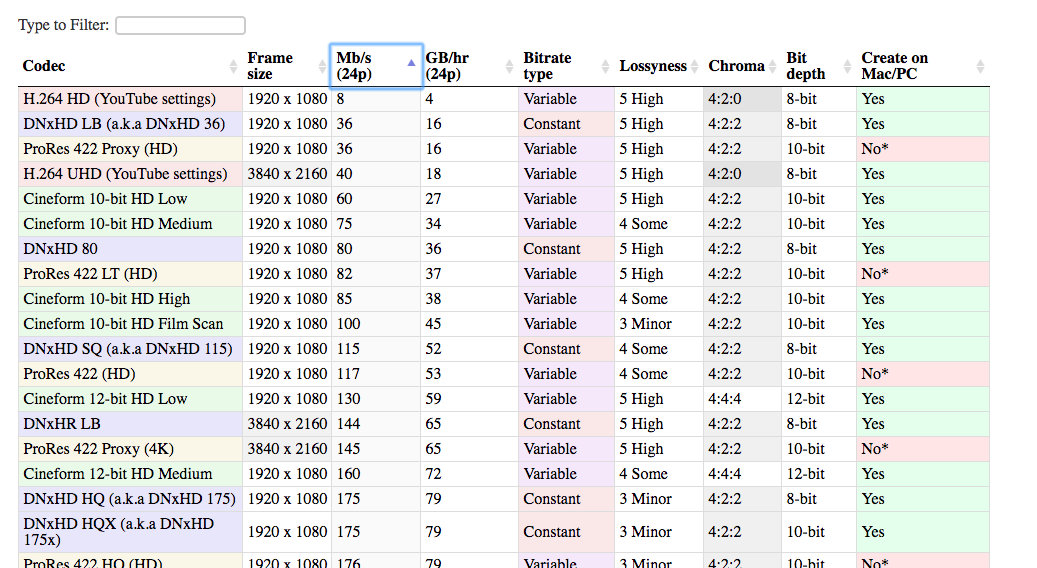

Codec Comparison Table

Jag har också sammanställt en lista över alla de vanligaste codecs som används i postproduktionsvärlden. Den här listan kan hjälpa dig att jämföra olika codecs mot varandra och fatta det bästa beslutet för ditt projekt.

Det finns många olika codecs som kan användas i redigeringsprocessen. De som jag har tagit med är de överlägset vanligaste. Det finns en betydande fördel med att använda populära codecs. Det är mer sannolikt att de fungerar på ditt system, din klients system, ditt system om fem år osv. Och det är lättare att hitta hjälp om något går fel.

Öppna tabellen i en ny flik. På så sätt kan du jämföra codecs medan du läser artikeln.

Kontrollera tabellen

Lossyness

En av kolumnerna i tabellen är ”lossyness”, vilket är ett viktigt begrepp med codecs. När jag talar om lossyness menar jag inte nödvändigtvis vad ditt öga ser. Jag menar den mängd data som behålls av codec:en, varav du bara kan se en del. Frågan är: Om jag hade en okomprimerad bild och sedan komprimerade den med denna codec, hur lik skulle den nya bilden vara den gamla bilden? Hur mycket information går förlorad vid omkodningen? Om de två bilderna är mycket lika varandra är codec:en inte särskilt förlustbringande. Och om de är ganska olika är den mer förlustbringande.

Förlustbringande är en kombination av de tekniker som den specifika codec använder och dess bithastighet. En mer förlustbringande codec är inte nödvändigtvis dåligt. I vissa fall (t.ex. vid visning på nätet) är det verkligen inte nödvändigt att behålla 100 % av originalbilden. Att använda en codec med större förlust kan vara ett riktigt smart drag på grund av hur mycket utrymme det sparar.

Om bilden ser lika bra ut för mitt öga, varför ska jag då bry mig om att den är tekniskt sett ”förlustfylld”?

Du bör bry dig eftersom du kanske vill ändra bilden. Om du gör någon form av färgkorrigering kommer du att ändra bilden. Resultatet kan bli att du ser delar av bilden som inte var synliga (eller framträdande) när du tog den.

Till exempel här är en bild som togs obearbetad.

Här är en skärmdump av den komprimerad med H.264, med standardinställningar som rekommenderas av YouTube.

Och sedan komprimerad med DNxHD 350x:

De ser alla ungefär likadana ut, eller hur? Den visuella kvaliteten är ungefär densamma, och H.264-filen är en bråkdel av storleken på DNxHD-filen. Det är därför det är den rekommenderade inställningen för YouTube. Det ser ungefär lika bra ut för ögat, och filen är mycket lättare att ladda upp till internet.

Problemet med H.264-versionen kommer dock när du försöker göra ändringar i bilden. Vad händer om du vill öka exponeringen?

Nu kan vi se var den högkomprimerade bilden faller samman. Hennes hår och skjorta ser hemskt ut i h.264-bilden, och byggnaderna vid floden ser helt mosiga ut.

Detta är anledningen till att du verkligen vill ha en högkvalitativ codec när du fångar bilden. Eftersom du förmodligen kommer att vilja göra ändringar senare, men du vet ännu inte vad dessa ändringar kan vara. Du kommer att vilja justera färg och kontrast, kanske justera hastigheten, kanske lägga till några VFX. En starkt komprimerad fil tillåter inte dessa ändringar utan att gå sönder.

Det är därför som det är en bra idé att fånga ditt material i 10-bitar även om du kanske kommer att ge ut en 8-bitarfil i slutändan. Du vet inte, när du filmar, vilka bitar du kommer att vilja ha.

The Codec Journey

Nu är det dags att gå igenom de olika stegen som du kommer att stöta på i varje projekt.

Varje projekt börjar med en codec som du fångar i kameran. Och slutar med en codec som du exporterar (leveranscodec) och överlämnar till din klient eller laddar upp på webben. I det enklaste fallet gör du all redigering och färgkorrigering direkt i kamerafilerna. Sedan exporterar du till din leveranscodec, så du använder bara två codecs.

Men för det mesta blir det lite mer komplicerat. Du kanske omkodar till en annan codec för redigering, och eventuellt för färgkorrigering, och definitivt för VFX. Men allt börjar med…

Den codec du filmar med

(tillbaka till indexet)

Det här är din capture codec, (även kallad ”camera native codec” eller ”acquisition codec”).

Generellt sett bör du sträva efter att använda den codec av högsta kvalitet som din kamera (eller din budget) kan fånga. När jag säger ”högsta kvalitet” menar jag att du vill fånga så mycket information som möjligt. Du vill alltså ha mindre förlustbringande codecs: mindre komprimering, högre bitdjup och mindre chroma subsampling. Ju mer information du har när du tar upp, desto mer flexibilitet har du senare. Särskilt vid färgkorrigering och VFX (om du gör det).

Självklart måste du också ta hänsyn till många andra, praktiska faktorer i detta beslut. Annars skulle vi alltid filma 8K raw, eller hur?

Kostnad

Det första övervägandet är naturligtvis kostnaden. Generellt sett gäller att ju dyrare kameran är, desto högre kvalitet på de codecs som finns tillgängliga på den. Jag säger generellt eftersom det finns vissa ”sweet spot”-kameror som kan erbjuda utmärkta codecs till ett rimligt pris. Panasonics GH-serie (särskilt i början när GH2 hackades) var känd för att erbjuda bättre codecs än de andra kamerorna i sin prisklass.

Tip: Bättre codecs med externa inspelare

Ett sätt att fånga codecs av högre kvalitet på billigare kameror är att använda en extern inspelare.

Dessa enheter (av vilka många kan dubbleras som externa monitorer) tar emot en okomprimerad signal från kameran, via HDMI eller SDI, och komprimerar den separat. Du får alltså två kopior av ditt material. En kopia som är kraftigt komprimerad på kameran och en andra kopia som är lätt komprimerad på den externa inspelaren. Det viktigaste här är att kameran skickar ut signalen till inspelaren innan den komprimeras.

En viktig notering här är att många billigare kameror endast matar ut 8-bitar, och ofta inte i 4:4:4:4. En extern inspelare kanske kan komprimera till en 12-bitars codec. Men om kameran bara skickar 8 bitar kan inspelaren bara spela in 8 bitar. Vissa billigare kameror ger kanske inte heller ut en ”ren” HDMI-signal som är lämplig för inspelning. Vi kallar en utgångssignal för ”ren” när det bara är den rena bilden utan överlagring av kameragränssnittet.

Lagring

Den andra faktorn att ta hänsyn till är lagringsutrymme. Högkvalitativa codecs tenderar att ha högre bithastighet, vilket innebär att filerna är större. Du måste vara beredd att lagra och säkerhetskopiera alla dessa filer medan du filmar. Och du kan också behöva uppgradera dina minneskort för att kunna spela in data med hög bithastighet. Om du filmar ensam kan det sluta med att du väljer en codec av lägre kvalitet eftersom det gör att du kan byta minneskort mindre ofta.

Finishing

En annan faktor att ta hänsyn till är hur mycket färgkorrigering och VFX (kollektivt benämnt som efterbehandling) du planerar att göra. Om du kommer att göra mycket minimal färgkorrigering och ingen VFX kan du förmodligen komma undan med lägre bitdjup, chroma subsampling och makroblockering som följer med inspelningscodecs av lägre kvalitet.

Redigering av maskinvara

Den sista faktorn att ta hänsyn till är din redigeringsmaskin. De flesta capture codecs är inte väl lämpade för redigering utan en högpresterande dator. H.264 och vissa råfiler kräver en kraftfull CPU/GPU för att redigeringen ska gå smidigt. Och codecs med mycket hög bithastighet kan kräva höghastighetshårddiskar eller dataservrar. Om du inte filmar med en redigeringsvänlig codec kan du behöva omkoda dina filer till en annan codec innan du redigerar. Detta kan ta tid. För vissa är omkodning av filmmaterialet inte ett stort problem eftersom det kan göras över natten eller på en reservdator. Om du arbetar med mycket korta leveranstider kan du dock välja en codec som gör att du kan börja redigera direkt efter inspelningen, även om det innebär en högre kostnad eller en försämring av bildkvaliteten. Jag förklarar vilka codecs som är bäst för redigering i nästa avsnitt.

Den codec du redigerar med

(tillbaka till index)

Okej, du har spelat in din film och du har alla dina filer på din dator. Nu måste du bestämma dig för om du ska redigera med dessa filer. Eller om du vill omkoda till ett annat format.

Varför ska jag omkoda innan jag redigerar? Kan jag inte bara redigera filerna som kom ut ur kameran?

Ja, det beror på. I stort sett alla större programvarupaket kan nu redigera alla codec som din kamera skapar. (Om du inte är en tuffing som filmar med en helt ny kamera med helt ny teknik). Men även om det nästan alltid är möjligt att redigera de codec-filer som din kamera har filmat är det inte alltid den bästa idén.

Om du har turen att filma med en codec som är utmärkt för redigering kan du hoppa över det här steget.

För många av oss kommer dock inte capture-codec-filen att vara optimerad för redigering. Det finns två huvudfaktorer som du måste ta hänsyn till när du väljer din redigeringscodec: kompressionstyp och bithastighet.

Högkomprimerade codecs kan göra din redigering långsammare

(tillbaka till indexet)

De flesta kameror i lägre och mellanklass spelar in med codecs som använder sig av temporal komprimering, även känd som long-GOP-komprimering. Jag kommer att ge dig en enkel förklaring här, men om du är intresserad av att lära dig mer i detalj kan du kolla in min video om codecs, med början vid 19:00.

Den enkla förklaringen till en long-GOP är att codec:n för varje bild endast fångar det som har ändrats mellan denna bild och den föregående bilden. Om videon inte innehåller mycket rörelse kan den nya filen bli MYCKET mindre. Skillnaden mellan den här bilden och den senaste bilden är bara några få pixlar. Så allt du behöver lagra är några få pixlar. Det är bra!

Altid framåt

Problemet är dock att dessa codecs tenderar att bara fungera bra när de spelas upp framåt. (Om du är nyfiken på varför, ta en titt på videon). Det är bra för visning på YouTube och din DVD-spelare, men det är inte bra för redigering. När du redigerar hoppar du ofta runt eller spelar upp ett klipp baklänges. Och det krävs mycket mer processorkraft för att göra dessa saker snabbt med en long-GOP codec. En högklassig dator kanske inte har några problem, men även en dator i mellanklass kommer att släpa och stamma när du snabbt går igenom materialet eller hoppar runt.

Codecs som inte är long-GOP (intra-frame codecs) kan spela upp baklänges lika lätt som framåt. Så även en dator i mellanklass kan hoppa runt mycket smidigt. Om du bara har redigerat klipp direkt från kameran kanske du inte inser vad du missar!

Den andra saken som kan orsaka problem med uppspelningen är rå video. Rå video måste konverteras innan den kan visas (ungefär som en codec gör). Och vissa datorer kan inte avkoda råfilen tillräckligt snabbt, särskilt om den är 4K. Ironiskt nog producerar både lågpriskameror och högpriskameror filer som är svåra att redigera!

Högbitrate codecs kan sakta ner din redigering

(tillbaka till index)

För låg- och mellanklass codecs behöver du inte alls oroa dig för bithastigheterna. När du börjar röra dig uppåt på stegen kan dock codecs med hög bithastighet orsaka problem med redigeringen, särskilt om du arbetar på vanliga datorer.

Anledningen är att din dator måste kunna läsa data från din hårddisk med en bithastighet som är minst lika hög som din codecs bithastighet. Det är logiskt – om din codec är 50Mb/s (femtio megabit per sekund) måste din dator kunna läsa filen från hårddisken med 50Mb/s, annars kommer den att hamna på efterkälken och stammas.

(Observera att Mb/s står för megabit per sekund, medan MB/s står för megabyte per sekund. Det finns åtta bitar i en byte, så du måste multiplicera med 8 när du konverterar från MB/s till Mb/s)

En del goda nyheter

De goda nyheterna är att hårddiskar blir snabbare för varje dag. Så 50 Mb/s kommer aldrig att orsaka några problem. Men vad händer om du redigerar ProRes 422HQ i 4K, vilket är 734 Mb/s? Den genomsnittliga externa hårddisken är bara knappt tillräckligt snabb för att spela upp det. Vissa billigare hårddiskar klarar det inte alls. Och vad händer om du redigerar en multikamera med tre kameror? Plötsligt behöver du tre gånger så hög datahastighet: 2 202 Mb/s! Då måste du investera i några högpresterande hårddiskar eller RAID:er.

Här är några grova riktlinjer för vanliga datalagringshastigheter. (Det kommer alltid att finnas vissa modeller som underpresterar eller överpresterar.)

- Standardspinndisk: 100-120MB/s

- Professionell spinndisk: 100-120MB/s

- Professionell spinndisk: 150-200MB/s

- Standard SSD: 400-500 MB/s

- Low-end RAID: 200-300 MB/s

- High-end RAID: 1000-2000 MB/s

Skjutning i logg kan göra redigeringen långsammare

Skjutning i logg är ett sätt att bevara så mycket som möjligt av det dynamiska området. Detta möjliggör en scen som har ljusa höjdpunkter och mörka skuggor utan att blåsa ut höjdpunkterna eller krossa svärtan. Utblåsta ljuspunkter är en särskilt obehaglig bieffekt av att fotografera på video i stället för film. Så att fotografera i logg kan hjälpa till att få ditt material att kännas mer filmiskt. Nu när logprofiler finns tillgängliga även på de flesta prosumer-kameror är det ett extremt populärt sätt att arbeta.

Nackdelen

Nackdelen är att bilden som kommer ut ur kameran inte ser så bra ut. Du måste lägga till kontrast och mättnad för att komma ens i närheten av den slutliga bilden. Det vanligaste sättet att göra det är att lägga till en LUT till ditt material. Detta är i huvudsak en enkel förinställd färgkorrigering som ger ditt material ett ”normalt” utseende.

Om du filmar i ett loggfärgutrymme måste du tillämpa en LUT på ditt material för att förhandsgranska det med normal färg och kontrast. Detta innebär att din redigerare måste tillämpa lämplig LUT på alla klipp när du redigerar. Detta kan vara irriterande att hantera och det kan också göra datorn lite långsammare. Detta beror på att den först måste avkoda varje bild och sedan tillämpa LUT:en innan den visas. Det är förvisso möjligt att redigera loggfilmerna utan någon LUT, men det är inte idealiskt. Färgen på två bilder kan påverka hur du klipper ihop dem.

Om du ska omkoda filerna innan du redigerar dem kan du tillämpa LUT:en under omkodningsprocessen. På så sätt arbetar redigeraren alltid med material som har bra kontrast och färg och behöver aldrig bry sig om LUTs. Observera att du endast bör göra detta om du använder ett Proxy-arbetsflöde, inte ett Direct Intermediate-arbetsflöde (beskrivs nedan).

Konsidera den tid som går åt till kodning

Den största nackdelen med att omkoda ditt material före redigering är helt enkelt den tid det tar att göra omkodningen. Om du har mycket material att gå igenom och din dator inte är snabb kan det ta lång tid. Om du inte har så bråttom kan du låta omkodningen köra över natten, eventuellt på flera datorer om du har tillgång till dem, men det är inte alltid idealiskt.

När jag arbetade på Khan Academy spelade vår grundare regelbundet in korta videomeddelanden som han skickade ut till folk. Som ofta hade mycket snäva scheman. Jag brukade vanligtvis filma i 4K i ett långt GOP-loggformat och redigera dem på en MacBook Pro. Att redigera 4K long-GOP med en LUT (för att korrigera för loggfilmen) på en bärbar dator innebar att jag kunde spela upp videon helt okej i Premiere Pro, men jag kunde inte zooma runt på tidslinjen så snabbt som jag ville utan att det stannade.

Men det störde mig inte så mycket eftersom redigeringen var extremt enkel. Bara några klipp, kanske lite musik, en titel och så var jag klar. Även om min redigeringshastighet inte var idealisk skulle jag ha spenderat mer tid på omkodningen än vad jag skulle ha sparat i redigeringshastighet, så jag använde bara originalfilerna.

Om jag skulle redigera ett längre stycke med samma upplägg skulle jag dock omkoda till DNxHD eller ProRes. I allmänhet skulle jag göra det mesta av omkodningen över natten, ofta med flera maskiner igång samtidigt.

Proxy Edit

(tillbaka till index)

Om du ska omkoda de ursprungliga kamerafilerna innan du redigerar dem använder du en ”mellanliggande” codec. Den kallas intermediär eftersom den kommer mellan inspelningscodec och exportcodec. Det finns två vanliga sätt att arbeta med mellanliggande codec:

Det första är ”proxy”-arbetsflödet eller ”offline-redigering”. Det innebär att du omkodar ditt fångade material till ett mellanformat, redigerar med det formatet och sedan återkopplar till de ursprungliga kamerafilerna innan du exporterar. Eftersom du kommer att använda kamerafilerna för att exportera och inte proxyfilerna behöver du inte oroa dig så mycket för att välja en proxycodec med bra bildkvalitet – förlustfyllda codecs är bra. Du kan optimera för redigeringshastighet och lagringsbekvämlighet istället.

Proxyarbetsflödet är så vanligt att många avancerade kameror spelar in en high-end råfil *och* en ProRes- eller DNxHD-proxyfil samtidigt. Efter inspelningen säkerhetskopieras råfilerna och läggs i lager. Proxyfilerna skickas till redaktörerna och till regissören/producenterna för dailies.

Undervik temporal komprimering

När du väljer en proxycodec vill du välja en som inte använder temporal komprimering (även kallad inter-frame-komprimering eller long-GOP-komprimering), och du vill välja en som har en lägre bithastighet. Den låga bithastigheten innebär att filerna är mycket mindre, så du kan använda färre/smalare/billigare hårddiskar, vilket förenklar ditt arbetsflöde. Woot!

Men proxyfilerna är utmärkta för redigering, men du bör inte göra mer än grundläggande färgkorrigering med proxyfiler. Om du ska göra all färgkorrigering i ditt redigeringsprogram är det bäst att återkoppla till kamerafilerna eftersom proxyfilerna kan ha lägre färgkvalitet.

Den goda nyheten är att de flesta redigeringsprogrammen idag kan växla mellan kamerafiler och proxyfiler med bara ett par klick, så du kan till och med gå fram och tillbaka om du behöver det.

Vi har publicerat detaljerade guider för proxyarbetsflöden i alla de större NLE-programmen:

- Final Cut Pro X Proxy Workflows

- Premiere Pro Pro Proxy Workflows

- Avid Media Composer Proxy Workflows

Några bra val av proxy codecs

De överlägset vanligaste proxy codecs är DNxHD/DNxHR och ProRes. De har båda funnits i flera år, så de har mycket brett stöd. Alla vet hur de ska hanteras. De är båda mycket väl lämpade för ett proxyarbetsflöde (ProRes har till och med en förinställning som heter ”proxy”) och är nästan utbytbara när de används för proxys.

DNxHD tillverkas av Avid och ProRes tillverkas av Apple. Så det är logiskt att DNxHD skulle fungera bättre på Media Composer och ProRes skulle fungera bättre på Final Cut Pro X. Det brukade säkert vara sant, men numera fungerar båda codecs mycket smidigt på alla moderna redigerare (inklusive Premiere Pro). Det kan finnas en liten hastighetsökning genom att använda den codec som är utformad för systemet, men den är mycket liten.

Den enda betydande skillnaden mellan de två för ett proxyarbetsflöde är det faktum att du kan ha problem med att skapa ProRes på en PC, medan DNxHD är mycket lätt att skapa plattformsoberoende. Det enda officiellt stödda sättet att skapa ProRes på en PC är med Assimilate Scratch. Det finns några andra icke-stödda metoder för att skapa ProRes-filer på en dator, men de är inte alltid tillförlitliga. Datorer kan enkelt spela upp och redigera ProRes-filer, men du kan inte koda nya ProRes-filer på en dator lika enkelt som DNxHD, och därför föredrar vissa redigerare ett DNxHD-arbetsflöde av den anledningen.

Välj en bana

Oavsett vilken av de två codecs du väljer, måste du också välja vilken smak du vill ha. Detta kommer verkligen att bero på dina lagringsbegränsningar – det är en avvägning mellan bildkvalitet och filstorlek. Den goda nyheten är att du inte behöver toppkvalitet när du redigerar, så du kan välja en codec med låg bithastighet.

Start med den minsta ProRes- eller DNx-codec i samma upplösning som din capture-codec. Titta på kolumnen GB/timme och multiplicera den med antalet timmars filmmaterial du har. Om du har tillräckligt med lagringsutrymme är det bra – använd denna codec. Om du har mycket extra lagringsutrymme, tänk på att använda den näst största smaken.

Men om du inte har tillräckligt med lagringsutrymme, eller om du har en maskin med för lite kraft, så ta ner upplösningen ett snäpp. Många Hollywoodfilmer med enorma budgetar redigerades i 480p för bara några år sedan, så du behöver inte oroa dig om du måste sänka upplösningen från 4K ner till 720P för redigeringen.

Direct Intermediate

Den andra typen av mellanliggande arbetsflöde är något som jag kallar Direct Intermediate. Det innebär att du omkodar dina kamerafiler till en codec som både är bra för redigering och mycket högkvalitativ (inte särskilt förlustbringande). Eftersom codecen är mycket högkvalitativ har nästan all originalinformation från kamerafilerna bevarats, och därför är det inte nödvändigt att återkoppla till kamerafilerna – du kan bara exportera direkt från de mellanliggande filerna. Det blir en viss teoretisk förlust av information när du transkodar, men om du väljer en tillräckligt bra mellanliggande codec är den tillräckligt liten för att du inte behöver oroa dig för den.

(Obs: Jag kallar den här processen för ”Direct Intermediate” eftersom det inte finns något vanligt namn för det här arbetsflödet. Folk brukar bara kalla det ”mellanliggande”, men det kan vara förvirrande eftersom proxyarbetsflöden också är ett slags mellanliggande arbetsflöde. Vissa kallar också detta för ett ”online”-arbetsflöde, men det är också förvirrande eftersom den termen skapades för att beskriva ett arbetsflöde som inkluderar en offline- och en onlineredigering, inte ett arbetsflöde som är online från början till slut.)

Bevarande är nyckeln

Nyckeln till att välja en bra Direct Intermediate codec är att se till att du bevarar all information från din capture codec. En mellanliggande codec kommer aldrig att göra dina bilder bättre (mer detaljerad förklaring nedan), men den kan definitivt göra dem sämre om du väljer fel codec. Det viktiga är att förstå detaljerna i ditt originalmaterial och se till att din intermediate codec är minst lika bra som din capture codec på varje område. Om du fångar ditt material med en DSLR som en Sony A7Sii i 4K kommer du att spela in i en 4:2:0, 8-bitars, Long-GOP codec med 100 Mbps. Du vill ha en mellanliggande codec som är minst 4:2:0 och 8-bitars. Att gå över dessa värden (t.ex. till 4:4:4:4 och 12-bitars) skadar inte, men hjälper heller inte alls. Så det är förmodligen inte värt det extra lagringsutrymmet.

Vi kan till exempel säga att vi vill använda en ProRes codec. Vi har 4 alternativ att välja mellan som är 4:2:2 och 10-bitars.

- 145Mb/s ProRes 422 Proxy

- 328Mb/s ProRes 422 LT

- 471Mb/s ProRes 422

- 707Mb/s ProRes 422 HQ

Over och över

Du kanske tror att allt du behöver är att matcha kamerans bitrate (100 Mbps), men i själva verket måste du överskrida kamerans bithastighet avsevärt. Detta beror på att h.264 är en mycket effektivare codec än ProRes. Eftersom h.264 använder long-GOP-komprimering kan den packa in mycket mer information i dessa 100 megabit än vad ProRes kan. För att ProRes ska kunna matcha bildkvaliteten hos h.264 krävs en mycket högre bithastighet. Jag skulle rekommendera att endast använda ProRes 422 eller ProRes 422 HQ om du börjar med en 100 Mbps h.264-codec. ProRes 422 kommer förmodligen att räcka, men om du har mycket lagringsutrymme har du en liten fördel om du går upp till ProRes 422 HQ.

Som det går bra att helt enkelt matcha bitdjup och färgsampling när du väljer en intermediate, bör du alltid öka bitraten åtminstone lite. Om du går från long-GOP till en codec utan long-GOP bör du öka bitraten mycket.

Notis vid sidan av: Om du vill välja DNxHD i stället för ProRes har du liknande alternativ, förutom att DNxHD också erbjuder en 8-bitarsversion för de lägre codecs. Eftersom vårt material är 8-bitars till att börja med kommer det inte att skada oss alls.

Proxyarbetsflödet lät ganska bra. Varför göra Direct Intermediate?

En del av anledningen till att Direct Intermediate-arbetsflödet är vanligt är att det förr var mycket svårare att använda ett proxy-arbetsflöde. Några av de stora programvaruleverantörerna gjorde det inte särskilt lätt att återkoppla till de ursprungliga kamerafilerna, och därför valde folk ett direkt mellanliggande arbetsflöde. Numera är det dock ganska lätt att göra det i vilket redigeringspaket som helst. Det viktigaste undantaget är när du har många blandade filmtyper. Om du har flera olika bildfrekvenser och bildstorlekar i samma projekt kan det vara en huvudvärk att växla fram och tillbaka från proxys till inspelningscodecs.

Om du använder några verktyg från tredje part för att hjälpa till med att förbereda och organisera ditt material innan du börjar klippa, kan de också göra återlänkningsprocessen mer komplicerad. Ett vanligt exempel kan vara programvara som automatiskt synkroniserar ljudspår eller multikam-upptagningar.

Ingen byte krävs

En annan anledning till att du kanske vill använda ett Direct Intermediate-arbetsflöde är att du kan gå direkt vidare till färgkorrigering och VFX-processen (”efterbehandling”) utan att byta runt några filer. Fortsätt läsa, så förklarar jag mer om varför det är praktiskt i avsnitten om färgkorrigering och VFX.

En nackdel är dock att du inte kan ”baka in” LUT:erna för din redigerare – du måste tillämpa en LUT via en färgkorrigeringseffekt i ditt redigeringsprogram. Om du skulle inkludera LUT i ditt arbetsflöde för omkodning för Direct Intermediate skulle du förlora alla fördelar med att spela in i logg från början.

Den andra uppenbara nackdelen är att du måste lagra alla dessa (mycket större) filer.

En intermediate codec kommer aldrig att göra dina bilder bättre

(tillbaka till index)

Detta är mycket viktigt, eftersom det är mycket vanligt att det missförstås, och det finns mycket felaktig information på nätet. Omkodning av ditt material innan du redigerar kommer aldrig att öka kvaliteten på resultatet. Det finns några extra operationer som du kan göra i omkodningsprocessen (t.ex. genom att använda sofistikerade upplösningsverktyg) som kan öka bildkvaliteten i vissa fall, men en ny codec i sig kommer aldrig att öka bildkvaliteten.

Om du väljer rätt codec kan du undvika att skada bilden, men du kan aldrig förbättra den.

Det gäller även om du går från h.264 till DNxHD eller ProRes. Det inkluderar också att gå från 8-bitars till 10-bitars. Och att gå från 4:2:0 till 4:4:4:4.

Här är en illustration som kan hjälpa dig att förstå detta koncept:

Detta är ett foto av en ros som reflekteras i en vattendroppe. Det är 4 megapixel och ser ganska bra ut på min 27-tums bildskärm.

Tänk om jag nu tar ett foto av min bildskärm med en Red Helium 8k-kamera. Det här är ett odjur av en kamera. Jag tog fotot av rosen för några år sedan med en billig Canon Rebel DSLR, värd ungefär 250 dollar i dag. Red Helium-uppsättningen kostar ungefär 50 000 dollar, den har 35 megapixlar, den är rå, den har en av de bästa kamerasensorerna som någonsin tillverkats.

Vilket blir en bättre bild – fotot med 4 megapixlar eller fotot med 35 megapixlar?

En bild av en bild

Den röda kameran har fler megapixlar, eller hur? Den är obearbetad och har all digital magi från Red, eller hur? Men eftersom jag använder min högupplösta kamera för att ta ett foto av fotot, inte ett foto av rosen, kommer min nya fina bild aldrig att bli bättre än den första. Jag har en fil som tekniskt sett har högre upplösning, men den fångar inte mer av mitt motiv (rosen) än vad den första gjorde.

Detta är vad du gör när du omkodar. Du gör en kopia av en kopia, du tar ett foto av ett foto. Om du använder en snygg högupplöst kamera för att ta ett foto av ett foto kommer du att kunna bevara i stort sett all information i originalbilden, men du kommer inte att kunna lägga till något mer.

Den stora invändningen är att om du gör någon bearbetning, någon omvandling av bilden (till exempel lägger till en LUT), så vill du definitivt omkoda till en codec av högre kvalitet, som kommer att behålla ny information. Men om du inte ändrar bilden kommer omkodningen inte att göra bilden ”bättre”.”

Ett exempel från den verkliga världen

(tillbaka till indexet)

Då säger vi att du redigerar en dokumentärfilm som har spelats in med 4K-material med en Sony A7sii-kamera, som spelar in i den långa GOP-versionen av XAVC-S. Inte perfekt för redigering. Om de spelade in 40 timmars material för din långa dokumentärfilm skulle du få ungefär 2,7 TB kamerafiler, som lätt ryms på en hårddisk (även om du har gjort andra separata säkerhetskopior, förstås!).

Du skulle kunna konvertera det till en högkvalitativ codec utan förlust för ett Direct Intermediate-arbetsflöde, kanske ProRes 422 HQ i 4K.

Nackdelen är att du skulle behöva cirka 12,7 TB för att lagra alla dessa ProRes-filer. Du skulle behöva använda en dyr RAID-installation för att ha enkel tillgång till allt detta material i ett projekt, minst 1 000 dollar. Det är en liten summa för en stor anläggning, men en betydande investering för en ensam redaktör.

Välja proxy

Så du kanske bestämmer dig för att använda ett Proxy-arbetsflöde i stället och transkoda dina filer till ProRes 422 Proxy 4K-formatet. Då skulle ditt filmmaterial bara ta upp 2,8 TB, vilket är knappt mer än ditt fångade filmmaterial. Du kan då enkelt redigera från en enda hårddisk och ditt arbetsflöde blir mycket enklare. (För instruktioner om hur du beräknar bithastigheter och filstorlekar kan du läsa den här artikeln:

Vad sägs om att du arbetar med en annan redigerare som befinner sig på andra sidan landet? Du kanske bestämmer dig för att transkoda materialet ännu längre ner till ProRes 422 Proxy HD, vilket skulle krympa ditt material ner till bara 640 GB, vilket blir mer genomförbart att skicka över Internet om du har en snabb anslutning. (18 timmar att ladda ner på en 80 Mbps-anslutning)

När redigeringen är klar är det bara att återkoppla projektet till de ursprungliga kamerafilerna och exportera. Även om du och din fjärrredigerare har arbetat i en ganska förlustbringande codec, går den slutliga exporten förbi den, så du förlorar ingen kvalitet.

Den codec du färgkorrigerar

(tillbaka till indexet)

Okej, nu har du fått din video redigerad, och det är dags för färgkorrigering. Allt vi talar om här gäller oavsett om du färgkorrigerar i ditt redigeringsprogram eller om du skickar din redigering till en särskild färgkorrigeringsprogramvara.

Den stora frågan vid det här laget är om du vill färgkorrigera direkt på de ursprungliga kamerafilerna eller om du vill transkoda. Om du gjorde en proxy/offline-redigering vill du definitivt inte färgkorrigera proxyfilerna, eftersom de har lägre bildkvalitet. För att kunna fatta bra beslut om färg behöver du en bild av högsta kvalitet som du har tillgänglig, eftersom du måste kunna se exakt vad du har att arbeta med.

Så vi måste arbeta med högkvalitativa bilder, och vi har några olika alternativ:

A. Gradera kamerafilerna

Detta är förvisso ett enkelt alternativ. Om du har gjort en proxyredigering kan du återkoppla till kamerafilerna för efterbehandlingsprocessen och gå på högvarv. Detta ger dig maximal bildkvalitet, men minns du hur kamerafiler kan vara långsamma att arbeta med? Kamerafilerna kan göra processen lite långsammare, men beroende på vilken programvara du använder och hur mycket arbete du behöver göra, kanske du bestämmer dig för att enkelheten är värd lite av den potentiella långsamheten. Om du har en kort redigering utan mycket komplexitet kan detta vara ett bra och enkelt arbetsflöde.

Låt oss anta att färgkorrigeringens långsamhet stör dig, så du behöver en codec som är lättare att arbeta med. Du kan omkoda allt ditt material till en codec med hög bildkvalitet, länka till dessa filer och sedan börja göra din färgkorrigering. Men… det är väl lite av ett sätt att motverka syftet med ett proxyarbetsflöde, eller hur? Vi använde proxys eftersom vi inte ville hantera de stora filer som det skulle skapa. Lyckligtvis finns det ett annat alternativ.

B. Konsolidera och transkoda

(tillbaka till index)

Om du använde ett proxy/offline-arbetsflöde för redigeringen men inte vill färgkorrigera kamerafilerna är ett bra alternativ att återknyta till kamerafilerna, konsolidera ditt projekt och sedan transkoda till en högkvalitativ codec.

När du konsoliderar ett projekt gör redigeringsprogrammet en kopia av projektet tillsammans med en kopia av medierna, men bara de specifika filer som du till slut använde i din sekvens. Så om du tog 7 tagningar men bara använde en av dem i redigeringen kopierar programmet bara den ena tagningen. Detta minskar lagringsutrymmet avsevärt, vilket är praktiskt i det här skedet. Du kan också konsolidera ännu mer så att du bara behåller de specifika delar av varje tagning som du faktiskt använde i redigeringen och kastar resten. I det här fallet inkluderar programvaran vanligtvis några sekunder före och efter varje tagning (så kallade ”handles”), ifall du vill lägga till en fade eller motion tracking.

Start your grade

Nu kan du ta detta nya konsoliderade projekt (efter att ha länkat om till originalen) och omkoda alla dessa filer till en codec av mycket hög kvalitet med hög bithastighet, och börja färgkorrigera. Detta skiljer sig från Direct Intermediate-arbetsflödet eftersom du inte omkodar allt material – bara det material som kom med i den slutliga redigeringen, vilket kan vara 1/20:e eller 1/50:e av längden på det material du ursprungligen filmade. Nu låter det inte så illa att omkoda till en codec med hög bithastighet eftersom du inte behöver lagra så mycket av det. Även vid ProRes 4444 4K kommer en långfilm i full längd bara att vara cirka 2 TB – ganska hanterbart.

Nu kan du slutföra din film med bilder av högsta kvalitet och snabb bearbetning, på en hårddisk som ryms i fickan. Woot!

C. Fortsätt med Direct Intermediate

Det tredje alternativet är att fortsätta med Direct Intermediate-redigeringsarbetsflödet, och i så fall är du redo att gå vidare. Du har redan transkodat alla dina filer till en högkvalitativ codec innan du började redigera, så du kan bara fortsätta med samma filer för färgkorrigering. Det är också praktiskt eftersom dessa filer är bra både för redigering och för färgkorrigering och VFX (se nedan).

Om du lämnar över projektet till en extern färgsättare eller VFX-person kan du antingen ge dem allt ditt högkvalitativa filmmaterial (potentiellt irriterande på grund av storleken), eller så kan du använda samma konsolideringstips som vi använde ovan. Att lämna över det konsoliderade projektet kan hjälpa dig att gå snabbare fram och spara tid åt din kolorist också.

En annan fördel

Förutom enkelheten i Direct Intermediate-arbetsflödet (du använder bara en uppsättning filer) har du en annan fördel: det är enklare att gå fram och tillbaka mellan redigering och färgkorrigering.

Föreställ dig att du är klar med din proxyredigering – du konsoliderar och omkodar, skickar den till din kolorist och bestämmer dig sedan för att du behöver göra några ändringar i redigeringen. Nu måste du gå tillbaka till proxyerna för att göra redigeringen och sedan konsolidera och skicka materialet på nytt. Det kan bli ganska rörigt. I ett högklassigt arbetsflöde för efterproduktion finns det vanligtvis ett ”lås” på redigeringen så att efterbehandlingsprocesserna kan påbörjas. Detta innebär att du (om inte dåliga saker händer) kommer att anstränga dig mycket hårt för att inte gå tillbaka och göra ändringar i redigeringen. Men hey, dåliga saker händer, så det är bäst att vara förberedd.

Och nu hittar vi ytterligare en bra anledning till en Direct Intermediate-redigering. Om du ska göra en del av ditt färgarbete och ditt redigeringsarbete samtidigt, eller åtminstone ska gå fram och tillbaka ett par gånger, kan det vara enklare att använda en codec för båda. Detta är särskilt praktiskt om du gör din redigering och efterbehandling i samma programpaket (eller uppsättning paket, t.ex. Creative Cloud).

Den codec du skickar till VFX

(tillbaka till indexet)

Om du gör något VFX-arbete kommer du förmodligen att behöva skicka filer till ett annat program (potentiellt en annan maskin, för en annan konstnär). Om du gör allt ditt VFX-arbete i din editor (vilket blir mer och mer gångbart för enkla jobb) kan du hoppa över det här avsnittet. Använd bara samma codec som du använde för din färgkorrigering.

För de flesta av oss måste vi dock sätta upp en ”round-trip”-process som skickar klipp från redigeraren till VFX-programmet och sedan tillbaka igen när de är färdiga. Detta sker skott för skott, så du skickar inte hela sekvensen till VFX, som du förmodligen gjorde för färggradering. Frågan om när i processen du skickar dina tagningar till VFX beror mycket på det specifika arbetsflödet.

Vissa personer skickar till VFX efter att redigeringen är låst och färgkorrigeringen klar, men tidspress kan tvinga dig att börja skicka tagningar innan dess.

Om du redigerar i Premiere Pro och gör milda VFX i After Effects med Dynamic Link kan du också hoppa över detta avsnitt. Dynamic Link sköter automatiskt rundgångsarbetet åt dig. Om du gör mycket VFX-arbete kanske du ändå vill använda teknikerna i det här avsnittet, eftersom Dynamic Link kan bli lite finurlig med för många projekt. Adobe arbetar dock alltid på dessa buggar, så det är delvis upp till personlig smak.

Go big or go home

I VFX-processen tenderar du att använda mycket avancerade (hög bitrate) codecs av två huvudsakliga skäl. Det första är helt enkelt att VFX-artisterna behöver all information som du kan ge dem för att kunna göra sitt jobb bra. VFX-artister är några av de mest kräsna när det gäller codecs, och det är av goda skäl. Alla vill ha högkvalitativa bilder, men bildproblem kan ofta utgöra ett större problem för VFX än för redigering, färgkorrigering och slutlig export.

Många uppgifter inom VFX-arbetet kräver en mycket detaljerad analys av bilden pixel för pixel, vilket de flesta redigerare aldrig behöver göra. Om du till exempel gör en extraktion av en grönskärm vill du att kanten mellan din karaktär och grönskärmen ska vara så ren som möjligt. Vi har alla sett hemska greenscreenbilder där karaktärens kanter är hackade eller suddiga. Dessa problem uppstår ofta på grund av bildkomprimeringsartefakter som är osynliga för blotta ögat. 4:2:2:2 eller 4:2:0 färgunderfördelning, till exempel, har nästan ingen synlig inverkan på bilden. Det mänskliga ögat bryr sig främst om kontrast och lägger sällan märke till en låg färdupplösning, men grönskärmsextraktionsprocessen förlitar sig främst på färgvärden. Om codecen har kastat bort en stor del av färgvärdena genom att använda 4:2:0 chroma subsampling kan en bra färgnyckel vara omöjlig.

Generationsförlust

Den andra anledningen till att du vill använda avancerade codecs är på grund av generationsförlust. I VFX-processen måste du förmodligen komprimera filen flera gånger. Du kommer att komprimera filen en gång när du skickar den till dem. Och sedan, om de behöver skicka filen vidare mellan flera specialister, kan det hända att de komprimerar filen två eller tre gånger innan de skickar tillbaka den. När en fil komprimeras flera gånger kallar vi det för multipel generationsförlust.

Om du använder en low-end codec blir bilden gradvis sämre varje gång du komprimerar den på nytt. En av de fantastiska sakerna med de riktigt högkvalitativa codecs är att du kan komprimera dem ett par gånger utan att förlora mycket kvalitet. Det är alltid bättre att undvika att komprimera en video flera gånger, men om du använder mycket högkvalitativa codecs går det oftast ganska bra.

En del avancerade VFX-arbetsflöden använder endast förlustfri komprimering av den här anledningen. Den goda nyheten är att dina VFX-inspelningar vanligtvis bara är några sekunder per klipp, vilket innebär att dina filstorlekar kommer att vara små även med avancerade codecs. Så satsa stort! Om du tog 4:4:4:4 i kameran ska du definitivt skicka 4:4:4:4 till VFX. Annars skulle jag välja en 4:2:2:2-codec av högsta klass (ProRes 422 HQ eller DNxHQX).

Och naturligtvis bör du alltid kommunicera i förväg med VFX om vilken codec du ska skicka. Om du tycker att de gör ett dåligt val, skicka dem den här artikeln 🙂

Den codec du exporterar

(tillbaka till index)

Nu är du klar med redigeringen, färgen och VFX – du är redo att exportera. Du gör vanligtvis den slutliga exporten från den programvara som du använde för färgkorrigeringen, med hjälp av den codec som du använde i färgkorrigeringsprocessen.

Om din kund är verksam inom mediebranschen bör de veta vilken codec de vill ha, så du kan hoppa över resten av det här avsnittet!

Om din kund inte är videoexpert vet de kanske inte vad de vill ha, så du måste fatta vissa beslut åt dem. Oftast vill din kund ha en video att ladda upp till YouTube och/eller andra sociala medier. Du kanske frestas att välja en codec som är bra för streaming på Internet. Men du skulle göra fel!

Anledningen till det: dessa webbplatser streamar inte samma fil som du laddar upp till dina tittare – de komprimerar filen *en gång till* innan de streamar den, och du har absolut ingen kontroll över de inställningar som de använder. Detta innebär att om du laddar upp en codec av låg kvalitet så har vi det scenario där vi tar ett foto av låg kvalitet av ett foto av låg kvalitet som vi pratade om. Dåligt! Undvik!

Syftar på bästa kvalitet

Som allmän regel gäller att om du vill ha ett resultat av bästa kvalitet ska du ladda upp en källa av bästa kvalitet. De kommer ändå att komprimera igen, så att ge dem mer data att arbeta med kan inte skada, eller hur? Om du har en tillräckligt snabb anslutning kan du ladda upp en ProRes 422. Vissa personer har rapporterat något (endast något) bättre resultat när de laddar upp ProRes istället för den rekommenderade h.264.

Om du levererar en fil till en klient, för att de ska ladda upp den till Youtube, så skulle jag inte ge dem ProRes, eftersom du inte vet vilken typ av bandbredd de kommer att ha. Lyckligtvis tenderar dessa webbplatser att publicera rekommenderade uppladdningsspecifikationer (det är bara att googla det). Personligen tar jag den bithastighet som de rekommenderar och multiplicerar den med ungefär 1,5x till 2x.

Din kund kanske också vill ha en fil som de kan bädda in direkt på sin webbplats (även om jag skulle avråda dem, om du kan). Generellt sett vill du ha en mycket kraftigt komprimerad h.264. Om du är nyfiken på vad som är en bra bithastighet är mitt resonemang att om någon vet vad den bästa bithastigheten är så är det YouTube. Jag laddar regelbundet ner en video från YouTube och kontrollerar bitraten, och använder den som riktmärke.

Gå smått

Om videon inte är offentlig kanske de också vill ha en liten fil som de kan mejla eller länka direkt till sina egna klienter så att de kan ladda ner den. I dessa fall kan det vara lämpligt att leverera mer än två separata filer, särskilt om det är en lång video. Filen som de ska ladda upp till YouTube kommer att vara för stor för att skickas via e-post på ett bekvämt sätt. I det här fallet brukar jag vanligtvis nedresa filen och komprimera den mycket kraftigt. Du måste också vara realistisk och avgöra om du tror att din kund faktiskt kommer att förstå skillnaden mellan de två filerna.

Om jag behöver leverera mer än en fil brukar jag kalla en av dem för ”HD” i filnamnet och den andra för ”liten” eller ”inte HD” i filnamnet. Om du försöker beskriva de olika codecs för dem kan jag nästan garantera att de kommer att ha glömt skillnaden till nästa vecka, men de kommer förmodligen ihåg vad HD och ”not HD” betyder.

The Codec You Archive

(tillbaka till index)

Du har levererat filen/filerna till din kund, så nu kan du luta dig tillbaka och slappna av… nästan.

Som alla som arbetar professionellt i den här branschen vet, så är den dag då du levererar den färdiga produkten till din kund ofta inte den sista gången du rör ett projekt. Ibland vill en kund gå tillbaka och ändra något veckor senare, eller så vill de ha en codec av högre kvalitet, eller så vill du kanske lägga till det till din personliga filmrulle. I alla dessa fall kan du ha gått vidare till en annan maskin eller en annan programvara, vilket gör det till en huvudvärk att öppna det ursprungliga projektet och exportera det på nytt.

Det är praktiskt

Det är här det är praktiskt att ha ett bra arkiv av det färdiga projektet i en extremt högkvalitativ codec. Om din kund begärde en mycket högkvalitativ codec för leverans är du i allmänhet klar. Behåll bara en kopia av den filen, så är du nöjd. Om de vill ha en codec för leverans som inte är av högsta kvalitet är det dock alltid bra att göra din egen export med en codec som är förlustfri eller så nära förlustfri som du har råd med, med tanke på det utrymme den kommer att ta. Jag exporterar vanligtvis till en 4:4:4:4 codec med mycket hög bithastighet – antingen DNxHD/HR eller ProRes.

Har du frågor? Kommentera gärna.

Jag läser faktiskt alla kommentarer. Den här artikeln är ett pågående arbete och jag kommer att uppdatera den med fler förklaringar och exempel baserat på din feedback. Om du har några privata kommentarer eller frågor kan du skicka ett mejl till mig: david at frame dot io.

Vill du skriva för Frame.io-bloggen? Mejla mig: blog at frame dot io.

Mycket tack till Larry Jordan, Shane Ross och Philip Hodgetts för deras bidrag till den här artikeln!