Codecs não precisam ser difíceis. Não, na verdade, não precisam. O que importa é que você escolha o codec certo.

No final deste artigo, você poderá escolher o melhor codec para você em cada projeto. Meu objetivo é lhe dar o que você precisa para tomar suas próprias decisões informadas sobre os codecs. Assim você pode escolher o codec certo para você, em vez de confiar no que funcionou para outra pessoa.

Eu vou acompanhá-lo em cada passo no processo de fazer um vídeo. Clique em um cabeçalho para saltar para essa seção. Eu vou cobrir:

>

- O codec que gravar

- O codec que editar

- O codec que corrigir cor

- O codec que enviar para VFX

- O codec que exportar

- O codec que arquivar

Em cada etapa, Explicarei quais os fatores que você deve considerar ao escolher um codec. Também vou dar alguns exemplos dos codecs mais utilizados para essa etapa.

Durante o caminho, vamos cobrir porque os codecs low-end e high-end podem, cada um deles, atrasar a sua edição, as razões para uma edição proxy/offline, um passeio pelo mundo real do projeto, algumas estratégias de economia de armazenamento, e uma explicação para porque a transcodificação não pode melhorar a sua qualidade de imagem.

Os benefícios de otimizar seus codecs podem ser enormes. Escolha o codec certo e você irá preservar suas imagens com a mais alta qualidade. Ele também pode tornar o seu trabalho mais rápido, e permite que você tire o melhor proveito do seu computador e armazenamento. Você será capaz de trabalhar mais rápido em um laptop do que muitos podem em uma torre high-end.

O que um codec faz

Um codec é um método para fazer arquivos de vídeo menores, geralmente jogando cuidadosamente fora os dados que provavelmente não precisamos. E eles são bastante inteligentes sobre como fazem isso. Alguns anos atrás, eu criei um vídeo que cobre as principais técnicas de compressão que muitos codecs usam. Não é necessário ver para entender este artigo, mas certamente não vai doer.

Como funcionam os codecs – Tutorial.

Se você está pulando o vídeo, aqui estão algumas explicações muito básicas:

- Subamostragem de Chroma: Deita fora alguns dados de cor (4:4:4 não é uma amostragem de croma. 4:2:2 é alguma subamostragem de croma.4:2:0 é muita subamostragem de croma). Mau se você estiver fazendo correção de cor. Muito ruim se você estiver fazendo trabalho de tela verde ou VFX.

- Macro-Blocking: Encontra blocos (tamanho variável) de cores semelhantes e torna-os todos da mesma cor. Ruim para VFX e correção de cor. Quase todos os codecs usam isso em algum grau, e a quantidade tende a variar com o bitrate.

- Compressão temporal: Utiliza quadros anteriores (e às vezes quadros seguintes) para calcular o quadro atual. Mau para edição.

- Profundidade de bits: O número de cores possíveis. Profundidade de bits mais profunda (números maiores) é bom para correção de cores e VFX.

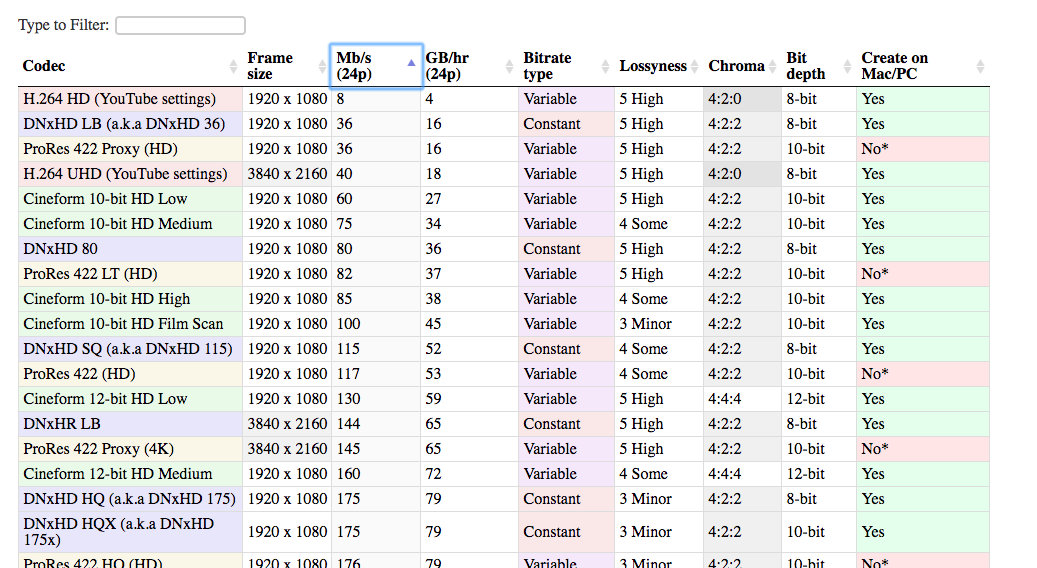

Tabela de comparação de codecs

Eu também reuni uma lista de todos os codecs mais comuns usados no mundo da pós-produção. Esta lista pode ajudá-lo a comparar diferentes codecs uns com os outros e tomar a melhor decisão para o seu projeto.

Há muitos codecs diferentes que podem ser usados no processo de edição. Os que eu incluí são de longe os mais comuns. Há uma vantagem significativa em utilizar os codecs populares. É mais provável que eles funcionem no seu sistema, no sistema do seu cliente, no seu sistema em cinco anos, etc. E é mais fácil encontrar ajuda se algo correr mal.

Abra a tabela numa nova aba. Assim você pode comparar os codecs conforme lê no artigo.

Cheque a tabela

Lossyness

Uma das colunas da tabela é “lossyness”, que é um conceito importante com os codecs. Quando estou a falar de “lossyness”, não me refiro necessariamente ao que o seu olho vê. Refiro-me à quantidade de dados que é retida pelo codec, apenas alguns dos quais você pode ver. A questão é: se eu tivesse uma imagem não comprimida, e depois a comprimisse com este codec, quão semelhante seria a nova imagem com a imagem antiga? Quanta informação é perdida na transcodificação? Se as duas imagens são muito parecidas, então o codec não é muito perdido. E se forem bem diferentes, então é mais perdida.

A perda é uma combinação das técnicas que o codec em particular usa e sua taxa de bits. Um codec mais com perdas não é necessariamente mau. Em alguns casos (ao visualizar online, por exemplo), não é realmente necessário reter 100% da imagem original. Usar um codec com mais perdas pode ser uma jogada muito inteligente por causa de quanto espaço ele economiza.

Se a imagem parece tão boa aos meus olhos, então por que eu deveria me importar se ela é tecnicamente ‘com perdas’?

Você deveria se importar porque você pode querer mudar a imagem. Se você estiver fazendo qualquer tipo de correção de cor, então você estará mudando a imagem. O resultado pode ser que você veja elementos da imagem que não estavam visíveis (ou proeminentes) quando você a captou.

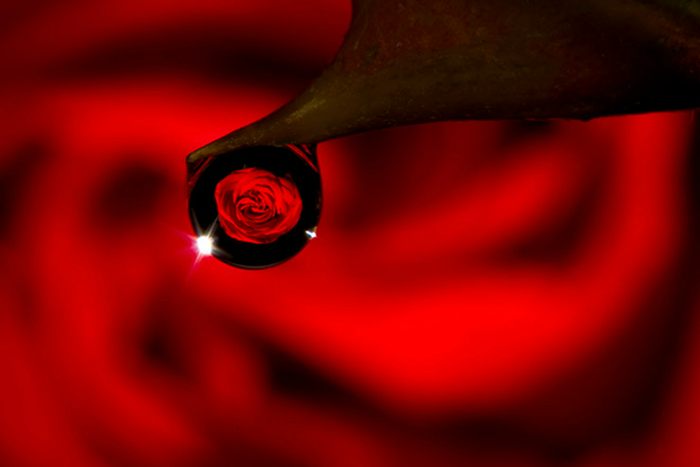

Por exemplo, aqui está uma imagem que foi capturada raw.

Aqui está um screengrab dela comprimido com H.264, usando uma configuração padrão recomendada pelo YouTube-.

E depois comprimida com DNxHD 350x:

>Todos têm o mesmo aspecto, não têm? A qualidade visual é praticamente a mesma, e o arquivo H.264 é uma fração do tamanho do arquivo DNxHD. É por isso que é a configuração recomendada para o YouTube. Parece tão bom aos olhos, e o ficheiro é muito mais fácil de carregar para a internet.

O problema com a versão H.264, no entanto, surge quando se tenta fazer alterações na imagem. E se você quisesse aumentar a exposição?

>

Agora podemos ver onde a imagem altamente comprimida se desfaz. O seu cabelo e camisa ficam horríveis na imagem h.264, e os edifícios junto ao rio parecem todos pastosos.

>

> >

>

>

>

>

>

É por isso que quer realmente um codec de alta qualidade quando capta a imagem. Porque provavelmente vai querer fazer alterações mais tarde, mas ainda não sabe quais podem ser essas alterações. Você vai querer afinar a cor e o contraste, talvez afinar a velocidade, talvez adicionar algum VFX. Um arquivo altamente comprimido não permite essas alterações sem quebrar.

É por isso que é uma boa idéia capturar suas filmagens em 10 bits mesmo que você possa estar saindo um arquivo de 8 bits no final. Você não sabe, quando você filma, quais bits você vai querer.

A Viagem Codec

Agora é hora de caminhar pelas diferentes etapas que você vai encontrar em cada projeto.

Todos os projetos começam com um codec que você captura na câmera. E termina com um codec que você exporta (codec de entrega) e entrega ao seu cliente ou carrega para a web. No caso mais simples, você faz toda a sua edição e correção de cores diretamente nos arquivos da câmera. Depois você exporta para o seu codec de entrega, então você só está usando dois codecs.

Mas na maioria das vezes fica um pouco mais complicado. Você pode transcodificar para um codec diferente para edição, e potencialmente para correção de cores, e definitivamente para VFX. Mas tudo começa com…

O Codec que você fotografa com

(de volta ao índice)

Este é o seu codec de captura, (também chamado “camera native codec” ou “codec de aquisição”).

Em geral, você deve apontar para o codec de maior qualidade que sua câmera (ou seu orçamento) pode capturar. Quando eu digo “alta qualidade”, quero dizer que você quer capturar o máximo de informação possível. Portanto, você quer codecs com menos perdas: menos compressão, maior profundidade de bits e menos subamostragem de croma. Quanto mais informação você tiver ao capturar, mais flexibilidade terá mais tarde. Especialmente na correção de cores e VFX (se você estiver fazendo isso).

Obviamente, você também tem que considerar muitos outros fatores práticos nesta decisão. Caso contrário estaríamos sempre a filmar 8K cru, certo?

Custo

A primeira consideração é obviamente o custo. Em geral, quanto mais cara a câmera, mais codecs de alta qualidade estão disponíveis nela. Eu digo geralmente porque existem algumas câmeras “sweet spot” que podem oferecer excelentes codecs a um preço razoável. A série GH da Panasonic (especialmente nos primeiros dias quando o GH2 foi invadido) era conhecida por oferecer melhores codecs do que as outras câmeras em sua faixa de preço.

Tip: Melhores Codecs com Gravadores Externos

Uma maneira de capturar codecs de maior qualidade em câmeras mais baratas é usar um gravador externo.

Estes dispositivos (muitos dos quais podem dobrar como monitores externos) pegam um sinal não comprimido da câmera, via HDMI ou SDI, e a comprimem separadamente. Assim, você acaba com duas cópias de suas filmagens. Uma cópia é fortemente comprimida na câmara e uma segunda cópia é ligeiramente comprimida no gravador externo. O importante aqui é que a câmera envia o sinal para o gravador antes de comprimi-lo.

Uma nota importante aqui é que muitas câmeras mais baratas só emitem 8 bits, e muitas vezes não em 4:4:4. Um gravador externo pode ser capaz de comprimir para um codec de 12 bits. Mas se a câmera está enviando apenas 8 bits, o gravador só pode gravar 8 bits. Algumas câmeras mais baratas também podem não emitir um sinal HDMI “limpo” que é adequado para a gravação. Chamamos um sinal de saída de “limpo” quando é apenas a imagem pura, sem sobreposições de interface de câmara.

Armazenamento

O segundo factor a considerar é o espaço de armazenamento. Os codecs de alta qualidade tendem a ser de maior taxa de bits, o que significa que os arquivos são maiores. Você precisa estar preparado para armazenar e fazer backup de todos esses arquivos à medida que você está fotografando. E você também pode ter que atualizar seus cartões de memória a fim de poder gravar os dados de alta taxa de bits. Se você estiver fotografando sozinho, então você pode acabar escolhendo um codec de qualidade inferior porque ele permite que você troque os cartões de memória com menos frequência.

Finalizando

Outro fator a considerar é a quantidade de cor e VFX (coletivamente chamado de finalização) que você planeja fazer. Se você vai fazer uma correção de cor muito mínima e nenhum VFX, então você provavelmente pode escapar com menor profundidade de bits, subamostragem de croma e bloqueio de macro que vêm com codecs de captura de menor qualidade.

Editando Hardware

O último fator a considerar é a sua máquina de edição. A maioria dos codecs de captura não são bem adequados para edição sem um computador de alto desempenho. H.264 e alguns arquivos brutos requerem uma CPU/GPU poderosa para editar suavemente. E os codecs de alta taxa de bits podem exigir discos rígidos ou servidores de dados de alta velocidade. A menos que você esteja gravando um codec amigável à edição, talvez tenha que transcodificar seus arquivos para outro codec antes de editar. E isso pode levar tempo. Para alguns, a transcodificação das filmagens não é um grande problema porque pode ser feita durante a noite ou em um computador de reserva. Se você estiver trabalhando em horários muito apertados, porém, você pode escolher um codec que lhe permitirá começar a editar imediatamente após uma filmagem, mesmo que isso signifique um custo maior ou um sacrifício na qualidade da imagem. Explico quais codecs são melhores para edição na próxima seção.

The Codec You Edit With

(back to the index)

Alright, você filmou seu filme, e tem todos os seus arquivos no seu computador. Agora você precisa decidir se você vai editar com esses arquivos. Ou se você quer transcodificar para outro formato.

Por que eu devo transcodificar antes de editar? Não posso simplesmente editar os ficheiros que saíram da câmara?

Bem, depende. Praticamente todos os principais pacotes de software podem agora editar qualquer codec que sua câmera criar. (A menos que você seja um mauzão filmando em uma câmera novinha em folha com tecnologia novinha em folha). Mas embora seja quase sempre possível editar os codecs que sua câmera filmou, nem sempre é a melhor idéia.

Se você tiver a sorte de estar filmando em um codec que é ótimo para edição, você pode pular este passo.

Para muitos de nós, no entanto, o codec de captura não será otimizado para edição. Há dois fatores principais que você precisa considerar ao escolher seu codec de edição: tipo de compressão e taxa de bits.

Codecs altamente compactados podem retardar sua edição

(de volta ao índice)

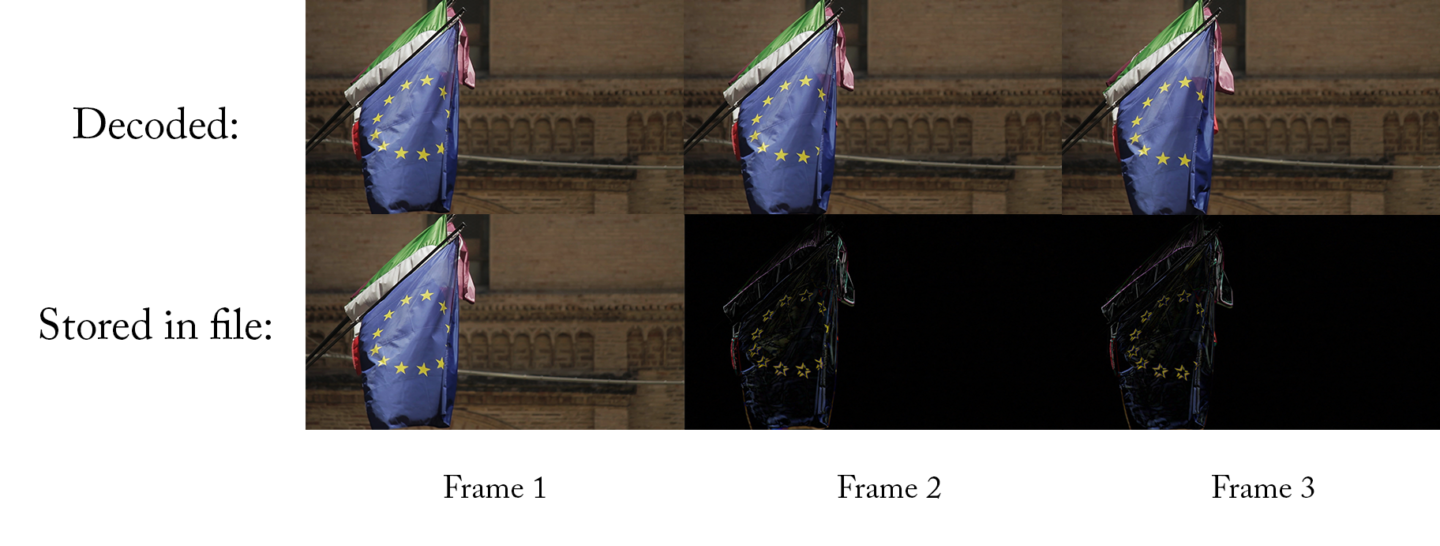

As câmeras mais baixas a médias gravam com codecs que usam compressão temporal, também conhecida como compressão Long-GOP. Vou dar uma explicação simples aqui, mas se você estiver interessado em aprender com mais detalhes, confira o vídeo dos meus codecs, a partir de 19:00.

A explicação simples de um GPO longo é que, para cada frame, o codec só captura o que mudou entre este frame e o frame anterior. Se o vídeo não incluir muito movimento, então o novo arquivo pode ser um LOT menor. A diferença entre este quadro e o último quadro é de apenas alguns pixels. Então tudo o que você precisa armazenar são alguns pixels. Isso é ótimo!

Always forward

O problema, no entanto, é que esses codecs tendem a funcionar bem apenas quando reproduzidos para frente. (Se você está curioso, dê uma olhada no vídeo). Isso é óptimo para ver no YouTube e no seu leitor de DVD, mas não é óptimo para editar. Quando você está editando, muitas vezes está pulando por aí, ou tocando um clipe para trás. E é preciso muito mais poder de processamento para fazer essas coisas rapidamente com um codec de longa duração. Um computador high-end pode não ter problemas, mas até mesmo um computador de médio porte irá atrasar e gaguejar quando você folhear a filmagem rapidamente ou pular por aí.

Codecs que não são Long-GOP (também conhecidos como codecs intra-frame), podem ser reproduzidos para trás tão facilmente quanto para frente. Assim, até mesmo um computador de médio porte pode saltar com muita suavidade. Se você só editou clipes diretamente da câmera, você pode não perceber o que está faltando!

A outra coisa que pode causar problemas com a reprodução é o vídeo bruto. O vídeo bruto precisa ser convertido antes de poder ser exibido (como um codec faz). E alguns computadores não conseguem decodificar o arquivo raw o suficiente rápido, especialmente se for 4K. Ironicamente, tanto as câmeras mais baixas quanto as mais altas produzem arquivos que são difíceis de editar!

Codecs de alta taxa de bits podem retardar sua edição

(de volta ao índice)

Para codecs de baixa a média taxa de bits, você não precisa se preocupar com as taxas de bits. No entanto, quando você começar a subir a escada, os codecs de alta taxa de bits podem causar problemas com a edição, especialmente se você estiver trabalhando em computadores comuns.

O motivo é porque seu computador precisa ser capaz de ler os dados do seu disco rígido com uma taxa de bits pelo menos tão alta quanto a taxa de bits do seu codec. Faz sentido – se seu codec é 50Mb/s (50 megabits por segundo), então seu computador precisa ser capaz de ler esse arquivo do seu disco rígido a 50Mb/s ou ele vai ficar para trás e gaguejar.

(note que Mb/s significa megabits por segundo, enquanto MB/s significa megabytes por segundo. Há oito bits em um byte, então você precisa multiplicar por 8 quando converter de MB/s para Mb/s)

Algumas boas notícias

A boa notícia é que os discos rígidos estão ficando mais rápidos a cada dia. Portanto, 50Mb/s nunca vai causar problemas. Mas e se você estiver editando ProRes 422HQ a 4K, que é 734Mb/s? O disco rígido externo médio mal é rápido o suficiente para reproduzir isso. Alguns discos rígidos mais baratos não vão conseguir fazer isso de todo. E se você estiver editando um multicam com três câmeras? De repente você precisa de 3x essa taxa de dados: 2.202Mb/s! Nesse momento, você vai precisar investir em alguns discos rígidos de alto desempenho ou RAIDs.

Aqui estão algumas diretrizes aproximadas para velocidades comuns de armazenamento de dados. (Haverá sempre certos modelos que apresentam um desempenho inferior ou superior.)

- Discos giratórios padrão: 100-120MB/s

- Acionamento de fiação profissional: 150-200MB/s

- SSD padrão: 400-500 MB/s

- RAID Low-end: 200-300 MB/s

- RAID High-end: 1000-2000 MB/s

O disparo em log pode abrandar a sua edição

O disparo em log é uma forma de preservar o máximo possível da sua gama dinâmica. Isto permite uma cena que tem luzes brilhantes e sombras escuras sem apagar as luzes ou esmagar os negros. Os destaques soprados são um efeito colateral particularmente desagradável de filmar em vídeo, em vez de filmar. Assim, filmar em registo pode ajudar a fazer com que as suas filmagens se sintam mais cinematográficas. Agora que os perfis de log estão disponíveis mesmo na maioria das câmeras prosumer, é uma maneira extremamente popular de trabalhar.

>

O lado negativo

O lado negativo é que a imagem que sai da câmera não parece tão boa. Você precisará adicionar contraste e saturação a fim de se aproximar da imagem final. A maneira mais comum de fazer isso é adicionar um LUT à sua filmagem. Esta é essencialmente uma simples correção de cor predefinida que traz sua filmagem de volta a um visual “normal”.

Se você estiver fotografando em um espaço de cor de log, então você precisa aplicar um LUT à sua filmagem a fim de visualizá-la com cor e contraste normais. Isto significa que seu editor precisará aplicar o LUT apropriado a todos os clipes quando estiver editando. Isto pode ser irritante de gerir, e também pode tornar o computador um pouco mais lento. Isto porque ele precisa primeiro decodificar cada quadro e depois aplicar o LUT antes de exibi-lo. É certamente possível editar a filmagem do log sem nenhum LUT, mas não é o ideal. A cor de duas imagens pode influenciar como você as intercortou.

Se você vai transcodificar seus arquivos antes de editá-los, então você pode aplicar o LUT durante o processo de transcodificação. Dessa forma, o editor está sempre trabalhando com filmagens que têm bom contraste e cor e nunca precisa se preocupar com LUTs. Note que você só deve fazer isso se você estiver usando um fluxo de trabalho Proxy, não um fluxo de trabalho Intermediário Direto (descrito abaixo).

Porcentagem do tempo gasto na transcodificação

A principal desvantagem de transcodificar suas filmagens antes da edição é simplesmente o tempo que leva para fazer a transcodificação. Se você tem muitas filmagens para passar, e seu computador não é rápido, pode levar muito tempo. Se você não estiver com muita pressa, você pode deixar a transcodificação correr durante a noite, potencialmente em vários computadores se você tiver acesso a eles, mas isso nem sempre é o ideal.

Quando eu trabalhava na Academia Khan, nosso fundador gravavava regularmente pequenas mensagens de vídeo para enviar às pessoas. Que estavam frequentemente em horários muito apertados. Eu geralmente filmava em 4K em um formato de log longo-GOP, e os editava em um MacBook Pro. Editar 4K long-GOP com um LUT (para corrigir as imagens de log) em um laptop significaria que eu poderia reproduzir o vídeo de volta muito bem na Premiere Pro, mas eu não poderia ampliar a linha do tempo tão rápido quanto eu queria sem gagueira.

Mas isso não me incomodava muito porque a edição era extremamente simples. Apenas alguns cortes, talvez alguma música, um título, e eu estava pronto. Apesar da minha velocidade de edição não ser a ideal, eu teria passado mais tempo na transcodificação do que teria guardado na velocidade de edição, por isso usei apenas os ficheiros originais.

Se eu estivesse a editar uma peça mais longa com a mesma configuração, no entanto, faria a transcodificação para DNxHD ou ProRes. Geralmente, eu faria a maior parte da transcodificação durante a noite, muitas vezes com várias máquinas rodando ao mesmo tempo.

Proxy Edit

(de volta ao índice)

Se você vai transcodificar os arquivos da câmera nativa antes de editá-los, então você vai usar um codec “intermediário”. É chamado de intermediário porque vem entre o codec de captura e o codec de exportação. Existem duas formas comuns de trabalhar com codecs intermediários:

A primeira é o fluxo de trabalho “proxy” ou “edição offline”. Isto significa que você está transcodificando suas filmagens capturadas para um formato intermediário, editando com esse formato, e depois re-ligando de volta aos arquivos originais da câmera antes de exportar. Como você vai usar os arquivos da câmera para exportar e não os arquivos proxy, você não precisa se preocupar tanto em escolher um codec proxy com ótima qualidade de imagem – codecs com perdas são bons. Você pode otimizar a velocidade de edição e a conveniência do armazenamento em seu lugar.

O fluxo de trabalho do proxy é tão comum que muitas câmeras high-end gravam um arquivo raw high-end *e* um arquivo proxy ProRes ou DNxHD ao mesmo tempo. Após a gravação, os arquivos raw são copiados e colocados em armazenamento. Os arquivos proxy são enviados para os editores e para o diretor/produtor de dailies.

Anular compressão temporal

Ao escolher um codec proxy, você quer escolher um que não use compressão temporal (também conhecido como compressão entre quadros ou compressão GOP longa), e você quer escolher um que tenha uma menor taxa de bits. A baixa taxa de bits significa que os arquivos são muito menores, então você pode usar menos/pequeno/pequeno/cheaper discos rígidos, simplificando o seu fluxo de trabalho. Woot!

Embora os arquivos proxy sejam ótimos para edição, você não deve fazer mais do que a correção básica de cores com arquivos proxy. Se você vai fazer toda a correção de cores dentro do seu software de edição, então é melhor fazer um link de volta aos arquivos da sua câmera porque os seus arquivos proxy podem ter qualidade de cor inferior.

A boa notícia é que a maioria dos softwares de edição de hoje podem alternar entre os arquivos da câmera e os arquivos proxy em apenas alguns cliques, então você pode até mesmo ir e voltar se precisar.

Publicamos guias detalhados para fluxos de trabalho de proxy em cada um dos maiores NLEs:

- Final Cut Pro X Proxy Workflows

- Premiere Proxy Workflows

- Avid Media Composer Proxy Workflows

Algumas boas escolhas para os codecs proxy

De longe os codecs proxy mais comuns são DNxHD/DNxHR e ProRes. Ambos já existem há anos, por isso são muito bem suportados. Todos sabem como lidar com eles. Ambos são muito adequados para um fluxo de trabalho de proxy (ProRes tem até mesmo um predefinido chamado “proxy”), e são quase intercambiáveis quando usados para proxies.

DNxHD é feito pela Avid, e ProRes é feito pela Apple. Portanto, faz sentido que DNxHD funcionaria melhor no Media Composer e ProRes funcionaria melhor no Final Cut Pro X. Isso certamente era verdade, mas hoje em dia ambos os codecs funcionam muito bem em todos os editores modernos (incluindo Premiere Pro). Pode haver um leve aumento de velocidade no uso do codec que foi projetado para o sistema, mas é muito leve.

A única diferença significativa entre os dois para um fluxo de trabalho proxy é o fato de que você pode ter problemas para criar ProRes em um PC, enquanto DNxHD é muito fácil de criar cross-platform. A única forma oficialmente suportada de criar ProRes em um PC é com Assimilate Scratch. Existem alguns outros métodos não suportados para criar arquivos ProRes em um PC, mas eles nem sempre são confiáveis. Os PCs podem facilmente reproduzir e editar arquivos ProRes, mas você não pode codificar novos arquivos ProRes em um PC tão facilmente quanto DNxHD, e por isso alguns editores preferem um fluxo de trabalho DNxHD por esse motivo.

Pick a lane

Independentemente de qual dos dois codecs você escolher, você também tem que escolher qual sabor você quer. Isto vai realmente depender das suas restrições de armazenamento – é um tradeoff entre a qualidade da imagem e o tamanho do arquivo. A boa notícia é que você não precisa de uma boa qualidade de imagem quando estiver editando, então você pode escolher um codec de baixa taxa de bits.

Comece com o menor codec ProRes ou DNx na mesma resolução do seu codec de captura. Veja a coluna GB/hr e multiplique pelo número de horas de filmagens que você tem. Se você tem espaço de armazenamento suficiente, então você é bom – use esse codec. Se você tem muito espaço de armazenamento extra, pense em usar o próximo maior sabor.

Mas se você não tem espaço de armazenamento suficiente, ou se você está em uma máquina com pouco poder, então diminua a resolução um pouco. Muitos filmes de Hollywood de grande orçamento foram editados em 480p há apenas alguns anos, por isso não se preocupe se precisar de baixar a resolução de 4K para 720P para a edição.

Direct Intermediate

O outro tipo de fluxo de trabalho intermédio é algo a que estou a chamar Direct Intermediate. Isto significa que você transcodifica os arquivos da sua câmera em um codec que é bom para edição e de muito alta qualidade (não muito perdida). Como o codec é de alta qualidade, quase toda a informação original dos arquivos da câmera foi preservada, e por isso não é necessário fazer uma ligação de volta aos arquivos da câmera – você pode simplesmente exportar diretamente dos arquivos intermediários. Haverá alguma perda teórica de informação quando você transcodificar, mas se você escolher um codec intermediário bom o suficiente, ele será pequeno o suficiente para não precisar se preocupar com ele.

(Nota: Eu estou chamando este processo de “Intermediário Direto” porque não há um nome comum para este fluxo de trabalho. As pessoas normalmente chamam este processo de “intermediário”, mas isso pode ser confuso porque os fluxos de trabalho proxy também são uma espécie de fluxo de trabalho intermediário. Algumas pessoas também chamam a isto um fluxo de trabalho “online”, mas isto também é confuso porque este termo foi criado para descrever um fluxo de trabalho que inclui uma edição offline e online, não um fluxo de trabalho que está online do início ao fim.)

Preservação é a chave

A chave para escolher um bom codec Direct Intermediate é certificar-se de que está a preservar todas as informações do seu codec de captura. Um codec intermediário nunca melhorará suas imagens (explicação mais detalhada abaixo), mas pode definitivamente piorá-las se você escolher o codec errado. O importante é compreender os detalhes das suas filmagens originais e certificar-se de que o seu codec intermediário é pelo menos tão bom quanto o seu codec de captura em cada área. Se capturar as suas filmagens num DSLR como um Sony A7Sii a 4K, então estará a gravar num codec 4:2:0, 8-bit, Long-GOP a 100Mbps. Você quer um codec intermediário que seja pelo menos 4:2:0 e 8 bits. Ir além desses valores (por exemplo, para 4:4:4 e 12 bits) não vai doer, mas também não vai ajudar em nada. Então provavelmente não vale o espaço de armazenamento extra.

Vamos dizer, por exemplo, que queremos ir com um codec ProRes. Temos 4 opções para escolher entre elas são 4:2:2 e 10-bit.

- 145Mb/s ProRes 422 Proxy

- 328Mb/s ProRes 422 LT

- 471Mb/s ProRes 422

- 707Mb/s ProRes 422 HQ

Acima e acima

Você pode pensar que tudo o que você precisa é combinar a taxa de bits da câmera (100Mbps), mas você realmente precisa exceder em muito a taxa de bits da câmera. Isto porque o h.264 é um codec muito mais eficiente do que o ProRes. Como o h.264 usa compressão de GPO longa, ele pode empacotar muito mais informações nesses 100 megabits do que o ProRes. Para que o ProRes corresponda à qualidade de imagem do h.264, você precisa de uma taxa de bits muito maior. Eu recomendaria usar apenas ProRes 422 ou ProRes 422 HQ se você estiver começando com um codec h.264 de 100Mbps. ProRes 422 provavelmente serve perfeitamente, mas se você tiver muito espaço de armazenamento, então ir até ProRes 422 HQ terá uma leve margem.

Embora seja bom simplesmente combinar com a amostragem de profundidade de bits e cor ao escolher um intermediário, você deve sempre aumentar a taxa de bits pelo menos um pouco. Se você estiver indo de um codec GOP longo para um não longo, então você deve aumentar muito a taxa de bits.

Nota lateral: Se você queria ir com DNxHD ao invés de ProRes, você tem opções similares, exceto que DNxHD também oferece uma versão 8-bit para os codecs inferiores. Uma vez que as nossas filmagens são 8-bit para começar, isso não nos vai prejudicar em nada.

O fluxo de trabalho proxy soou bastante bem. Porque é que o Direct Intermediate?

Part of the reason why the Direct Intermediate workflow is common is because it used to be much more harder to use a proxy workflow. Alguns dos principais fornecedores de software não facilitavam particularmente a ligação de volta aos ficheiros originais da câmara, pelo que as pessoas escolhiam um fluxo de trabalho directo intermédio. Hoje em dia, no entanto, é muito fácil de fazer em qualquer pacote de edição. A principal exceção é quando você tem um monte de tipos de filmagens mistas. Se você tiver várias taxas de quadros e tamanhos de quadros no mesmo projeto, mudar dos proxies para os codecs de captura pode ser uma dor de cabeça.

Se você estiver usando algumas ferramentas de terceiros para ajudar a preparar e organizar suas filmagens antes de começar a cortar, isso também pode tornar o processo de relinking mais complicado. Um exemplo comum pode ser um software que sincroniza automaticamente faixas de áudio ou disparos de multicamadas.

Sem necessidade de troca

Outra razão pela qual você pode querer usar um fluxo de trabalho Intermediário Direto é porque você pode passar diretamente para o processo de correção de cor e VFX (“finalização”) sem trocar qualquer arquivo. Continue lendo, e eu explicarei mais sobre porque isso é conveniente nas seções Color-Correction e VFX.

Uma desvantagem, entretanto, é que você não pode “cozer” os LUTs para o seu editor – você vai precisar aplicar um LUT através de um efeito de correção de cor no seu software de edição. Se você fosse incluir o LUT na sua transcodificação para o fluxo de trabalho Direct Intermediate, você estaria perdendo todos os benefícios de gravar em log em primeiro lugar.

A outra desvantagem óbvia é que você precisa armazenar todos esses arquivos (muito maiores).

Um codec intermediário nunca melhorará suas imagens

(de volta ao índice)

Isso é muito importante, pois é muito comumente mal entendido, e há muita desinformação online. A transcodificação das suas filmagens antes de editar nunca aumentará a qualidade da saída. Há algumas operações extras que você poderia fazer no processo de transcodificação (como usar ferramentas sofisticadas de up-res) que poderiam aumentar a qualidade da imagem em alguns casos, mas um novo codec por si só nunca aumentará a qualidade da sua imagem.

Se você escolher o codec certo, você pode evitar ferir sua imagem, mas nunca poderá melhorá-la.

Isso inclui ir de h.264 para DNxHD ou ProRes. Isso também inclui ir de 8 bits para 10 bits. E ir de 4:2:0 para 4:4:4.

Aqui está uma ilustração que pode ajudá-lo a entender este conceito:

Esta é uma foto de uma rosa refletida em uma gotícula de água. São 4 megapixels, e fica muito bonito no meu monitor de 27 polegadas.

Agora e se eu tirar uma foto do meu monitor com uma câmera Red Helium 8k. Isto é uma besta de uma câmera. Eu tirei a foto da rosa alguns anos atrás com uma Canon Rebel DSLR barata, no valor de cerca de $250 hoje. A configuração do Red Helium custa cerca de $50.000, é de 35 megapixels, é crua, tem um dos melhores sensores de câmera já produzidos.

>

Qual será uma imagem melhor – a foto de 4 megapixels, ou a foto de 35 megapixels?

Uma captura de uma captura

A câmera Vermelha tem mais megapixels, certo? É crua, e tem toda a magia digital Vermelha, certo? Mas como eu estou usando minha câmera de alta resolução para tirar uma foto da foto, não uma foto da rosa, minha nova imagem nunca será melhor do que a primeira. Eu tenho um arquivo que é tecnicamente de maior resolução, mas ele não captura mais do meu objeto (a rosa) do que a primeira.

Isso é o que você está fazendo quando você está transcodificando. Você está fazendo uma cópia de uma cópia, tirando uma foto de uma foto. Se você usar uma câmera de alta resolução para tirar uma foto de uma foto, você será capaz de preservar praticamente toda a informação na imagem original, mas você não será capaz de adicionar mais nada.

O grande aviso é que, se você estiver fazendo qualquer processamento, qualquer transformação da imagem (adicionando um LUT, por exemplo), então você definitivamente quer transcodificar em um codec de maior qualidade, que irá reter novas informações. Mas se você não estiver alterando a imagem, então a transcodificação não fará sua imagem de alguma forma “melhor”

A Real-World Example

(back to the index)

Vamos dizer que você está editando um documentário que capturou filmagens de 4K usando uma câmera Sony A7sii, gravando na versão longa-GOP do XAVC-S. Não é ideal para editar. Se eles filmassem 40 horas de filmagens para o seu documentário de longa metragem, você acabaria com cerca de 2.7TB de arquivos de câmera, que podem caber facilmente em um disco rígido (embora você tenha feito outros backups separados, é claro!).

Você poderia converter isso para um codec de alta qualidade, não muito perdido, para um fluxo de trabalho Intermediário Direto, talvez ProRes 422 HQ em 4K.

A desvantagem é que você precisaria de cerca de 12.7TB para armazenar todos esses arquivos ProRes. Você teria que usar uma configuração RAID cara para ter acesso fácil a todas essas filmagens em um projeto, pelo menos $1,000. Amendoins para uma grande facilidade, mas um investimento significativo para um editor solo.

Selecionar proxy

Então você pode decidir usar um fluxo de trabalho Proxy e transcodificar seus arquivos para o formato ProRes 422 Proxy 4K. Então sua filmagem ocuparia apenas 2.8TB, apenas pouco mais do que a sua filmagem capturada. Você pode então editar facilmente de um único disco rígido, e o seu fluxo de trabalho fica muito mais simples. (Para instruções sobre como calcular taxas de bits e tamanhos de arquivos, confira este artigo: The Simple Formula to Calculate Video Bitrates).

Let’s say that you’re working with another editor who’s on the other side of the country. Você pode decidir transcodificar a filmagem ainda mais para o ProRes 422 Proxy HD, o que reduziria sua filmagem para apenas 640GB, o que se torna mais viável de enviar pela Internet se você tiver uma conexão rápida. (18hrs para baixar em uma conexão de 80Mbps)

Quando a edição estiver completa, você apenas re-ligará seu projeto de volta aos arquivos originais da câmera e exportará. Mesmo que você e seu editor remoto tenham trabalhado em um codec com bastante perda, a exportação final o ultrapassa, assim você não perde nenhuma qualidade.

O Codec you Color-Correct

(de volta ao índice)

Ok, agora você tem seu vídeo editado, e é hora de corrigir a cor. Tudo sobre o que estamos falando aqui será aplicado se você está corrigindo as cores dentro da sua aplicação de edição, ou se você está enviando sua edição para um software dedicado à correção de cores.

A grande questão neste momento é se você quer corrigir as cores diretamente nos arquivos originais da câmera, ou se você quer transcodificar. Se você fez uma edição proxy/offline, então você definitivamente não quer corrigir as cores dos arquivos proxy, porque eles têm uma qualidade de imagem menor. Para tomar boas decisões sobre cores, você precisa da imagem de maior qualidade que você tem disponível, porque você precisa ser capaz de ver exatamente com o que você tem que trabalhar.

Então precisamos trabalhar com imagens de alta qualidade, e temos algumas opções diferentes:

A. Classifique os ficheiros da câmara

Esta é certamente uma opção simples. Se você fez uma edição proxy, você pode relink para os arquivos da câmera para o processo de acabamento e ir para a cidade. Isso lhe dará a máxima qualidade de imagem, mas lembra como os arquivos da câmera podem ser lentos para trabalhar? Os arquivos da câmera podem retardar um pouco o processo, mas dependendo do software que você usa e da quantidade de trabalho que você precisa fazer, você pode decidir que a simplicidade vale um pouco de lentidão potencial. Se você tiver uma edição curta sem muita complexidade, então este pode ser um ótimo e fácil fluxo de trabalho.

Vamos assumir que a lentidão da correção de cor o incomoda, então você precisa de um codec que seja mais fácil de trabalhar. Você poderia transcodificar todas as suas filmagens para um codec de alta qualidade de imagem, criar um link para esses arquivos e então começar a fazer sua correção de cor. Mas… esse tipo de coisa derrota o propósito de um fluxo de trabalho proxy, não é? Usamos proxies porque não queríamos ter de lidar com os grandes ficheiros que iriam criar. Felizmente, existe outra opção.

B. Consolidate and Transcode

(back to the index)

Se você usou um fluxo de trabalho proxy/offline para a edição mas não quer corrigir os arquivos da câmera, uma boa opção é fazer o link para os arquivos da câmera, consolidar seu projeto e depois transcodificar para um codec high-end.

Quando você consolida um projeto, seu software de edição fará uma cópia do seu projeto junto com uma cópia da mídia, mas apenas os arquivos particulares que você acabou usando na sua sequência. Portanto, se você disparou 7 takes mas só usou um deles na edição, ele só copiará esse take. Isto reduz muito o armazenamento, o que vem a calhar nesta fase. Você também pode consolidar ainda mais para baixo para que você mantenha apenas as porções específicas de cada take que você realmente usou na edição, descartando o resto. Neste caso, o software normalmente incluirá alguns segundos antes e depois de cada take (chamado “handles”), caso você queira adicionar um fade ou motion tracking.

Inicie sua nota

Agora você pode pegar este novo projeto consolidado (depois de relinking para os originais) e transcodificar todos estes arquivos para um codec de alta qualidade e alta taxa de bits, e iniciar a correção de cores. Isto é diferente do fluxo de trabalho Direct Intermediate porque você não está transcodificando todas as suas filmagens – apenas as filmagens que fizeram a edição final, que podem ser de 1/20º ou 1/50º do comprimento das filmagens que você filmou originalmente. Agora não soa tão mal transcrever para um codec de alta taxa de bits porque você não precisa armazenar muito dele. Mesmo no ProRes 4444 4K, um filme de longa-metragem completo terá apenas 2TB – bastante manuseável.

Agora você pode terminar seu filme com imagens de alta qualidade e processamento rápido, em um disco rígido que cabe no seu bolso. Woot!

C. Continue com o Direct Intermediate

A terceira opção é ir com o fluxo de trabalho de edição Direct Intermediate, neste caso você está pronto para ir. Você já transcodificou todos os seus arquivos para um codec de alta qualidade antes de começar a edição, então você pode simplesmente continuar com esses mesmos arquivos para correção de cor. Isso também é conveniente porque esses arquivos são bons tanto para edição quanto para correção de cores e VFX (veja abaixo).

Se você estiver entregando o projeto para um colorista externo ou uma pessoa VFX, então você pode dar a eles todas as suas filmagens de alta qualidade (potencialmente irritantes por causa do tamanho), ou você pode usar a mesma dica de consolidação que usamos acima. A entrega do projeto consolidado pode ajudá-lo a mover-se mais rápido e poupar o tempo do seu colorista também.

Outra vantagem

Além da simplicidade do fluxo de trabalho Direct Intermediate (você usa apenas um conjunto de arquivos), você tem uma outra vantagem: ir e vir entre a edição e a correção de cores é mais simples.

Imagine que você terminou sua edição proxy – você consolida e transcode, envia para o seu colorista, e então decide que você precisa fazer algumas mudanças na edição. Agora você tem que voltar para os proxies para fazer a edição e depois re-consolidar e reenviar as filmagens. A mecânica disso pode ficar bastante confusa. Em um fluxo de trabalho de pós-produção de alta qualidade, geralmente há um “bloqueio” na edição para que os processos de finalização possam começar. Isto significa que (a menos que coisas ruins aconteçam) você se esforçará muito para não voltar atrás e fazer alterações na edição. Mas ei, coisas ruins acontecem, então é melhor estar preparado.

E agora encontramos outra boa razão para uma edição Intermediária Direta. Se você vai fazer algum do seu trabalho de cor e seu trabalho de edição simultaneamente, ou pelo menos vai voltar e avançar algumas vezes, então pode ser mais simples usar um codec para ambos. Isto é especialmente conveniente se você estiver fazendo sua edição e acabamento no mesmo pacote de software (ou conjunto de pacotes, por exemplo, Creative Cloud).

O Codec que você envia para VFX

(de volta ao índice)

Se você estiver fazendo algum trabalho em VFX, então você provavelmente vai precisar enviar arquivos para outro programa (potencialmente outra máquina, para outro artista). Se estiver a fazer todo o seu trabalho VFX no seu editor (que está a tornar-se cada vez mais viável para trabalhos simples), então você pode saltar esta secção. Basta usar o mesmo codec que você usou para sua correção de cor.

Para a maioria de nós, no entanto, precisamos configurar um processo de “ida e volta” que envia clipes do editor para o software VFX e depois volta quando eles terminarem. Isto acontece de uma forma “shot-by-shot”, então você não está enviando a seqüência inteira para o VFX, como você provavelmente fez para a classificação de cores. A questão de quando no processo você envia suas fotos para VFX depende muito do fluxo de trabalho em particular.

Algumas pessoas enviarão para VFX depois que a edição estiver bloqueada e a correção de cor concluída, mas a pressão do tempo pode forçá-lo a começar a enviar fotos antes disso.

Se você estiver editando no Premiere Pro e fazendo VFX suave no After Effects com Dynamic Link, então você também pode pular esta seção. O Dynamic Link faz automaticamente o round-tripping para você. Se você está fazendo muito trabalho VFX, você ainda pode querer usar as técnicas desta seção, porque o Dynamic Link pode ser um pouco delicado com muitos projetos. O Adobe está sempre trabalhando nesses bugs, no entanto, e por isso em parte depende do seu gosto pessoal.

Vá grande ou vá para casa

No processo VFX, você tende a usar codecs muito high-end (alta taxa de bits) por duas razões principais. A primeira é simplesmente que os artistas VFX precisam de todas as informações que você pode lhes dar para fazer bem o seu trabalho. Os artistas VFX são algumas das pessoas mais exigentes quando se trata de codecs, e por uma boa razão. Todos querem imagens de alta qualidade, mas problemas de imagem podem muitas vezes colocar mais problemas para VFX do que para edição, correcção de cor e exportação final.

Muitas tarefas no trabalho VFX requerem uma análise muito detalhada da imagem a nível de pixel por pixel, o que a maioria dos editores nunca precisa de fazer. Por exemplo, se você estiver fazendo uma extração de tela verde, você quer que a borda entre seu personagem e a tela verde seja a mais limpa possível. Todos nós já vimos imagens horríveis do ecrã verde onde as bordas do personagem estão todas cortadas ou desfocadas. Estes problemas surgem frequentemente devido a artefatos de compressão de imagem que são invisíveis a olho nu. A subamostragem de cores 4:2:2 ou 4:2:0, por exemplo, não tem quase nenhum impacto visível sobre a imagem. O olho humano se preocupa principalmente com o contraste e raramente nota baixa resolução de cor, mas o processo de extração da tela verde se baseia principalmente nos valores de cor. Se o codec deitou fora uma grande parte dos valores de cor usando subamostragem de cor 4:2:0, uma boa chave de cor pode ser impossível.

Perda de geração

A segunda razão pela qual você quer usar codecs high-end é por causa da perda de geração. No processo VFX, você provavelmente terá que comprimir seu arquivo várias vezes. Você irá comprimir o arquivo uma vez quando você o enviar para eles. E então, se eles precisarem passar o arquivo entre vários especialistas, eles podem comprimir o arquivo duas ou três vezes antes de enviá-lo de volta. Quando um arquivo é comprimido várias vezes, chamamos isso de perda de múltiplas gerações.

Se você estiver usando um codec de baixa qualidade, a imagem ficará progressivamente pior a cada vez que você a comprime novamente. Uma das coisas boas sobre os codecs de alta qualidade é que você pode comprimi-los um par de vezes sem perder muita qualidade. Embora seja sempre melhor evitar comprimir um vídeo várias vezes, se você estiver usando codecs de alta qualidade, normalmente você está muito bem.

alguns fluxos de trabalho VFX de alta qualidade só usarão compressão sem perdas por este motivo. A boa notícia é que as suas imagens VFX são normalmente apenas alguns segundos por clipe, o que significa que o tamanho do seu arquivo será pequeno mesmo com codecs high-end. Então, vá em grande! Se você capturou 4:4:4 na câmera, então definitivamente envie 4:4:4 para VFX. Caso contrário, eu escolheria um codec 4:2:2 topo de linha (ProRes 422 HQ ou DNxHQX).

E, claro, você deve sempre se comunicar de antemão com VFX sobre qual codec enviar. Se você acha que eles estão fazendo uma má escolha, envie-lhes este artigo 🙂

The Codec You Export

(back to the index)

Agora você terminou a edição, a cor e o VFX – você está pronto para exportar. Você normalmente fará a exportação final do software que você usou para correção de cor, usando o codec que você usou no processo de correção de cor.

Se seu cliente está no negócio de mídia, ele deve saber qual codec ele quer, então você pode pular o resto desta seção!

Se o seu cliente não é um especialista em vídeo, ele pode não saber o que quer, então você precisa tomar algumas decisões por ele. Na maioria das vezes, o seu cliente vai querer um vídeo para carregar no YouTube e/ou em outros sites de redes sociais. Você pode se sentir tentado a escolher um codec que seja bom para o streaming na Internet. Mas você estaria errado!

O motivo pelo qual: esses sites não transmitem o mesmo arquivo que você carrega para seus telespectadores – eles comprimem o arquivo *again* antes de transmiti-lo, e você não tem absolutamente nenhum controle sobre as configurações que eles usam. Isto significa que, se você carregar um codec de baixa qualidade, então temos o cenário em que estamos tirando uma foto de baixa qualidade de uma foto de baixa qualidade de que falamos. Mau! Evite!

Aponte para a melhor qualidade

Como regra geral, se você quer o resultado de melhor qualidade, você deve carregar a fonte de melhor qualidade. Eles vão comprimir novamente de qualquer maneira, então dar-lhes mais trabalho com dados não pode prejudicar, certo? Se você tiver uma conexão rápida o suficiente, você pode fazer o upload de um ProRes 422. Algumas pessoas relataram resultados ligeiramente (apenas ligeiramente) melhores ao fazer upload de ProRes, ao invés da recomendação h.264.

Se você está entregando um arquivo para um cliente, para eles fazerem upload no Youtube, então eu não lhes daria ProRes, já que você não sabe que tipo de largura de banda eles vão ter. Felizmente, estes sites tendem a publicar as especificações de upload recomendadas (apenas no Google). Eu pessoalmente pegarei qualquer bitrate que eles recomendarem e multiplicarei por cerca de 1.5x a 2x.

Seu cliente também pode querer um arquivo que eles possam incorporar diretamente em seu site (embora eu os dissuadiria, se você puder). De um modo geral, você quer um h.264 muito comprimido. Se você está curioso sobre o que é uma boa taxa de bits, o meu raciocínio é que, se alguém sabe o que é a taxa de bits do sweet-spot, é o YouTube. Eu periodicamente descarrego um vídeo do YouTube e verifico a sua taxa de bits, e uso isso como referência.

Ir pequeno

Se o vídeo não for público, eles também podem querer um pequeno ficheiro que possam enviar por e-mail ou link directamente para os seus próprios clientes para que o possam descarregar. Nesses casos, pode ser apropriado entregar mais de dois arquivos separados, especialmente se for um vídeo longo. O arquivo que eles devem carregar no YouTube será muito grande para enviar por e-mail de forma conveniente. Neste caso, eu normalmente descerei o arquivo e o comprimirei muito. Você também tem que ser realista e decidir se você acha que seu cliente vai realmente entender a diferença entre os dois arquivos.

Se eu precisar entregar mais de um arquivo, eu normalmente chamarei um deles de “HD” no nome do arquivo e o outro de “pequeno” ou “não HD” no nome do arquivo. Se você tentar descrever os diferentes codecs para eles, posso quase garantir que eles terão esquecido a diferença até a próxima semana, mas eles provavelmente vão se lembrar o que significa HD e “não HD”.

>

O Codec You Archive

(de volta ao índice)

>

Você entregou o(s) arquivo(s) ao seu cliente, então agora você pode sentar e relaxar… quase.

Como qualquer profissional da indústria sabe, o dia em que você entrega o produto final ao seu cliente muitas vezes não é a última vez que você toca em um projeto. Às vezes, um cliente quer voltar e mudar algo semanas depois, ou eles querem um codec de maior qualidade, ou talvez você queira adicioná-lo ao seu carretel pessoal. Em qualquer um desses casos, você pode ter mudado para uma máquina diferente ou para um software diferente, tornando uma dor de cabeça abrir o projeto original e reexportar.

Isso é útil

Aqui é onde é útil ter um grande arquivo do projeto terminado em um codec de alta qualidade extremamente alta. Se o seu cliente solicitou um codec de alta qualidade para entrega, então você geralmente está configurado. Basta manter uma cópia desse arquivo, e você é bom. Se eles precisarem de um codec de entrega que não seja de alta qualidade, porém, é sempre bom fazer sua própria exportação com um codec sem perdas ou o mais próximo possível de um sem perdas, dado o espaço que ele vai ocupar. Eu geralmente exportarei para um codec de alta taxa de bits 4:4:4 – seja DNxHD/HR ou ProRes.

Perguntas? Comente.

Eu realmente leio cada comentário. Este artigo é um trabalho em progresso, e vou atualizá-lo com mais explicações e exemplos baseados no seu feedback. Se você tiver algum comentário ou perguntas particulares, me envie um email: david em frame dot io.

Quer escrever para o Frame.io Blog? Envie-me um email: blog em frame dot io.

Muito obrigado a Larry Jordan, Shane Ross e Philip Hodgetts pela sua contribuição neste artigo!