I codec non devono essere difficili. No, davvero, non lo sono. Tutto ciò che conta è scegliere il codec giusto.

Alla fine di questo articolo, sarete in grado di scegliere il codec migliore per voi su ogni progetto. Il mio obiettivo è quello di darvi ciò di cui avete bisogno per prendere le vostre decisioni informate sui codec. Così potrai scegliere il codec giusto per te, invece di basarti su ciò che ha funzionato per qualcun altro.

Ti guiderò attraverso ogni passo nel processo di creazione di un video. Clicca su un titolo per saltare a quella sezione. Coprirò:

- Il codec che riprendi

- Il codec che monti

- Il codec che correggi il colore

- Il codec che mandi ai VFX

- Il codec che esporti

- Il codec che archivi

In ogni fase, Ti spiegherò quali fattori dovresti considerare quando scegli un codec. Ti darò anche alcuni esempi dei codec più comunemente usati per quella fase.

Durante il percorso, copriremo perché i codec di fascia bassa e quelli di fascia alta possono rallentare il tuo editing, le ragioni per un proxy/offline edit, un walkthrough di un progetto reale, alcune strategie per risparmiare spazio e una spiegazione del perché la transcodifica non può migliorare la qualità dell’immagine.

I vantaggi di ottimizzare i tuoi codec possono essere enormi. Scegliete il codec giusto e conserverete le vostre immagini con la massima qualità. Può anche rendere il tuo lavoro più veloce, e ti permette di sfruttare al meglio il tuo computer e la tua memoria. Sarai in grado di lavorare più velocemente su un computer portatile che su un tower di fascia alta.

Cosa fa un codec

Un codec è un metodo per rendere i file video più piccoli, di solito buttando via attentamente i dati di cui probabilmente non abbiamo bisogno. E sono piuttosto intelligenti su come lo fanno. Qualche anno fa, ho creato un video che copre le principali tecniche di compressione che molti codec utilizzano. Non è una visione obbligatoria per capire questo articolo, ma certamente non farà male.

Come funzionano i codec – Tutorial.

Se stai saltando il video, ecco alcune spiegazioni di base:

- Sottocampionamento croma: Butta via alcuni dati di colore (4:4:4 non è un campionamento chroma. 4:2:2 è un po’ di sottocampionamento del croma. 4:2:0 è un sacco di sottocampionamento del croma). Male se stai facendo la correzione del colore. Molto male se stai facendo un lavoro di green screen o VFX.

- Macro-Blocking: Trova blocchi (di dimensioni variabili) di colori simili e li rende tutti dello stesso colore. Male per i VFX e la correzione del colore. Quasi tutti i codec lo usano in qualche misura, e la quantità tende a variare con il bitrate.

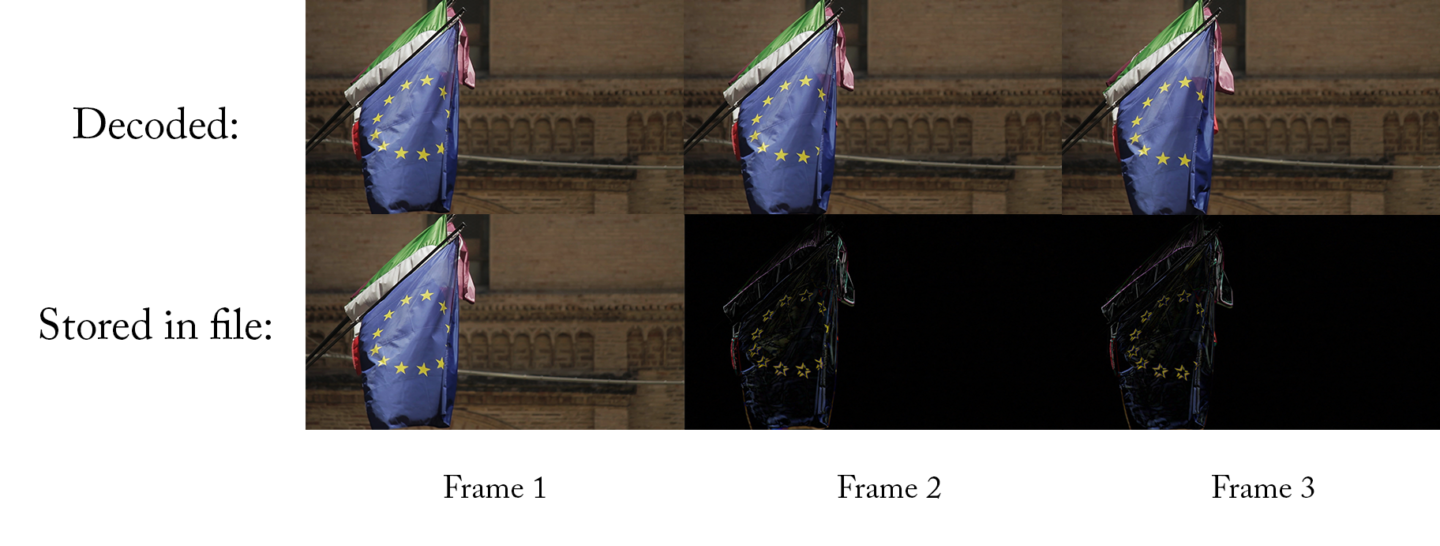

- Compressione temporale: Utilizza i fotogrammi precedenti (e talvolta quelli successivi) per calcolare il fotogramma corrente. Male per l’editing.

- Profondità di bit: Il numero di colori possibili. Una maggiore profondità di bit (numeri più grandi) è buona per la correzione del colore e i VFX.

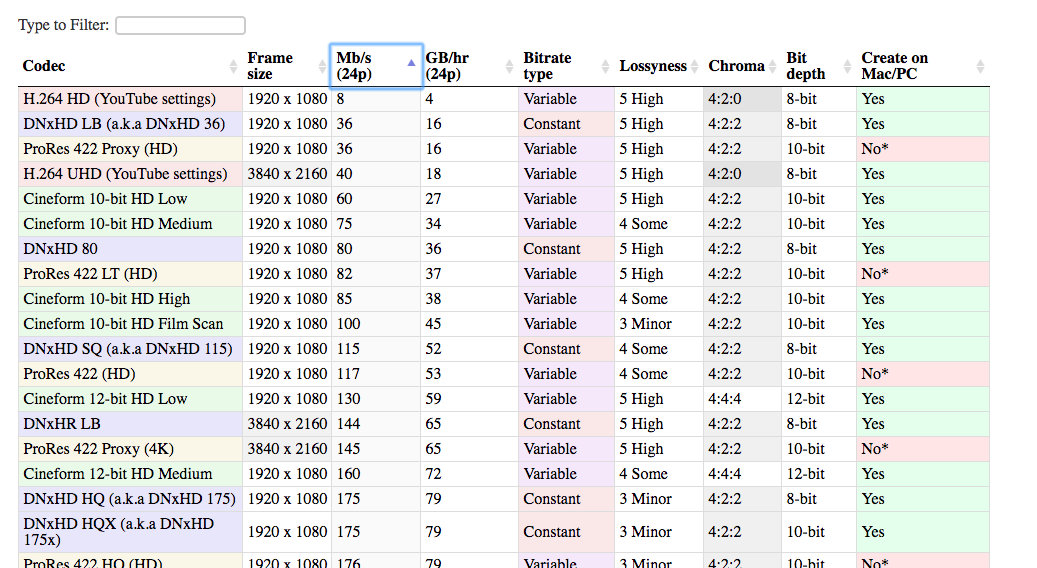

Tabella di confronto dei codec

Ho anche messo insieme una lista di tutti i codec più comuni usati nel mondo della postproduzione. Questa lista può aiutarti a confrontare diversi codec tra loro e prendere la decisione migliore per il tuo progetto.

Ci sono molti codec diversi che possono essere usati nel processo di editing. Quelli che ho incluso sono di gran lunga i più comuni. C’è un vantaggio significativo nell’usare codec popolari. È più probabile che funzionino sul tuo sistema, sul sistema del tuo cliente, sul tuo sistema tra cinque anni, ecc. Ed è più facile trovare aiuto se qualcosa va storto.

Apri la tabella in una nuova scheda. In questo modo puoi confrontare i codec mentre leggi l’articolo.

Guarda la tabella

Lossyness

Una delle colonne della tabella è “lossyness,” che è un concetto importante con i codec. Quando parlo di lossyness, non intendo necessariamente ciò che il vostro occhio vede. Intendo la quantità di dati che viene trattenuta dal codec, solo una parte dei quali si può vedere. La domanda è: se avessi un’immagine non compressa e poi la comprimessi con questo codec, quanto sarebbe simile la nuova immagine alla vecchia? Quante informazioni si perdono nella transcodifica? Se le due immagini sono molto simili, allora il codec non è molto perdente. E se sono piuttosto diverse, allora è più lossy.

La lossyness è una combinazione delle tecniche che il particolare codec usa e il suo bitrate. Un codec più dispersivo non è necessariamente un male. In alcuni casi (quando si guarda online, per esempio), non è davvero necessario mantenere il 100% dell’immagine originale. Usare un codec con più perdite può essere una mossa davvero intelligente a causa di quanto spazio risparmia.

Se l’immagine sembra altrettanto buona ai miei occhi, allora perché dovrebbe importarmi se è tecnicamente ‘lossy’?

Ti dovrebbe importare perché potresti voler cambiare l’immagine. Se stai facendo qualsiasi tipo di correzione del colore, allora cambierai l’immagine. Il risultato potrebbe essere che vedi elementi dell’immagine che non erano visibili (o prominenti) quando l’hai catturata.

Per esempio, ecco un’immagine che è stata catturata grezza.

Ecco uno screengrab di essa compressa con H.264, usando le impostazioni standard raccomandate da YouTube.

E poi compressa con DNxHD 350x:

Sono tutte più o meno uguali, no? La qualità visiva è circa la stessa, e il file H.264 è una frazione della dimensione del file DNxHD. Questo è il motivo per cui è l’impostazione raccomandata per YouTube. Sembra altrettanto buono all’occhio, e il file è molto più facile da caricare su internet.

Il problema con la versione H.264, tuttavia, arriva quando si cerca di apportare modifiche all’immagine. E se si volesse aumentare l’esposizione?

Ora possiamo vedere dove l’immagine altamente compressa cade a pezzi. I suoi capelli e la sua camicia hanno un aspetto terribile nell’immagine h.264, e gli edifici vicino al fiume sembrano tutti mollicci.

Ecco perché vuoi davvero un codec di alta qualità quando catturi l’immagine. Perché probabilmente vorrete fare dei cambiamenti in seguito, ma non sapete ancora quali potrebbero essere questi cambiamenti. Vorrai modificare il colore e il contrasto, forse modificare la velocità, forse aggiungere qualche VFX. Un file altamente compresso non permette questi cambiamenti senza rompersi.

Questo è il motivo per cui è una buona idea catturare le tue riprese a 10 bit anche se alla fine potresti produrre un file a 8 bit. Non sai, quando giri, quali bit vorrai.

Il viaggio del codec

Ora è il momento di camminare attraverso le diverse fasi che incontrerai in ogni progetto.

Ogni progetto inizia con un codec che catturi nella telecamera. E finisce con un codec che si esporta (delivery codec) e si consegna al cliente o si carica sul web. Nel caso più semplice, fai tutto il tuo editing e la correzione del colore direttamente sui file della telecamera. Poi esporti nel tuo codec di consegna, così usi sempre e solo due codec.

Ma la maggior parte delle volte diventa un po’ più complicato. Potresti transcodificare in un codec diverso per l’editing, e potenzialmente per la correzione del colore, e sicuramente per i VFX. Ma tutto inizia con…

Il codec con cui giri

(torna all’indice)

Questo è il tuo codec di acquisizione, (chiamato anche “codec nativo della telecamera” o “codec di acquisizione”).

In generale, dovresti puntare al codec di più alta qualità che la tua telecamera (o il tuo budget) può acquisire. Quando dico “massima qualità”, voglio dire che volete catturare più informazioni possibili. Quindi vuoi codec con meno perdite: meno compressione, maggiore profondità di bit e meno sottocampionamento del croma. Più informazioni hai quando catturi, più flessibilità avrai in seguito. Specialmente nella correzione del colore e nei VFX (se lo stai facendo).

Ovviamente, devi anche considerare un sacco di altri fattori pratici in questa decisione. Altrimenti gireremmo sempre in 8K raw, giusto?

Costo

La prima considerazione è ovviamente il costo. In generale, più costosa è la telecamera, più alta è la qualità dei codec disponibili su di essa. Dico in generale perché ci sono alcune telecamere “sweet spot” che possono offrire codec eccellenti ad un prezzo ragionevole. La serie GH di Panasonic (specialmente all’inizio, quando la GH2 è stata hackerata) era nota per offrire codec migliori delle altre fotocamere della sua fascia di prezzo.

Suggerimento: Codec migliori con registratori esterni

Un modo per catturare codec di qualità superiore su fotocamere più economiche è quello di utilizzare un registratore esterno.

Questi dispositivi (molti dei quali possono fungere anche da monitor esterni) prendono un segnale non compresso dalla fotocamera, via HDMI o SDI, e lo comprimono separatamente. Così ti ritrovi con due copie del tuo filmato. Una copia fortemente compressa sulla videocamera, e una seconda copia leggermente compressa sul registratore esterno. La cosa fondamentale qui è che la videocamera invia il segnale al registratore prima di comprimerlo.

Una nota importante qui è che molte videocamere più economiche emettono solo 8-bit, e spesso non in 4:4:4. Un registratore esterno potrebbe essere in grado di comprimere a un codec a 12 bit. Ma se la telecamera invia solo 8 bit, il registratore può registrare solo 8 bit. Alcune videocamere più economiche potrebbero anche non emettere un segnale HDMI “pulito” adatto alla registrazione. Chiamiamo un segnale di uscita “pulito” quando è solo l’immagine pura senza sovrapposizioni dell’interfaccia della telecamera.

Storage

Il secondo fattore da considerare è lo spazio di archiviazione. I codec di alta qualità tendono ad avere un bit-rate più alto, il che significa che i file sono più grandi. Devi essere preparato a memorizzare e fare il backup di tutti quei file mentre stai girando. E potresti anche dover aggiornare le tue schede di memoria per essere in grado di registrare i dati ad alto bitrate. Se stai girando da solo, allora potresti finire per scegliere un codec di qualità inferiore perché ti permette di cambiare le schede di memoria meno spesso.

Finitura

Un altro fattore da considerare è quanta correzione del colore e VFX (chiamati collettivamente finitura) hai intenzione di fare. Se hai intenzione di fare una minima correzione del colore e nessun VFX, allora puoi probabilmente cavartela con una minore profondità di bit, il sottocampionamento del croma e il blocco macro che vengono con codec di acquisizione di qualità inferiore.

Hardware di editing

L’ultimo fattore da considerare è la tua macchina di editing. La maggior parte dei codec di cattura non sono adatti all’editing senza un computer ad alte prestazioni. H.264 e alcuni file raw richiedono una CPU/GPU potente per un montaggio senza problemi. E i codec a bitrate molto elevato possono richiedere dischi rigidi ad alta velocità o server di dati. A meno che tu non stia girando un codec adatto all’editing, potresti dover transcodificare i tuoi file in un altro codec prima dell’editing. E questo può richiedere tempo. Per alcuni, la transcodifica del filmato non è un problema enorme perché può essere fatta durante la notte o su un computer di riserva. Se stai lavorando in tempi molto stretti, tuttavia, potresti scegliere un codec che ti permetta di iniziare l’editing subito dopo le riprese, anche se questo significa un costo maggiore o un sacrificio nella qualità dell’immagine. Spiegherò quali codec sono i migliori per l’editing nella prossima sezione.

Il Codec con cui editare

(torna all’indice)

Va bene, hai girato il tuo film, e hai tutti i tuoi file sul tuo computer. Ora devi decidere se vuoi montare con questi file. O se vuoi transcodificare in un altro formato.

Perché dovrei transcodificare prima del montaggio? Non posso semplicemente modificare i file usciti dalla fotocamera?

Beh, dipende. Praticamente tutti i principali pacchetti software possono ora modificare qualsiasi codec creato dalla tua fotocamera. (A meno che tu non sia un duro che scatta con una fotocamera nuova di zecca con una tecnologia nuova di zecca). Ma mentre è quasi sempre possibile modificare i codec che la tua fotocamera ha girato, non è sempre l’idea migliore.

Se sei abbastanza fortunato da girare con un codec che è ottimo per l’editing, puoi saltare questo passaggio.

Per molti di noi, tuttavia, il codec di acquisizione non sarà ottimizzato per l’editing. Ci sono due fattori principali che devi considerare quando scegli il tuo codec di editing: il tipo di compressione e il bit rate.

I codec altamente compressi possono rallentare il tuo editing

(torna all’indice)

La maggior parte delle telecamere di fascia medio-bassa registrano con codec che usano la compressione temporale, conosciuta anche come compressione long-GOP. Vi darò una semplice spiegazione qui, ma se siete interessati a saperne di più in dettaglio, guardate il mio video sui codec, a partire da 19:00.

La semplice spiegazione di un long-GOP è che, per ogni fotogramma, il codec cattura solo ciò che è cambiato tra questo e quello precedente. Se il video non include molto movimento, allora il nuovo file può essere molto più piccolo. La differenza tra questo fotogramma e l’ultimo è di pochi pixel. Quindi tutto quello che dovete memorizzare sono pochi pixel. È fantastico!

Sempre in avanti

Il problema, però, è che questi codec tendono a funzionare bene solo se riprodotti in avanti. (Se siete curiosi di sapere perché, date un’occhiata al video). Questo è ottimo per la visualizzazione su YouTube e il tuo lettore DVD, ma non è ottimo per l’editing. Quando stai montando stai spesso saltando in giro, o riproducendo una clip all’indietro. E ci vuole molta più potenza di elaborazione per fare queste cose velocemente con un codec long-GOP. Un computer di fascia alta potrebbe non avere problemi, ma anche un computer di fascia media avrà ritardi e balbettii quando scorri il filmato velocemente o salti in giro.

I codec che non sono long-GOP (cioè i codec intra-frame), possono riprodurre all’indietro altrettanto facilmente che in avanti. Quindi anche un computer di fascia media può saltare in giro in modo molto fluido. Se hai sempre editato clip direttamente dalla videocamera, potresti non renderti conto di cosa ti stai perdendo!

L’altra cosa che può causare problemi con la riproduzione è il video grezzo. Il video grezzo deve essere convertito prima di poter essere visualizzato (un po’ come fa un codec). E alcuni computer non possono decodificare il file raw abbastanza velocemente, specialmente se è 4K. Ironicamente, sia le videocamere di fascia bassa che quelle di fascia alta producono file difficili da modificare!

I codec ad alto bitrate possono rallentare il tuo montaggio

(torna all’indice)

Per i codec di fascia bassa e media, non devi preoccuparti affatto del bitrate. Una volta che inizi a salire di livello, tuttavia, i codec ad alto bitrate possono causare problemi con l’editing, specialmente se stai lavorando su computer comuni.

La ragione è che il tuo computer deve essere in grado di leggere i dati dal tuo disco rigido a un bitrate che sia almeno pari a quello del tuo codec. Ha senso – se il tuo codec è 50Mb/s (cinquanta megabit al secondo), allora il tuo computer deve essere in grado di leggere quel file dal tuo disco rigido a 50Mb/s o altrimenti rimarrà indietro e balbetterà.

(nota che Mb/s sta per megabit al secondo, mentre MB/s sta per megabyte al secondo. Ci sono otto bit in un byte, quindi è necessario moltiplicare per 8 quando si converte da MB/s a Mb/s)

Alcune buone notizie

La buona notizia è che gli hard disk stanno diventando sempre più veloci. Quindi 50Mb/s non causerà mai problemi. Ma cosa succede se stai montando ProRes 422HQ a 4K, che è 734Mb/s? L’hard disk esterno medio è a malapena abbastanza veloce per riprodurlo. Alcuni hard disk più economici non ci riusciranno affatto. E poi, cosa succede se stai montando una multicamera con tre telecamere? Improvvisamente hai bisogno del triplo della velocità di trasferimento dati: 2.202 Mb/s! A quel punto, dovrai investire in alcuni dischi rigidi ad alte prestazioni o in RAID.

Queste sono alcune linee guida approssimative per le comuni velocità di archiviazione dei dati. (Ci saranno sempre alcuni modelli che sottoperformano o sovraperformano.)

- Drive a rotazione standard: 100-120MB/s

- Unità a rotazione professionale: 150-200MB/s

- SD standard: 400-500 MB/s

- RAID di fascia bassa: 200-300 MB/s

- RAID di fascia alta: 1000-2000 MB/s

Scattare in log può rallentare l’editing

Scattare in log è un modo per preservare il più possibile la gamma dinamica. Questo permette di ottenere una scena con luci brillanti e ombre scure senza far esplodere le luci o schiacciare i neri. Le luci soffiate sono un effetto collaterale particolarmente brutto delle riprese su video invece che su pellicola. Quindi girare in log può aiutare a rendere il tuo filmato più cinematografico. Ora che i profili log sono disponibili anche sulla maggior parte delle videocamere prosumer, è un modo estremamente popolare di lavorare.

Il lato negativo

Il lato negativo è che l’immagine che esce dalla videocamera non è così bella. Avrai bisogno di aggiungere contrasto e saturazione per avvicinarti anche solo all’immagine finale. Il modo più comune per farlo è aggiungere una LUT al tuo filmato. Questa è essenzialmente una semplice correzione del colore preimpostata che riporta il tuo filmato a un aspetto “normale”.

Se stai girando in uno spazio colore log, allora devi applicare una LUT al tuo filmato per poterlo visualizzare in anteprima con colore e contrasto normali. Questo significa che il tuo editor dovrà applicare la LUT appropriata a tutte le clip durante l’editing. Questo può essere fastidioso da gestire e può anche rallentare un po’ il computer. Questo perché deve prima decodificare ogni fotogramma e poi applicare la LUT prima di visualizzarlo. È certamente possibile modificare il filmato di log senza alcuna LUT, ma non è l’ideale. Il colore di due inquadrature può influenzare il modo in cui le intercalibri.

Se hai intenzione di transcodificare i tuoi file prima di montarli, allora puoi applicare la LUT durante il processo di transcodifica. In questo modo, l’editor lavora sempre con filmati che hanno un buon contrasto e colore e non deve mai preoccuparsi delle LUT. Nota che dovresti farlo solo se stai usando un flusso di lavoro Proxy, non un flusso di lavoro Direct Intermediate (descritto sotto).

Considera il tempo speso per la codifica

Il principale svantaggio della transcodifica del tuo filmato prima del montaggio è semplicemente il tempo necessario per fare la transcodifica. Se hai un sacco di filmati da analizzare e il tuo computer non è veloce, potrebbe volerci molto tempo. Se non hai molta fretta, puoi lasciare che il transcode venga eseguito durante la notte, potenzialmente su più computer se hai accesso ad essi, ma questo non è sempre l’ideale.

Quando lavoravo alla Khan Academy, il nostro fondatore registrava regolarmente brevi messaggi video da inviare alle persone. Che spesso avevano dei tempi molto stretti. Di solito giravo in 4K in un formato di registro Long-GOP e li montavo su un MacBook Pro. L’editing di 4K long-GOP con una LUT (per correggere le riprese di log) su un laptop significava che potevo riprodurre il video senza problemi in Premiere Pro, ma non potevo zoomare sulla timeline alla velocità che volevo senza stuttering.

Ma questo non mi preoccupava troppo perché il montaggio era estremamente semplice. Solo alcuni tagli, forse un po’ di musica, un titolo, e avevo finito. Anche se la mia velocità di montaggio non era ideale, avrei speso più tempo nella transcodifica di quanto avrei risparmiato in velocità di montaggio, quindi ho semplicemente usato i file originali.

Se dovessi montare un pezzo più lungo con la stessa configurazione, comunque, farei la transcodifica in DNxHD o ProRes. Generalmente, farei la maggior parte della transcodifica durante la notte, spesso con più macchine in esecuzione allo stesso tempo.

Proxy Edit

(torna all’indice)

Se hai intenzione di transcodificare i file nativi della telecamera prima di montarli, allora userai un codec “intermedio”. Si chiama intermedio perché si trova tra il codec di cattura e quello di esportazione. Ci sono due modi comuni di lavorare con i codec intermedi:

Il primo è il flusso di lavoro “proxy” o “modifica offline”. Questo significa che stai transcodificando il tuo filmato catturato in un formato intermedio, editando con quel formato, e poi ricollegandoti ai file originali della telecamera prima di esportare. Poiché userai i file della videocamera per esportare e non i file proxy, non hai bisogno di preoccuparti tanto di scegliere un codec proxy con una grande qualità d’immagine – i codec lossy vanno bene. Puoi invece ottimizzare per la velocità di editing e la comodità di archiviazione.

Il flusso di lavoro proxy è così comune che molte telecamere di fascia alta registrano un file raw *e* un file proxy ProRes o DNxHD allo stesso tempo. Dopo le riprese, i file raw vengono salvati e messi in deposito. I file proxy vengono inviati ai montatori e al regista/produttore per i giornalieri.

Evitare la compressione temporale

Quando si sceglie un codec proxy, è bene sceglierne uno che non utilizzi la compressione temporale (ovvero la compressione inter-frame o la compressione long-GOP), e sceglierne uno che abbia un bitrate più basso. Il basso bitrate significa che i file sono molto più piccoli, quindi puoi usare meno/più piccoli/più economici hard disk, semplificando il tuo flusso di lavoro. Woot!

Mentre i file proxy sono ottimi per l’editing, non dovresti fare più della correzione del colore di base con i file proxy. Se hai intenzione di fare tutta la tua correzione del colore all’interno del tuo software di editing, allora è meglio ricollegarsi ai file della fotocamera perché i file proxy possono avere una qualità del colore inferiore.

La buona notizia è che la maggior parte dei software di editing oggi può passare tra i file della fotocamera e i file proxy in appena un paio di clic, quindi puoi anche andare avanti e indietro se ne hai bisogno.

Abbiamo pubblicato guide dettagliate per i flussi di lavoro proxy in ciascuno dei principali NLE:

- Final Cut Pro X Proxy Workflows

- Premiere Pro Proxy Workflows

- Avid Media Composer Proxy Workflows

Alcune buone scelte per i codec proxy

I codec proxy più comuni sono DNxHD/DNxHR e ProRes. Sono entrambi in giro da anni, quindi sono ampiamente supportati. Tutti sanno come gestirli. Sono entrambi molto adatti a un flusso di lavoro proxy (ProRes ha persino un preset chiamato “proxy”), e sono quasi intercambiabili quando vengono usati per i proxy.

DNxHD è prodotto da Avid, e ProRes è prodotto da Apple. Quindi ha senso che DNxHD funzioni meglio su Media Composer e ProRes meglio su Final Cut Pro X. Questo era certamente vero, ma oggi entrambi i codec funzionano molto bene su tutti gli editor moderni (incluso Premiere Pro). Ci può essere un leggero aumento di velocità nell’usare il codec che è stato progettato per il sistema, ma è molto leggero.

L’unica differenza significativa tra i due per un flusso di lavoro proxy è il fatto che potresti avere problemi a creare ProRes su un PC, mentre DNxHD è molto facile da creare cross-platform. L’unico modo ufficialmente supportato per creare ProRes su un PC è con Assimilate Scratch. Ci sono alcuni altri metodi non supportati per creare file ProRes su un PC, ma non sono sempre affidabili. I PC possono facilmente riprodurre e modificare i file ProRes, ma non è possibile codificare nuovi file ProRes su un PC con la stessa facilità del DNxHD, e quindi alcuni editor preferiscono un flusso di lavoro DNxHD per questa ragione.

Scegli una corsia

A prescindere da quale dei due codec scegli, devi anche scegliere quale gusto vuoi. Questo dipenderà davvero dai tuoi vincoli di memorizzazione – è un compromesso tra qualità dell’immagine e dimensione del file. La buona notizia è che non hai bisogno di una qualità dell’immagine al top quando fai l’editing, quindi puoi scegliere un codec a basso bitrate.

Inizia con il più piccolo codec ProRes o DNx nella stessa risoluzione del tuo codec di acquisizione. Guarda la colonna GB/hr e moltiplicala per il numero di ore di filmati che hai. Se hai abbastanza spazio di archiviazione, allora sei a posto – usa quel codec. Se hai un sacco di spazio di archiviazione extra, pensa a usare il prossimo più grande.

Ma se non hai abbastanza spazio di archiviazione, o se sei su una macchina poco potente, allora abbassa la risoluzione di una tacca. Un sacco di film hollywoodiani ad alto budget sono stati montati a 480p solo pochi anni fa, quindi non preoccuparti se hai bisogno di abbassare la risoluzione da 4K a 720P per il montaggio.

Direct Intermediate

L’altro tipo di flusso di lavoro intermedio è qualcosa che io chiamo Direct Intermediate. Questo significa che si transcodificano i file della videocamera in un codec che è sia buono per l’editing che di alta qualità (non molto dispersivo). Poiché il codec è di alta qualità, quasi tutte le informazioni originali dei file della videocamera sono state conservate, e quindi non è necessario ricollegarsi ai file della videocamera – si può semplicemente esportare direttamente dai file intermedi. Ci sarà una certa perdita teorica di informazioni quando transcodifichi, ma se scegli un codec intermedio abbastanza buono, sarà abbastanza piccola da non dovertene preoccupare.

(Nota: sto chiamando questo processo “Direct Intermediate” perché non esiste un nome comune per questo flusso di lavoro. La gente di solito lo chiama semplicemente “intermedio”, ma questo può confondere perché anche i flussi di lavoro proxy sono un tipo di flusso di lavoro intermedio. Alcune persone lo chiamano anche flusso di lavoro “online”, ma anche questo è confuso perché quel termine è stato creato per descrivere un flusso di lavoro che include una modifica offline e una online, non un flusso di lavoro che è online dall’inizio alla fine.

La conservazione è la chiave

La chiave per scegliere un buon codec Direct Intermediate è assicurarsi di conservare tutte le informazioni dal tuo codec di acquisizione. Un codec intermedio non renderà mai le tue immagini migliori (spiegazione più dettagliata qui sotto), ma può sicuramente peggiorarle se scegli il codec sbagliato. L’importante è capire i dettagli del tuo filmato originale e assicurarsi che il tuo codec intermedio sia almeno buono come il tuo codec di acquisizione in ogni area. Se catturi le tue riprese con una DSLR come una Sony A7Sii a 4K, allora registrerai in un codec 4:2:0, 8-bit, Long-GOP a 100Mbps. Vuoi un codec intermedio che sia almeno 4:2:0 e 8-bit. Andare oltre questi valori (per esempio a 4:4:4 e 12-bit) non farà male, ma non aiuterà affatto. Quindi probabilmente non vale la pena di perdere spazio di memoria extra.

Diciamo, per esempio, che vogliamo andare con un codec ProRes. Abbiamo 4 opzioni tra cui scegliere che sono 4:2:2 e 10-bit.

- 145Mb/s ProRes 422 Proxy

- 328Mb/s ProRes 422 LT

- 471Mb/s ProRes 422

- 707Mb/s ProRes 422 HQ

Oltre e oltre

Potresti pensare che tutto ciò di cui hai bisogno è eguagliare il bitrate della telecamera (100Mbps), ma in realtà è necessario superare di molto il bitrate della telecamera. Questo perché h.264 è un codec molto più efficiente di ProRes. Poiché h.264 utilizza la compressione Long-GOP, può impacchettare molte più informazioni in quei 100 megabit rispetto a ProRes. Affinché ProRes possa eguagliare la qualità dell’immagine di h.264, è necessario un bitrate molto più alto. Raccomanderei di usare solo ProRes 422 o ProRes 422 HQ se stai iniziando con un codec h.264 da 100 Mbps. ProRes 422 probabilmente andrà bene, ma se hai molto spazio di archiviazione, allora salire a ProRes 422 HQ avrà un leggero vantaggio.

Mentre va bene abbinare semplicemente la profondità di bit e il campionamento del colore quando si sceglie un intermedio, si dovrebbe sempre aumentare il bitrate almeno un po’. Se stai passando da un codec GOP lungo a un codec non GOP lungo, allora dovresti aumentare molto il bitrate.

Nota a margine: se volessi usare DNxHD invece di ProRes, hai opzioni simili, tranne che DNxHD offre anche una versione a 8 bit per i codec di fascia bassa. Dato che il nostro filmato è a 8 bit per cominciare, questo non ci danneggerà affatto.

Il flusso di lavoro proxy sembra abbastanza buono. Perché fare il Direct Intermediate?

Parte della ragione per cui il flusso di lavoro Direct Intermediate è comune è perché una volta era molto più difficile usare un flusso di lavoro proxy. Alcuni dei principali fornitori di software non rendevano particolarmente facile ricollegarsi ai file originali della fotocamera, e quindi le persone sceglievano un flusso di lavoro intermedio diretto. Al giorno d’oggi, tuttavia, è abbastanza facile da fare in qualsiasi pacchetto di editing. L’eccezione principale è quando si hanno molti tipi di filmati misti. Se hai più frame rate e frame size nello stesso progetto, passare avanti e indietro dai proxy ai codec di cattura può essere un mal di testa.

Se stai usando alcuni strumenti di terze parti per aiutare a preparare e organizzare le tue riprese prima di iniziare a tagliare, questi possono anche rendere il processo di ricollegamento più difficile. Un esempio comune potrebbe essere il software che sincronizza automaticamente le tracce audio o le riprese multicamera.

Nessuno scambio richiesto

Un’altra ragione per cui potresti voler usare un flusso di lavoro Direct Intermediate è perché puoi passare direttamente alla correzione del colore e al processo VFX (“finitura”) senza scambiare alcun file. Continua a leggere e ti spiegherò meglio perché questo è conveniente nelle sezioni Correzione del colore e VFX.

Un aspetto negativo, tuttavia, è che non puoi “cuocere” le LUT per il tuo editor – avrai bisogno di applicare una LUT tramite un effetto di correzione del colore nel tuo software di editing. Se tu dovessi includere il LUT nel tuo transcodice per il flusso di lavoro Direct Intermediate, perderesti tutti i benefici della registrazione in log in primo luogo.

L’altro ovvio svantaggio è che hai bisogno di memorizzare tutti questi file (molto più grandi).

Un codec intermedio non renderà mai le tue immagini migliori

(torna all’indice)

Questo è molto importante, perché è molto comunemente incompreso, e c’è molta disinformazione online. La transcodifica del filmato prima del montaggio non aumenterà mai la qualità dell’output. Ci sono alcune operazioni extra che potresti fare nel processo di transcodifica (come usare sofisticati strumenti di up-res) che potrebbero aumentare la qualità dell’immagine in alcuni casi, ma un nuovo codec da solo non aumenterà mai la qualità della tua immagine.

Se scegli il codec giusto, puoi evitare di danneggiare la tua immagine, ma non potrai mai migliorarla.

Questo include passare da h.264 a DNxHD o ProRes. Include anche passare da 8-bit a 10-bit. E passare da 4:2:0 a 4:4:4.

Ecco un’illustrazione che può aiutare a capire questo concetto:

Questa è una foto di una rosa riflessa in una goccia d’acqua. Sono 4 megapixel, e sembra abbastanza bella sul mio monitor da 27 pollici.

Ora cosa succede se faccio una foto del mio monitor con una fotocamera Red Helium 8k. Questa è una bestia di macchina fotografica. Ho scattato la foto della rosa qualche anno fa con una Canon Rebel DSLR economica, che oggi vale circa 250 dollari. La configurazione Red Helium costa circa 50.000 dollari, ha 35 megapixel, è grezza, ha uno dei migliori sensori di fotocamera mai prodotti.

Quale sarà un’immagine migliore – la foto a 4 megapixel o quella a 35 megapixel?

La cattura di una cattura

La fotocamera Red ha più megapixel, giusto? È raw, e ha tutta la magia digitale Red, giusto? Ma poiché sto usando la mia fotocamera ad alta risoluzione per scattare una foto della foto, non una foto della rosa, la mia nuova immagine di fantasia non sarà mai migliore della prima. Ho un file che è tecnicamente ad alta risoluzione, ma non cattura più del mio soggetto (la rosa) di quanto non facesse il primo.

Questo è quello che stai facendo quando stai transcodificando. Stai facendo una copia di una copia, facendo una foto di una foto. Se usi una fantastica macchina fotografica ad alta risoluzione per fare la foto di una foto, sarai in grado di preservare praticamente tutte le informazioni dell’immagine originale, ma non sarai in grado di aggiungere altro.

Il grande avvertimento è che, se stai facendo una qualsiasi elaborazione, una qualsiasi trasformazione dell’immagine (aggiungendo una LUT, per esempio), allora sicuramente vuoi transcodificare in un codec di qualità superiore, che manterrà nuove informazioni. Ma se non stai alterando l’immagine, allora la transcodifica non renderà la tua immagine in qualche modo “migliore”.

Un esempio del mondo reale

(torna all’indice)

Diciamo che stai montando un documentario che ha catturato filmati 4K usando una telecamera Sony A7sii, che registra nella versione a lungo GOP di XAVC-S. Non è l’ideale per l’editing. Se hanno girato 40 ore di filmati per il tuo documentario lungometraggio, ti ritroveresti con circa 2,7 TB di file della telecamera, che possono stare facilmente su un disco rigido (anche se hai fatto altri backup separati, ovviamente!).

Si potrebbe convertire il tutto in un codec di alta qualità e non troppo pesante per un flusso di lavoro Direct Intermediate, forse ProRes 422 HQ in 4K.

Il lato negativo è che avresti bisogno di circa 12,7TB per memorizzare tutti quei file ProRes. Dovresti usare una costosa configurazione RAID per avere facile accesso a tutti quei filmati in un progetto, almeno 1.000 dollari. Noccioline per una grande struttura, ma un investimento significativo per un editor solitario.

Scegliere il proxy

Perciò potresti decidere di usare un flusso di lavoro Proxy e transcodificare i tuoi file nel formato ProRes 422 Proxy 4K. Allora il tuo filmato occuperebbe solo 2,8 TB, appena più del tuo filmato catturato. Potrai quindi modificare facilmente da un singolo disco rigido e il tuo flusso di lavoro sarà molto più semplice. (Per le istruzioni su come calcolare bitrate e dimensioni dei file, dai un’occhiata a questo articolo: La semplice formula per calcolare i bitrate video).

Diciamo che stai lavorando con un altro editor che si trova dall’altra parte del paese. Potresti decidere di transcodificare il filmato ancora più in basso in ProRes 422 Proxy HD, che ridurrebbe il tuo filmato a soli 640GB, che diventa più fattibile da inviare su Internet se hai una connessione veloce. (18 ore per scaricare su una connessione a 80Mbps)

Quando il montaggio è finito, basta ricollegare il progetto ai file originali della telecamera ed esportare. Anche se tu e il tuo editor remoto avete lavorato in un codec con molte perdite, l’esportazione finale lo bypassa, quindi non perdete nessuna qualità.

Il Codec che corregge il colore

(torna all’indice)

Ok, ora hai il tuo video montato, ed è il momento della correzione del colore. Tutto ciò di cui stiamo parlando qui si applica sia che tu stia correggendo il colore all’interno della tua applicazione di editing, sia che tu stia inviando il tuo montaggio a un software di correzione del colore dedicato.

La grande domanda a questo punto è se vuoi correggere il colore direttamente sui file originali della telecamera, o se vuoi transcodificare. Se hai fatto una modifica proxy/offline, allora sicuramente non vuoi correggere il colore dei file proxy, perché hanno una qualità d’immagine inferiore. Per prendere buone decisioni sul colore, hai bisogno dell’immagine di più alta qualità che hai a disposizione, perché devi essere in grado di vedere esattamente con cosa devi lavorare.

Quindi abbiamo bisogno di lavorare con immagini di alta qualità, e abbiamo alcune opzioni diverse:

A. Classificare i file della fotocamera

Questa è certamente un’opzione semplice. Se hai fatto una modifica proxy, puoi ricollegarti ai file della fotocamera per il processo di finitura e andare in città. Questo ti darà la massima qualità dell’immagine, ma ricordi come i file della fotocamera possono essere lenti da lavorare? I file della videocamera possono rallentare un po’ il processo, ma a seconda del software che usi e della quantità di lavoro che devi fare, potresti decidere che la semplicità vale un po’ di potenziale rallentamento. Se hai un breve montaggio senza molta complessità, allora questo può essere un grande e facile flusso di lavoro.

Assumiamo che il rallentamento della correzione del colore ti dia fastidio, quindi hai bisogno di un codec che sia più facile da usare. Potresti transcodificare tutti i tuoi filmati in un codec di alta qualità, collegarti a quei file e poi iniziare a fare la tua correzione del colore. Ma… questo vanifica lo scopo di un flusso di lavoro proxy, no? Abbiamo usato i proxy perché non volevamo avere a che fare con i grandi file che avrebbero creato. Fortunatamente, c’è un’altra opzione.

B. Consolidare e transcodificare

(torna all’indice)

Se hai usato un flusso di lavoro proxy/offline per l’editing ma non vuoi correggere il colore dei file della telecamera, una buona opzione è quella di ricollegarsi ai file della telecamera, consolidare il progetto e poi transcodificare su un codec di fascia alta.

Quando consolidi un progetto, il tuo software di editing farà una copia del tuo progetto insieme a una copia dei media, ma solo i file particolari che hai finito per usare nella tua sequenza. Quindi, se hai girato 7 riprese ma ne hai usata solo una nel montaggio, copierà solo quella ripresa. Questo riduce molto l’archiviazione, il che è utile in questa fase. Puoi anche consolidare ulteriormente in modo da conservare solo le porzioni specifiche di ogni ripresa che hai effettivamente usato nel montaggio, scartando il resto. In questo caso, il software di solito include alcuni secondi prima e dopo ogni ripresa (chiamati “handle”), nel caso tu voglia aggiungere una dissolvenza o il motion tracking.

Inizia il tuo grado

Ora puoi prendere questo nuovo progetto consolidato (dopo esserti ricollegato agli originali) e transcodificare tutti questi file in un codec ad alta qualità e bitrate, e iniziare la correzione del colore. Questo è diverso dal flusso di lavoro Direct Intermediate perché non stai transcodificando tutto il tuo footage – solo il footage che è entrato nel montaggio finale, che potrebbe essere 1/20 o 1/50 della lunghezza del footage che hai originariamente girato. Ora non sembra così male transcodificare in un codec ad alto bitrate perché non devi memorizzarne così tanto. Anche a ProRes 4444 4K, un lungometraggio sarà solo circa 2TB – abbastanza gestibile.

Ora puoi finire il tuo film con immagini di alta qualità e un’elaborazione veloce, su un disco rigido che sta in tasca. Woot!

C. Continuare con il Direct Intermediate

La terza opzione è quella di andare con il flusso di lavoro di editing Direct Intermediate, nel qual caso sei a posto. Hai già transcodificato tutti i tuoi file in un codec di alta qualità prima di iniziare l’editing, quindi puoi semplicemente continuare con quegli stessi file per la correzione del colore. Questo è anche conveniente perché quei file sono buoni sia per l’editing che per la correzione del colore e i VFX (vedi sotto).

Se stai consegnando il progetto a un colorista esterno o a una persona VFX, allora puoi dargli tutti i tuoi filmati di alta qualità (potenzialmente fastidiosi a causa delle dimensioni), oppure puoi usare lo stesso suggerimento di consolidamento che abbiamo usato sopra. Consegnare il progetto consolidato può aiutarti a muoverti più velocemente e a risparmiare anche il tempo del tuo colorista.

Un altro vantaggio

Oltre alla semplicità del flusso di lavoro Direct Intermediate (usi solo un set di file), hai un altro vantaggio: andare avanti e indietro tra il montaggio e la correzione del colore è più semplice.

Immagina di aver finito il tuo editing proxy – consolidi e transcodifichi, lo mandi al tuo colorista, e poi decidi che hai bisogno di fare alcune modifiche all’editing. Ora devi tornare ai proxy per fare la modifica e poi riconsolidare e inviare nuovamente il filmato. La meccanica di tutto ciò può diventare piuttosto incasinata. In un flusso di lavoro di post-produzione di alto livello, di solito c’è un “blocco” sul montaggio in modo che i processi di finitura possano iniziare. Questo significa che (a meno che non succedano brutte cose) cercherai con tutte le tue forze di non tornare indietro e fare modifiche al montaggio. Ma ehi, le cose brutte accadono, quindi è meglio essere preparati.

E ora troviamo un’altra buona ragione per una modifica intermedia diretta. Se hai intenzione di fare parte del tuo lavoro a colori e del tuo lavoro di editing simultaneamente, o almeno hai intenzione di andare avanti e indietro un paio di volte, allora può essere più semplice usare un codec per entrambi. Questo è particolarmente conveniente se stai facendo l’editing e la finitura nello stesso pacchetto software (o set di pacchetti, ad esempio Creative Cloud).

Il Codec che mandi a VFX

(torna all’indice)

Se stai facendo del lavoro VFX, allora probabilmente avrai bisogno di mandare i file ad un altro programma (potenzialmente un’altra macchina, per un altro artista). Se stai facendo tutto il tuo lavoro VFX nel tuo editor (che sta diventando sempre più fattibile per lavori semplici), allora puoi saltare questa sezione. Basta usare lo stesso codec che hai usato per la tua correzione del colore.

Per la maggior parte di noi, comunque, abbiamo bisogno di impostare un processo “round-trip” che mandi le clip dall’editor al software VFX e poi di nuovo indietro quando sono finite. Questo avviene colpo per colpo, quindi non stai inviando l’intera sequenza ai VFX, come probabilmente hai fatto per il color grading. La questione di quando nel processo invii le tue riprese ai VFX dipende molto dal particolare flusso di lavoro.

Alcune persone inviano ai VFX dopo che il montaggio è bloccato e la correzione del colore finita, ma la pressione del tempo può costringerti a iniziare a inviare le riprese prima di allora.

Se stai montando in Premiere Pro e facendo VFX leggeri in After Effects con Dynamic Link, allora puoi anche saltare questa sezione. Dynamic Link fa automaticamente il round-tripping per voi. Se state facendo molto lavoro VFX, potreste comunque voler usare le tecniche in questa sezione, perché Dynamic Link può essere un po’ schizzinoso con troppi progetti. Adobe sta sempre lavorando su questi bug, comunque, e quindi dipende in parte dal gusto personale.

Go big or go home

Nel processo VFX, si tende ad usare codec molto high-end (bitrate elevato) per due ragioni principali. La prima è semplicemente che gli artisti VFX hanno bisogno di tutte le informazioni che si possono dare loro per fare bene il loro lavoro. Gli artisti VFX sono alcune delle persone più esigenti quando si tratta di codec, e per una buona ragione. Tutti vogliono immagini di alta qualità, ma i problemi di immagine possono spesso rappresentare un problema maggiore per i VFX rispetto all’editing, alla correzione del colore e all’esportazione finale.

Molti compiti nel lavoro VFX richiedono un’analisi molto dettagliata dell’immagine a livello pixel per pixel, cosa che la maggior parte degli editor non ha mai bisogno di fare. Per esempio, se stai facendo un’estrazione dal green-screen, vuoi che il bordo tra il tuo personaggio e il greenscreen sia il più pulito possibile. Abbiamo tutti visto delle orribili riprese con il green screen in cui i bordi del personaggio sono tutti spezzati o sfocati. Questi problemi sorgono spesso a causa di artefatti di compressione dell’immagine che sono invisibili a occhio nudo. Il sottocampionamento dei colori 4:2:2 o 4:2:0, per esempio, non ha quasi nessun impatto visibile sull’immagine. L’occhio umano si preoccupa principalmente del contrasto e raramente nota una bassa risoluzione del colore, ma il processo di estrazione del greenscreen si basa principalmente sui valori del colore. Se il codec ha buttato via una grande porzione dei valori di colore usando il sottocampionamento 4:2:0, una buona chiave di colore può essere impossibile.

Perdita di generazione

La seconda ragione per cui vuoi usare codec di fascia alta è per la perdita di generazione. Nel processo VFX, probabilmente dovrai comprimere il tuo file più volte. Comprimerete il file una volta quando lo invierete a loro. E poi, se hanno bisogno di passare il file tra più specialisti, potrebbero comprimere quel file due o tre volte prima di rimandarlo indietro. Quando un file viene compresso più volte, lo chiamiamo perdita di generazione multipla.

Se state usando un codec di fascia bassa, l’immagine peggiorerà progressivamente ogni volta che la ricomprimete. Una delle grandi cose dei codec davvero di alta qualità è che puoi comprimerli un paio di volte senza perdere molta qualità. Mentre è sempre meglio evitare di comprimere un video più volte, se stai usando codec di alta qualità, di solito sei abbastanza a posto.

Alcuni flussi di lavoro VFX di fascia alta useranno solo la compressione lossless per questa ragione. La buona notizia è che le tue riprese VFX sono di solito solo pochi secondi per clip, il che significa che le dimensioni dei tuoi file saranno piccole anche con i codec di fascia alta. Quindi, andate in grande! Se hai catturato il 4:4:4 nella telecamera, allora manda sicuramente il 4:4:4 ai VFX. Altrimenti, sceglierei un codec 4:2:2 top di gamma (ProRes 422 HQ o DNxHQX).

E naturalmente, dovresti sempre comunicare in anticipo con i VFX su quale codec inviare. Se pensi che stiano facendo una scelta sbagliata, manda loro questo articolo 🙂

Il Codec che si esporta

(torna all’indice)

Ora che hai finito il montaggio, il colore e i VFX – sei pronto per esportare. Di solito farai l’esportazione finale dal software che hai usato per la correzione del colore, usando il codec che hai usato nel processo di correzione del colore.

Se il tuo cliente è nel business dei media, dovrebbe sapere quale codec vuole, quindi puoi saltare il resto di questa sezione!

Se il vostro cliente non è un esperto di video, potrebbe non sapere cosa vuole, quindi dovete prendere alcune decisioni per loro. La maggior parte delle volte, il vostro cliente vorrà un video da caricare su YouTube e/o altri siti di social media. Potreste essere tentati di scegliere un codec che sia buono per lo streaming su Internet. Ma vi sbagliereste!

Il motivo: questi siti non trasmettono lo stesso file che caricate ai vostri spettatori – comprimono il file *di nuovo* prima di trasmetterlo, e voi non avete assolutamente alcun controllo sulle impostazioni che usano. Questo significa che, se caricate un codec di bassa qualità, allora abbiamo lo scenario in cui stiamo facendo una foto di bassa qualità di una foto di bassa qualità di cui abbiamo parlato. Cattivo! Evitare!

Per ottenere la migliore qualità

Come regola generale, se vuoi un risultato di qualità migliore, dovresti caricare la fonte di qualità migliore. Comprimeranno di nuovo comunque, quindi dargli più dati con cui lavorare non può far male, giusto? Se hai una connessione abbastanza veloce, potresti caricare un ProRes 422. Alcune persone hanno riportato risultati leggermente (solo leggermente) migliori caricando ProRes invece del raccomandato h.264.

Se stai consegnando un file a un cliente, per caricarlo su Youtube, allora non gli darei ProRes, poiché non sai che tipo di larghezza di banda avranno. Fortunatamente, questi siti tendono a pubblicare specifiche di caricamento raccomandate (basta cercare su Google). Personalmente prenderò qualsiasi bitrate raccomandato e lo moltiplicherò per circa 1,5x a 2x.

Il tuo cliente potrebbe anche volere un file che possono incorporare direttamente nel loro sito web (anche se li dissuaderei, se puoi). In generale, si vuole un h.264 molto compresso. Se sei curioso di sapere qual è un buon bitrate, il mio ragionamento è che, se qualcuno sa qual è il bitrate sweet-spot, è YouTube. Periodicamente scarico un video da YouTube e controllo il suo bitrate, e lo uso come punto di riferimento.

Andare in piccolo

Se il video non è pubblico, potrebbero anche volere un piccolo file che possono inviare per e-mail o collegare direttamente ai loro client in modo che possano scaricarlo. In questi casi, può essere opportuno consegnare più di due file separati, specialmente se si tratta di un video lungo. Il file che dovrebbero caricare su YouTube sarà troppo grande per essere inviato via email in modo conveniente. In questo caso, di solito faccio un down-res del file e lo comprimo molto pesantemente. Devi anche essere realistico e decidere se pensi che il tuo cliente capirà effettivamente la differenza tra i due file.

Se devo consegnare più di un file, di solito chiamo uno di essi “HD” nel nome del file e l’altro “piccolo” o “non HD” nel nome del file. Se provate a descrivere loro i diversi codec, posso quasi garantire che avranno dimenticato la differenza entro la prossima settimana, ma probabilmente ricorderanno cosa significa HD e “non HD”.

Il Codec che archivi

(torna all’indice)

Hai consegnato i file al tuo cliente, quindi ora puoi sederti e rilassarti… quasi.

Come ogni professionista di questo settore sa, il giorno in cui consegni il prodotto finito al tuo cliente spesso non è l’ultima volta che tocchi un progetto. A volte un cliente vuole tornare indietro e cambiare qualcosa settimane dopo, o vuole un codec di qualità superiore, o forse vuoi aggiungerlo al tuo reel personale. In ognuno di questi casi, potresti essere passato a una macchina diversa o a un software diverso, rendendoti un mal di testa aprire il progetto originale e riesportarlo.

Questo è comodo

Ecco dove è utile avere un grande archivio del progetto finito in un codec di alta qualità. Se il tuo cliente ha richiesto un codec di alta qualità per la consegna, allora sei generalmente a posto. Tieni una copia di quel file e sei a posto. Se hanno bisogno di un codec per la consegna che non è di altissima qualità, tuttavia, è sempre bene fare la propria esportazione con un codec che sia lossless o il più vicino al lossless che ci si può permettere, dato lo spazio che occuperà. Generalmente esporto in un codec 4:4:4 ad alto bitrate – DNxHD/HR o ProRes.

Hai domande? Commentate pure.

In realtà ho letto ogni commento. Questo articolo è un lavoro in corso, e lo aggiornerò con più spiegazioni ed esempi basati sul vostro feedback. Se avete un feedback privato o delle domande, sparatemi una mail: david at frame dot io.

Vuoi scrivere per il blog di Frame.io? Mandami un’email: blog at frame dot io.

Molti ringraziamenti a Larry Jordan, Shane Ross, e Philip Hodgetts per il loro contributo a questo articolo!